CAPÍTULO 23

La luz, el calor, la electricidad

El siglo XVIII, al mismo tiempo que clasificaba el mundo natural e indagaba sobre su origen, topándose con la desesperación existencial que acarreaba el descubrimiento del tiempo profundo, no dejó de ocuparse de algunos fenómenos más terrenales, conocidos desde siempre (o casi), pero sobre cuya naturaleza no había una teoría firme. Es más: sobre los que no se sabía, en rigor, prácticamente nada, lo cual podía haber sido angustiante para los hombres de todas las épocas pero más aún para aquellos que vivían el momento posterior a la síntesis de la ciencia newtoniana con las ideas de la Ilustración, uno de cuyos efectos había sido la convicción de que todos los fenómenos podían y debían someterse a los rigores de una explicación racional.

No es casual, entonces, que muchos de los hombres de ciencia de la época se volcaran a analizar el calor, la luz y la electricidad, en una exploración que combinó fuertemente los estudios experimentales con la discusión y la especulación sobre la naturaleza de los fenómenos estudiados.

¿Qué eran, al fin y al cabo, el calor, la luz o la electricidad? Vamos a seguir los pasos de quienes intentaron averiguarlo.

LA LUZ: ONDAS O CORPÚSCULOS

La teoría corpuscular

No es raro que la luz haya sido concebida primero como un ente material: los griegos, al fin de cuentas, pensaban en rayos, que se prestaban para ser descompuestos en corpúsculos. Demócrito y Platón formularon las primeras teorías «granulares» de la luz, atribuyéndole una naturaleza material. Para Demócrito, en perfecta sintonía con su teoría atómica, la luz se componía de partículas que viajaban a velocidad finita —para que nos entendamos, cuando digo «finita» es por oposición a infinita, es decir, no infinita—, poseían diferentes formas y orientaciones, y se asociaban entre ellas dando lugar a los diferentes colores. Para Platón, las partículas luminosas eran macizas, con la forma de tetraedros de diferentes tamaños; los colores se producían porque viajaban a distintas velocidades.

Como ustedes recordarán, en el siglo XIII, Robert de Grosseteste, maestro de Roger Bacon, había elaborado una metafísica del mundo basada en la luz, que, para él, era la «primera forma corpórea» de la creación, de la cual se había derivado todo lo demás.

A lo largo del siglo XVII, esta concepción corpórea de la luz se mantuvo: la compartió Galileo, y el propio Newton, en su poderosa construcción, la imaginó así, fiel a su concepción atomista y mecanicista. En su Óptica de 1704 (pero escrita mucho antes, ya que esperó a que se muriera Hooke para publicarla), y en la línea de Demócrito, definió el carácter corpuscular de la luz: los rayos eran conjuntos de pequeños cuerpos sometidos a las mismas leyes que todos los demás. Los más pequeños producían los colores violetas y azules; los más grandes, el verde, el amarillo, el naranja y el rojo. Los fenómenos conocidos de la luz, como la reflexión y la refracción (el cambio de dirección de la luz al pasar de un medio a otro, que podemos comprobar cuando sumergimos una cucharita en un vaso de agua y la vemos doblada) resultaban fáciles de explicar: la reflexión era una especie de rebote elástico al incidir sobre una superficie, la refracción consistía en el cambio de trayectoria de los corpúsculos cuando pasaban del aire al agua, porque el cambio de medio les hacía cambiar su velocidad.

La composición o unión gravitatoria de los corpúsculos de diferentes colores producía un nuevo corpúsculo de luz blanca, que se descomponía al pasar por un prisma debido a los diferentes índices de refracción.

Lo que no quedaba claro era por qué los objetos que emitían esas partículas no retrocedían, conforme al principio de acción y reacción newtoniano, ni tampoco cómo era posible que el Sol, que obviamente irradia una gran cantidad de partículas, no se consumiera con el tiempo.

La teoría ondulatoria

Sin embargo, había otra línea de pensamiento: Descartes imaginó que entre la fuente de luz, el ojo y los objetos había una columna de plenum —es decir, de materia sutil— a lo largo de la cual podía viajar la luz, ya no concebida como proyectil ni como un fluido, sino como un movimiento. La luz era, vista así, sólo una propiedad mecánica del objeto luminoso y del medio de transmisión.

A mediados del siglo XVII, los dos grandes Roberts ingleses, Boyle y Hooke, descubrieron el fenómeno de la interferencia: al pasar por una pequeña ranura u orificio y dar en una pantalla, se observaban franjas alternativas de luz y oscuridad, cosa que no pegaba para nada con la concepción corpuscular, que no era suficiente para dar cuenta del fenómeno de interferencia.

Hooke propuso, entonces, una teoría ondulatoria: la luz consiste en rápidas vibraciones debidas a la agitación del medio. Alrededor de 1690, el gran astrónomo y físico holandés Christian Huygens, en su Tratado de la Luz, la describía como

un movimiento de la materia que se encuentra entre nosotros y el cuerpo luminoso.

Para Huygens, la luz, del mismo modo que el sonido en el aire, se propaga en el éter, el viejo éter inventado por Aristóteles, que seguía vigente incluso para Newton y que en manos de Descartes se había transformado en «materia sutil».

La polémica sobre la naturaleza de la luz se arrastraría durante todo el siglo XVIII: la teoría corpuscular estaba avalada por la inmensa autoridad de Newton y llegó a la Tabla de Elementos del propio Lavoisier, en la que figuraba en el primer puesto, seguida por el calórico (el fuego, el calor), el oxígeno, el ázoe (nitrógeno) y el hidrógeno; la teoría ondulatoria, fiel a su nombre, no se quedaba quieta: en 1746, mientras trabajaba en la Academia de Ciencias de Federico el Grande, en Berlín, Leonhard Euler (1707-1783), uno de los mayores matemáticos de todos los tiempos, y sin duda el más grande del siglo XVIII, publicó su Nueva teoría de la luz y el color. Allí explicaba que los objetos luminosos vibran, y el éter lleva dichas vibraciones al ojo del mismo modo en que el aire transporta el sonido al oído.

Thomas Young y la doble ranura

Pero fue Thomas Young (1773-1829) quien aportó una pieza clave en el rompecabezas de la luz cuando logró entender el efecto de la interferencia. Así como en un estanque, cuando se arrojan dos piedras en distintos lugares, las olas producidas por cada una de las piedras cuando se cruzan entre sí pueden aumentar su tamaño o bien cancelarse, del mismo modo las ondulaciones del éter, si se cruzan, pueden o bien fortalecerse o bien debilitarse hasta anularse.

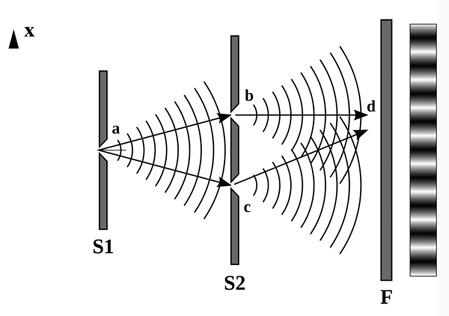

Para demostrar su hipótesis, Young realizó un experimento que lleva su nombre y también se conoce como el de la doble rendija. Proyectó un rayo de luz a través de dos rendijas paralelas entre sí. A través de éstas pasaba la luz, se esparcía e incidía sobre una pantalla donde formaba una imagen consistente en rayas de luz y sombra: un perfecto ejemplo de interferencia. Young explicó el fenómeno diciendo que se veía luz en aquellos lugares donde las ondas que llegaban de las dos rendijas andaban a la par (en fase), llevando el mismo paso, de manera que los picos de ambas ondas se sumaban. Y se veía oscuridad (¿se puede ver oscuridad?) donde las ondas de las dos rendijas no llevaban el mismo paso sino que estaban desfasadas, es decir, el pico de una onda coincidía con el valle de la otra, de manera tal que se anulaban. No había forma de explicar el fenómeno si no era mediante una concepción de la luz como una onda.

La teoría corpuscular no podía dar cuenta del fenómeno: dos corpúsculos que llegaran a un mismo lugar no se podrían aniquilar entre sí. Corpúsculo más corpúsculo da corpúsculo se vea por donde se lo vea. Pero con la teoría ondulatoria, onda más onda puede generar tanto luz más potente como oscuridad, según la forma en que lleguen. La teoría ondulatoria recibía un espaldarazo, aunque los físicos acérrimamente newtonianos (en especial los británicos) no podían aceptar la idea de que Newton hubiera podido estar equivocado.

Y lo cierto es que la polémica se prolongó en el siglo XIX. La siguiente escaramuza estuvo a cargo del ingeniero francés Augustin Fresnel (1788-1827), que en 1818 hizo una histórica presentación en la Academia de Ciencias de París, en presencia de los más importantes físicos de la época (Pierre Simon Laplace entre otros), todos partidarios de la teoría newtoniana. Frente a un público a todas luces adverso, Fresnel repitió el experimento de Young y mostró que la teoría ondulatoria podía explicar no sólo la propagación rectilínea de la luz y los fenómenos de reflexión y refracción sino también los fenómenos de interferencia y difracción, que eran desviaciones de la propagación en línea recta. La teoría ondulatoria parecía triunfar de una vez por todas. Pero el empujón definitivo vendría de un experimento crucial que estaba relacionado con la velocidad de la luz.

La velocidad de la luz

Porque la polémica acerca de la naturaleza de la luz no era la única, lo cual era lógico dada la importancia del fenómeno para nuestras vidas cotidianas y la dificultad que acarrea conceptualizarlo y aprehenderlo. El otro gran problema era el de la medición de su velocidad: ¿se trataba de una magnitud finita o infinita? No había una respuesta para esta cuestión. Pero, obviamente, en tiempos en que los fenómenos empezaban a tamizarse y a destilarse en los laboratorios, ya no alcanzaba con la observación cotidiana para resolver un problema científico. Acaso por eso, en 1638, Galileo propuso un experimento que consistía en observar el retraso entre señales efectuadas con linternas desde dos colinas que se encontraban a un kilómetro de distancia una de la otra. Su propósito era medir el tiempo que tarda la luz en recorrer dos veces la distancia entre los experimentadores situados en las colinas. Uno de ellos destapaba su linterna y el otro, cuando veía la luz, destapaba la suya. El tiempo transcurrido desde que el primer observador activaba su linterna hasta que veía la señal procedente del segundo, era el tiempo que tardaba la luz en recorrer ida y vuelta la distancia entre ambos. El experimento fracasó: el problema era que la velocidad de la luz es demasiado alta y el tiempo que se medía era muy pequeño, por lo que Galileo no hubiese podido de ninguna manera obtener un valor razonable. De modo que el asunto seguía en ascuas.

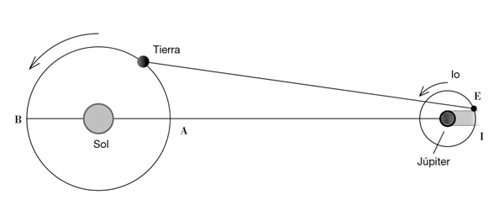

Pero muy pronto vendría la primera medición de la velocidad de la luz mediante una idea genial, que para mí es digna de Aristarco de Samos. En 1676, Oleg Roemer, un astrónomo danés que estudiaba las lunas de Júpiter descubiertas por Galileo, comprobó que sus eclipses (es decir, los momentos en que los satélites se ocultan detrás del planeta) a veces se producían con retraso respecto de lo que fijaban las tablas, en especial cuando la Tierra, en su órbita, estaba del lado más alejado de Júpiter. Y se le ocurrió que ese retraso se debía al tiempo que la luz, llevando la imagen de los eclipses, tardaba en cruzar la órbita de la Tierra.

Utilizando la mejor estimación disponible entonces para el diámetro de la órbita de la Tierra, y sabiendo el tiempo de retraso, calculó que la velocidad de la luz debía ser (en unidades modernas) 225.000 kilómetros por segundo. El resultado es un poco bajo (el valor que tenemos hoy es de 299.792 kilómetros por segundo), pero fue la primera estimación, hecha cuando todavía no se habían publicado los Principia de Newton y se tenían unas dimensiones de la órbita de la Tierra para nada precisas. Se trataba de una verdadera hazaña: había quedado establecido por primera vez sobre bases ciertas que la luz tiene una velocidad finita, aunque enorme.

¡No era extraño que Galileo no hubiera podido medirla!

El triunfo de la teoría ondulatoria

La siguiente estimación se produjo recién casi doscientos años más tarde, a finales de la década de 1840, cuando el físico francés Armand Hippolyte Fizeau (1816-1896) realizó, junto con Léon Foucault (1819-1868), la primera medición directa de la velocidad de la luz mediante un instrumento de laboratorio diseñado por ellos. No voy a entrar en los detalles del método que utilizaron, que serían engorrosos, pero sí les cuento que llegaron al valor de 298.000 kilómetros por segundo.

Las técnicas usadas por Fizeau permitieron zanjar de una vez por todas, al menos por un tiempo, la disputa entre la teoría corpuscular y la ondulatoria. La primera predecía que la luz viajaba más rápido por el agua que por el aire; la otra, que era justamente al revés. En 1850, Fizeau demostró que la luz se desplaza más lentamente en el agua que en el aire.

Es lo que se suele conocer como un experimento crucial, que decide entre dos teorías rivales: la hipótesis corpuscular cayó derrotada y la ondulatoria triunfó. Después de todo, la luz resultaba ser una vibración que se propagaba por el éter, el éter de entonces, desde ya, en el que todos creían.

Poco más tarde, Maxwell demostró matemáticamente de qué clase de ondas se trataba:

Tenemos poderosas razones para concluir que la luz en sí misma es una perturbación electromagnética en formas de ondas que se propagan a través del campo electromagnético según las leyes del electromagnetismo.

La hipótesis sobre la existencia de ondas electromagnéticas fue verificada por el alemán Heinrich Hertz en 1888. Así pues, la luz no era otra cosa que ¡una onda electromagnética, campos magnéticos y eléctricos que se propagaban en el éter!

Era una gran sorpresa, pero el problema de la naturaleza de la luz parecía estar zanjado.

Y sin embargo, y aunque nadie lo podía sospechar entonces, no estaba dicha la última palabra, ni sería la última sorpresa.

EL CALOR: SUSTANCIA O MOVIMIENTO

Que por mayo era, por mayo,

cuando hace la calor,

cuando los trigos encañan

y están los campos en flor.

Romance del prisionero

Tal como ocurría con la luz, en relación con el calor había dos corrientes principales y en cierto modo parecidas: quienes lo consideraban una sustancia y quienes pensaban que era una forma de movimiento.

Asociar el calor con el movimiento no es tan insólito como a primera vista parece: ante fenómenos tan comunes como la agitación de la llama o el calentamiento de los cuerpos por frotamiento o percusión, uno puede pensar que es este movimiento el que genera el calor, agitando o separando las partículas de los cuerpos, provocando su dilatación o, cuando se da con mayor fuerza, su cambio de estado (como cuando el agua se evapora).

En cuanto a las causas de este movimiento, las opiniones estaban divididas entre quienes lo atribuían a un origen puramente mecánico y quienes creían que era provocado por un agente material. Quienes interpretaban la presión que un gas ejercía sobre las paredes de un recipiente como el resultado del golpeteo de las partículas del gas sobre estas paredes y comprobaban que, cuando el gas se calentaba, la presión aumentaba, deducían con facilidad que el calor que se transmitía al gas calentándolo y el aumento de presión consiguiente se debían a que las partículas adquirían mayor velocidad (o vibraban más rápidamente), golpeando las paredes con más frecuencia o fuerza. El hecho no preocupaba demasiado a quienes veían al calor como una sustancia porque la explicación de este fenómeno era todavía más simple: al calentarse el recipiente, entraba en él el calor sustancial, que, como ocupaba espacio, hacía que el gas se expandiera; al enfriarse el gas, salía ese calórico y, por consiguiente, el gas se contraía. Como ven, todo se puede explicar si se pone el suficiente empeño.

La concepción movimientista, o cinética, era mayormente sostenida por los físicos mecanicistas, en especial los más rigurosamente newtonianos, mientras que los químicos tendían a la idea sustancialista, es decir, sostenían que había una sustancia específica (los átomos de calor) que actuaba por su cuenta, penetrando o abandonando los cuerpos.

Cuando se difundió la doctrina del flogisto, muchos pensaron que el flogisto era la sustancia del calor. El hecho de que no se pudiera detectar ningún aumento de peso en los materiales calentados era un problema para la teoría, aunque por momentos se hacía uso y abuso del ejemplo de los metales calcinados, que sí evidenciaban un aumento de peso. Es divertido: el aumento de peso de los metales calcinados era una seria objeción a la teoría del flogisto, pero apuntalaba la teoría sustancialista del calor.

En 1732, el muy influyente Boerhaave, de quien ya hablamos cuando nos ocupamos de la medicina, publicó unos Elementos de química, donde consideraba que las partículas de un cuerpo estaban asociadas por fuerzas de atracción (responsables de su cohesión). Por otra parte, existía el «fuego elemental», una sustancia distribuida por todo el espacio, compuesta por partículas sutilísimas, no sometidas a la ley de gravitación, por lo cual carecían de peso, que al penetrar en los cuerpos oponían, frente a las fuerzas de cohesión, una acción disgregadora, manteniéndolas en perpetua agitación. Al ser sustancial, este fuego no se creaba ni se destruía: el calor no era más que su movimiento vibratorio.

Entre tanto, ya se habían ido distinguiendo las ideas de calor y temperatura y se habían desarrollado diversos termómetros y escalas termométricas como las de Fahrenheit (1714), Réaumur (1730) y Celsius (1742), de las cuales la primera y la tercera (decimal, o mejor centesimal, que fija el 0 en el punto de congelación del agua y 100 el punto de ebullición) siguen en uso. También se había desarrollado la idea de calor específico: la cantidad de calor que necesita una unidad de cualquier sustancia para aumentar un grado su temperatura.

Las cosas avanzaban a paso firme, pero aún quedaba un rescoldo sustancialista que tardaría en ser destronado.

El calórico

Porque lo cierto es que durante el siglo XVIII, salvo en Inglaterra (donde la influencia de Newton era absoluta), predominó más o menos la teoría sustancialista del calor. El propio Lavoisier creía que la «materia del fuego era un fluido sutil y elástico, capaz de penetrar los poros de todos los cuerpos», y le dio el nombre de calórico cuando propuso una nueva nomenclatura química, al tiempo que le asignó un lugar de privilegio en su tabla de los elementos como uno de los ladrillos básicos de la química y la materia. No deja de ser interesante señalar que así como Lavoisier había rechazado la existencia del flogisto, en gran parte por su índole metafísica y por carecer de peso, aceptó esas propiedades en el caso del calórico, lo cual muestra que las teorías científicas (y los científicos) no necesariamente son coherentes por completo.

Así, para la nueva química de Lavoisier, el calórico era una sustancia imponderable, sin peso, que fluía de un cuerpo a otro silenciosamente provocando cambios de temperatura. Pero seguía teniendo algunos pequeños inconvenientes: los casos de producción de calor mediante frotamiento, por ejemplo, eran mejor explicados por la teoría cinética: al poner en contacto un cuerpo caliente con otro frío, sus moléculas, animadas de rápido movimiento, chocaban con las del objeto frío, que se movían más lentamente; como consecuencia de ello, las moléculas rápidas perdían velocidad y las lentas se aceleraban un poco, con lo cual fluía calor del cuerpo caliente al frío.

Fíjense que toda esta discusión se dio sin que nadie tuviera la menor idea o prueba sobre la existencia de los átomos…

Rumford: el fin del calórico y el triunfo de la teoría cinética

El conde Rumford se llamaba en realidad Benjamin Thompson. Había nacido en 1753 en Massachusetts, en lo que todavía no eran los EE.UU., y su vida fue la de un aventurero inventivo, audaz, y nada escrupuloso: a los diecinueve años contrajo matrimonio con una viuda rica de treinta y tres en la ciudad de Concord, Nueva Hampshire, región también conocida como Rumford, con lo cual arregló sus problemas económicos.

Estallaba la Revolución Norteamericana, y Rumford colaboró con los británicos aunque, cuando las cosas pintaron mal, huyó a Europa, plantando a su mujer y a sus hijos, a los que nunca volvió a ver.

Después de varias peripecias, pasó a formar parte de la corte del elector de Baviera, donde dirigió una serie de experimentos sobre las propiedades de la seda, importante producto durante aquella época. En 1792, el elector le dio el título de conde. Y, más tarde, se casó con la viuda de Lavoisier (después de que a Antoine Laurent le cortaran la cabeza durante la Revolución), con quien protagonizó una relación tortuosa y tormentosa cuyas peleas eran la comidilla de París. No era un tipo muy simpático, y cuando en 1814 se murió a causa de una «fiebre nerviosa» (fuera esto lo que fuere), muy poca gente asistió a su entierro.

Pero más allá de las idas y vueltas de la vida de Rumford y de sus andanzas (¿cómo decirlo de manera elegante?) éticamente cuestionables, hizo un serio aporte a la teoría cinética. El más importante de sus experimentos estuvo relacionado, justamente, con la naturaleza del calor. Cuando supervisaba el arsenal de Baviera, donde los cañones se fabricaban taladrando un molde de metal, observó que se producía un aumento de temperatura en la estructura del cañón, en las virutas metálicas, pero también en la propia mecha o taladrador, de modo que parecía generarse calor continuamente en lugar de conservarse, como predecía la teoría del fluido calórico. Los partidarios de la teoría del calórico no se conmovieron, desde ya: contestaron que era porque el taladro rompía en pedazos el metal, dejando que el calórico contenido en éste fluyese hacia afuera, como el agua de un jarrón roto.

A Rumford no lo satisfacía la explicación, por lo cual hizo una serie de experimentos. En uno de ellos utilizó mechas desafiladas, de modo tal que el taladro giraba sin hacer mella sobre el metal ni desprender virutas. Y resultó que se producía tanto calor como si se utilizara una mecha nueva.

El calórico, entonces, no se desprendía por la rotura del metal y quizá no procediese siquiera de éste, lo cual resultaba completamente lógico si se corroboraba que, inicialmente, el metal estaba frío.

Para medir el calórico, Rumford observó cuánto se calentaba el agua utilizada para refrigerar el taladro y el cañón, y llegó a la conclusión de que si todo ese calórico se reintegrara al metal, el cañón debería fundirse, o sea que no podía haber estado allí desde el principio. Entonces pensó que el calor no podía ser una sustancia material y que más bien parecía ser el resultado del rozamiento o del trabajo realizado por las fuerzas de rozamiento.

Además, había un hecho incontestable: la fuente de calor parecía ser inagotable; bastaba que el taladro horadase continuamente el cañón para que éste se siguiera calentando eternamente.

Todo aquello que un cuerpo o sustancia puede continuar suministrando sin limitación no puede ser una sustancia natural, y me parece extremadamente difícil, si no imposible, imaginar algo capaz de producirse y comunicarse como el calor en estos experimentos a no ser el movimiento.

Rumford se convenció de que había demostrado que el calor no era un fluido, sino una forma de movimiento. A medida que el taladro rozaba contra el metal, su movimiento se convertía en rápidos y pequeñísimos movimientos de las partículas que constituían el bronce.

Igual daba que el taladro cortara o no el metal: el calor provenía de esos pequeñísimos y rápidos movimientos de las partículas, y, como es natural, seguía produciéndose siempre y cuando girara el taladro. La producción de calor no tenía nada que ver con ningún calórico que pudiera haber o dejar de haber en el metal.

Los experimentos de Rumford no tuvieron la repercusión que merecían y, además, se levantaba frente a la teoría cinética la enorme autoridad de Lavoisier. De modo que el calórico duró hasta mediados del siglo XIX, cuando Maxwell (y fíjense que ya es la segunda vez que lo nombro; la primera fue hace sólo unas páginas, en relación con la naturaleza de la luz), ya con la teoría atómica medio afirmada, mostró matemáticamente cómo las partículas del gas, moviéndose al azar, creaban una presión contra las paredes del recipiente que lo contenía. Además, esa presión variaba al comprimir las partículas o al dejar que se expandieran. La teoría cinética de Maxwell era aplicable tanto a líquidos y sólidos como a gases. En un sólido, por ejemplo, las moléculas no volaban de acá para allá como proyectiles, que es lo que sucedía en un gas, pero en cambio podían vibrar en torno de un punto fijo. La velocidad de esta vibración, lo mismo que las moléculas proyectiles de los gases, obedecía a las ecuaciones de Maxwell.

La teoría cinética, finalmente, triunfaba, y el calórico se sumergió en el abismo de las sustancias que nunca existieron.

LA ELECTRICIDAD

Si se me pregunta cuál puede ser la utilidad de los fenómenos eléctricos, no puedo responder otra cosa sino que, hasta el presente, no hemos avanzado lo suficiente como para lograr que sean útiles al género humano.

SIR WILLIAM WATSON, 1746

Prehistoria

Hay muy pocas cosas más presentes en nuestra vida que la electricidad; vivimos rodeados de enchufes y aparatos y cuando nos falta nos sentimos perdidos. Pero la revolución eléctrica es muy reciente: hasta hace tan sólo un siglo y medio, el mundo vivía a pura vela, sebo y otras porquerías. Y eso que la electricidad estuvo siempre a la vista; sin ir más lejos, el trueno y el relámpago son fenómenos eléctricos. Pero es muy difícil, realmente muy difícil, darse cuenta de que el rayo se produce mediante el mismo mecanismo que el que se observa cuando al frotar un pedazo de plástico éste atrae pequeños pedazos de papel. Por eso es lógico que meter la electricidad en un cable y hacerla circular llevara milenios.

Tales de Mileto, nuestro viejo amigo que nos acompaña desde el primer capítulo, no tenía ni plástico ni papel, pero sí notó que el ámbar (una sustancia resinosa), después de ser frotada, atraía pajillas, plumas y otros objetos livianos. Como la palabra griega que designa al ámbar es «elektron», el buen Tales llamó «eléctrica» a esta fuerza misteriosa y conjeturó que era de la misma naturaleza que la fuerza que arrastra pedacitos de hierro hacia la piedra imán. No era raro que se le ocurriera, puesto que el efecto de tracción del magnetismo es realmente parecido, y durante mucho tiempo se pensó efectivamente que la fuerza eléctrica y el magnetismo eran semejantes.

Así empezó la electricidad en el mundo antiguo.

No hay ninguna evidencia de que se usara para algo práctico, salvo que las mujeres griegas decoraban sus rizadores de cabello con piezas de ámbar: cuando los rizadores eran electrificados por frotamiento, se producían curiosos fenómenos en el pelo. Si uno piensa en el papel que la electricidad habría de jugar en el mundo, no es demasiado…

Los efluvios eléctricos de Gilbert

Desde Tales hasta que se hizo el siguiente descubrimiento en el campo de la electricidad pasaron solamente dos mil años, y fue William Gilbert, el gran investigador del magnetismo, quien retomó el hilo (o el cable, digamos, aunque nadie soñaba con tales cosas en el siglo XVII). Lo primero que hizo fue distinguir los fenómenos eléctricos de los magnéticos: sólo por poner algunos ejemplos, la atracción magnética no necesita frotamiento para producirse, atraviesa una hoja de papel y sobrevive a la inmersión en agua, mientras que la fuerza eléctrica es destruida mediante la interposición de una mera pantalla. De este modo, para las sustancias que se comportaban como el ámbar —el vidrio, el azufre, o la cera— (y exclusivamente para ellas) acuñó el término «eléctricas»; poco después, Thomas Browne, también médico y escritor, inventó la palabra «electricidad».

Como ya conté en su momento, en el año 1600 Gilbert publicó el resultado de sus investigaciones en su famoso De Magnete. Pero no se limitó a describir sus experimentos y fue un poco más allá al elaborar una teoría sobre la naturaleza de la electricidad de corte sustancialista: bien acorde a la época, Gilbert pensó que la electricidad se debía a algo que bajo la fricción se liberaba del ámbar o del vidrio.

¿Pero qué podía ser? Gilbert era médico e, inspirado por la teoría de los humores, pensó que la fuerza o «virtud» eléctrica era algo parecido a un «humor» que existía en determinados cuerpos. La fricción, al calentarlos, los liberaba y se desprendía en forma de «efluvio» o «emanación».

¿De qué otra manera podía producirse la atracción entre cuerpos electrificados si no era por la atmósfera de efluvios que los rodeaba? Gilbert era un hombre de su tiempo y todavía no se hablaba de «acción a distancia»: si un cuerpo actúa sobre los demás por medio de una fuerza invisible, algo invisible debe rodearlo: parecía obvio entonces. Ése era el modo de razonar de un hombre de la época. Los efluvios que salían del cuerpo al ser frotado tenían una tendencia inherente a volver al cuerpo de origen y al hacerlo arrastraban consigo los pequeños objetos que quedaban a su alcance.

Fue la explicación que se impuso, y cuando medio siglo más tarde se descubrió que la electricidad podía producir rechazo y no sólo atracción, los efluvios de Gilbert se habían convertido en artículo corriente. Ni siquiera la teoría de la gravitación de Newton, que consagraba el principio de acción a distancia, había podido conmoverlos. Los «efluvios eléctricos» estaban firmemente arraigados y lo estarían por mucho tiempo más.

Pero efluvio va, efluvio viene, igual aparecían novedades: Otto von Guericke, burgomaestre de Magdeburgo, el mismo que había hecho el famoso experimento de los hemisferios para demostrar la existencia del vacío, inventó la primera «máquina eléctrica» de que se tuviera noticias: aprovechando los «efluvios» que producía el rozamiento, hizo girar un disco entre dos escobillas, lo cual hacía saltar una chispa. La máquina eléctrica se convirtió en un juego de sociedad.

En 1745, el científico danés Musschenbroek, de Leyden, consiguió «embotellar» —literalmente— los efluvios eléctricos. En realidad, inventó el primer condensador: la botella de Leyden, capaz de almacenar suficiente cantidad de electricidad como para producir una sensible descarga a quien la tocase estando cargada.

Poco antes había habido una noticia importante: la electricidad podía ser conducida. Esto sí que era una gran novedad. A nosotros, acostumbrados a los cables, nos puede parecer extraña la sorpresa que produjo, pero resultaba insólito que un delgado hilo pudiera llevar la electricidad de un cuerpo a otro.

No sólo era asombroso sino que complicaba las cosas para la teoría de los efluvios. Mientras la electricidad atrajera pequeños objetos, o fuera embotellada o no hiciera más que producir chispas, la explicación de Gilbert podía pasar. Pero los efluvios no eran lo más apropiado para ser conducidos de un cuerpo a otro: la misma idea de emanación tiende a la quietud y no al transporte. Tras el descubrimiento de la conducción, los efluvios dejaron de ser buen negocio y cayeron lentamente en decadencia.

Empezaban los tiempos del fluido eléctrico.

El fluido eléctrico

Desde hace un tiempo, soy de la opinión de que el fluido eléctrico no se crea por fricción, sino que es recolectado, siendo en realidad un elemento difuso atraído por otro tipo de materia, particularmente por el agua y los metales,

escribió en 1747 Benjamin Franklin.

En realidad, desde el descubrimiento de la conducción eléctrica, los efluvios estaban de capa caída y empezó a imponerse la idea de que la electricidad era un fluido, algo así como un impalpable e invisible líquido de materia sutil, semejante, digamos, al calórico, al flogisto o a cualquiera de esas sustancias que nunca existieron. Los partidarios de los efluvios, a regañadientes, se batieron en retirada, aunque en 1733 un informe de la Académie Française señalaba que

alrededor de un cuerpo electrificado se forma un vórtice de materia extraordinariamente sutil en un estado de agitación, que arrastra hacia él las sustancias livianas que están dentro de su esfera de actividad.

Un vórtice cartesiano, claro está.

Los efluvios estaban terminados, pero enseguida apareció otro tema de controversia gracias a (o por culpa de) el investigador Charles François Du Fay (1698-1739), que a través de sus experimentos llegó a la sorprendente conclusión de que en realidad existían no una sino dos clases de electricidad: una que llamó «vítrea» y otra «resinosa».

Hay dos electricidades de naturaleza completamente diferente. Cada una de ellas repele a los cuerpos que contrajeron electricidad de la misma naturaleza y atrae a los cuerpos que tienen electricidad de naturaleza opuesta.

No todos compartían la hipótesis de las dos electricidades. En 1746, el farmacéutico inglés William Watson sugirió que las acciones eléctricas se debían a la presencia de un «éter eléctrico» que en el cargarse y descargarse de un cuerpo se transfiere, pero no se crea ni se destruye. Para Watson, la excitación de un conductor

no consiste sino en la acumulación de un excedente del éter eléctrico a expensas de algún otro cuerpo, cuyo stock disminuye en la misma cantidad.

Más o menos al mismo tiempo, el primer gran hombre de ciencia norteamericano, Benjamin Franklin (1706-1790), en la misma línea de pensamiento, proponía una cosa parecida: la cantidad total de electricidad en un sistema aislado es invariable (principio de conservación de la carga), y en realidad hay un solo tipo de electricidad. Para Franklin, la única electricidad que existe es «la electricidad vítrea» de Du Fay; la otra, la «electricidad resinosa», es una ficción, es simplemente la falta de fluido eléctrico. Franklin asignó un signo positivo a la «electricidad vítrea», y un signo negativo a la falta de electricidad. Se imaginaba a la electricidad como un fluido elástico, compuesto por

partículas extremadamente sutiles, dado que pueden permear la materia común y aun los más densos metales, con tanta facilidad que no se percibe ninguna resistencia.

Naturalmente, los experimentos más conocidos de Franklin fueron sus trabajos sobre la electricidad atmosférica: se tomó muy en serio la sugerencia, hecha por el profesor J. H. Winkler de Leipzig, quien sostenía que la descarga de una botella de Leyden y el trueno y el relámpago eran básicamente uno y el mismo fenómeno. Pensó (y no fue el primero) que el rayo era meramente una descarga eléctrica entre dos objetos con diferente potencial, como las nubes y la tierra, y observó que el rayo tendía a alcanzar edificios altos y árboles, lo cual le dio la idea de atraer el fluido eléctrico deliberadamente a la tierra de un modo que la descarga no produjera daños. Vale la pena insistir en que no era una asociación de ideas fácil.

A comienzos de 1747, Franklin escribía

Si el fuego eléctrico y el de los rayos es el mismo, como he tratado de demostrar, y admitiendo esta suposición, me pregunto si el conocimiento del poder de las puntas no podría beneficiar a los hombres para preservar las casas, las iglesias, los buques, etcétera, contra los golpes del rayo, fijando perpendicularmente sobre las partes más elevadas de los edificios, barras de hierro en forma de aguja y doradas para prevenir la herrumbre y al pie de esas barras un alambre que llegue hasta los cimientos de la tierra. ¿No atraerían esas barras de hierro, en silencio, el fuego eléctrico de la nube antes de que ésta pueda aproximarse para dar el golpe? ¿Y no podríamos, por esos medios, precavernos de tantos desastres repentinos y terribles?

La cita tiene la forma, para nosotros, de una adivinanza, cuya respuesta está a la vista: el pararrayos.

Es bien conocido su experimento decisivo. En 1752 remontó un barrilete en medio de una tormenta. El barrilete tenía en su extremo superior un alambre terminado en punta, que mediante un hilo de seda estaba conectado a una llave de metal cerca del extremo que sostenía Franklin. En plena tormenta, acercó la mano a la llave y saltó una chispa, con lo cual quedaba claro que efectivamente el hilo transmitía electricidad del cielo a la llave. Más tarde pudo incluso cargar una botella de Leyden, demostrando así que las nubes realmente estaban cargadas eléctricamente. Y desde ese momento la barra de Franklin (que conducía las descargas pacíficamente a tierra) empezó a extenderse sistemáticamente. El primer pararrayos fue construido, según las instrucciones de Franklin, por Johann Heinrich Winkler.

Obviamente, como toda innovación tecnológica, el pararrayos tuvo sus resistencias (¡recuerden la resistencia que hubo a usar microscopios!), que se centraron en argumentos del tipo: «Si el rayo es un castigo de Dios para los impíos, ¿cómo puede el hombre interferir en él?». Pero parece que no había impíos desempeñando funciones públicas en Filadelfia, al menos, porque para 1782 había ya 400 pararrayos protegiendo prácticamente todos los edificios públicos. La excepción era la embajada francesa, que ese mismo año fue alcanzada por un rayo que provocó la muerte de uno de sus funcionarios. Tras lo cual, como es lógico, se apresuraron a instalar la barra de Franklin.

A todo esto, uno de sus discípulos, Franz Aepinus (1724-1802), terminó para siempre con los remanentes de la teoría de los efluvios y abordó el meollo de la cuestión: la acción a distancia. Aepinus estableció que la acción de las fuerzas eléctricas se ejercía efectivamente a distancia a través del aire y aplicó sus teorías al fenómeno de la inducción, mediante el cual un cuerpo cargado próximo a uno conductor, pero sin contacto con él, se cargaba, él también, eléctricamente.

También buscó —y no encontró— la ley que gobernaba esas fuerzas eléctricas; ese honor le estaba reservado al químico Joseph Priestley —el mismo que ya vimos descubriendo el oxígeno—, que en 1767 sugirió que la fuerza eléctrica debía obedecer a una ley parecida a la de la gravitación. La hipótesis fue confirmada experimentalmente en 1785 por el físico francés Charles Auguste de Coulomb, y hoy la ley que rige la fuerza eléctrica lleva su nombre: las cargas eléctricas se atraen o rechazan con fuerzas inversamente proporcionales al cuadrado de la distancia que las separa.

Con la ley de conservación de la carga, la teoría del fluido único, la ley de Coulomb y la aceptación de la acción a distancia, a fines del siglo XVIII y principios del XIX el estudio de la electricidad había avanzado bastante, aunque no se tuviera aún —y no se tendría por mucho tiempo— una idea acabada sobre su naturaleza.

Pero, como ya había enseñado Newton, imperaba el «yo no formulo hipótesis». Se trataba de descripciones más o menos empíricas, que muchas veces producían aplicaciones sensacionales como el pararrayos.

La rana de Galvani y la pila de Volta

Usamos con cierta frecuencia la palabra «galvanizar», que se remonta a los primeros tiempos de las investigaciones en el campo de la electricidad. La leyenda cuenta que un día del año 1780 Luigi Galvani, profesor de medicina en la Universidad de Bolonia, estaba en su casa dando una clase a sus estudiantes, mientras su esposa preparaba en la cocina el manjar favorito del profesor: ranas. La signora Galvani, demasiado atenta a las explicaciones de su marido, dejó escapar el escalpelo, que cayó sobre el muslo de la rana, tocando la base de zinc al mismo tiempo. La rana —muerta, claro está— se agitó violentamente, como si quisiera saltar del plato.

La Signora gritó. El Professore, indignado por la interrupción, irrumpió en la cocina para ver qué pasaba. La Signora le contó la historia y, para probarla, dejó caer el escalpelo sobre la rana, que nuevamente saltó contrayendo sus músculos muertos. Allí mismo, en el medio de la cocina, Galvani proclamó: «He hecho un gran descubrimiento: ¡la electricidad animal, fuente primaria de la vida!». Es una leyenda, sí, probablemente falsa, pero la historia de la ciencia se alimenta también de la leyenda y de la sustancia de los mitos.

Unos años más tarde, Galvani, además de interminables peroratas y demostraciones públicas sobre «la electricidad animal», escribió un tratado con un indigerible nombre en latín donde exponía sus teorías. Según él los tejidos animales contenían una fuerza eléctrica innata (la famosa «electricidad animal») que alimentaba a los músculos y a los nervios y salía a la luz cuando éstos eran tocados por objetos de metal. Pensó también que esa «electricidad animal» era una especie de «espíritu vital» que animaba a los seres vivos y creyó haber encontrado la esencia de la vida. Pegaba bien con las teorías vitalistas en boga: finalmente, se había descubierto que la electricidad era la escurridiza «fuerza vital».

La electricidad animal y las ranas contracturadas de Galvani hicieron furor. No había salón donde no se hablara del tema y los aristócratas se precipitaban al laboratorio para ver a las ranas muertas contraerse bajo la acción de unas pinzas de metal. La palabra «galvanizar» nos recuerda aquellas aventuras y la electricidad como «chispa de la vida» se reflejó también en la literatura, como lo testimonia el Frankenstein, de Mary Shelley.

Los puntos de vista de Galvani y sus teorías sobre la electricidad animal fueron aceptados casi universalmente, con una importante excepción: Alessandro Volta, el notable profesor de física de la Universidad de Pavia. Volta sostenía que en el experimento de Galvani no había ningún tipo de electricidad animal ni nada que se le pareciera. Más aún: para Volta, las infelices ranas no jugaban ningún papel, salvo el de conductores de la electricidad, de una leve corriente eléctrica que se producía al entrar en contacto dos metales diferentes (como el cuchillo de hierro y el plato de zinc de la signora Galvani). Era mucho decir, y se desató una virulenta polémica.

Galvani murió en 1790 y recién diez años después Volta pudo demostrar de manera concluyente que, efectivamente, cuando dos metales diferentes entran en contacto se genera un flujo de corriente eléctrica. Recortó discos de diferentes metales, y los apiló unos sobre otros, separándolos por capas de fieltro embebidas en ácido: las diferencias de potencial generadas entre disco y disco se acumularon y la «pila» produjo un flujo eléctrico firme y constante.

Volta no sólo había demostrado tener razón en la polémica con Galvani, sino que había hecho mucho más: había construido la primera fuente permanente de electricidad (aunque, en realidad, se equivocaba cuando explicaba el modo de funcionamiento, puesto que la corriente eléctrica entre los dos metales no se debe al contacto sino al fenómeno de electrólisis —es decir, de separación de los elementos de un compuesto— del medio que los separa).

Gracias a ese descubrimiento (o invento, vaya uno a saber), Volta revolucionó completamente la investigación eléctrica: a partir de entonces, los investigadores disponían por primera vez de fuentes permanentes de corriente eléctrica. No es de sorprender, entonces, que la investigación eléctrica se intensificara. El siguiente gran salto, que habría de encaminar los estudios eléctricos hacia la concepción moderna y hacia la revolución eléctrica, iba a ser responsabilidad de un físico danés: Hans Cristian Oersted.

Oersted y Faraday

Aunque yo pudiera ser Shakespeare, pienso que igual preferiría seguir siendo Faraday.

ALDOUS HUXLEY

Muchos años más tarde, ya en la cumbre de su fama, Michael Faraday recordaría aquella remota tarde en que un cliente de la librería lo invitó a escuchar una conferencia de Humphry Davy (1778-1829). Según él mismo contó después, fue la conferencia de Davy la que lo decidió a dedicarse a la ciencia.

Pero la historia, como tantas otras, empieza antes y (¡otra vez!) con una leyenda. Y es así: un día cualquiera de 1819, el físico danés Hans Christian Oersted estaba dando clase en la Universidad de Kiel (ahora Alemania, entonces Dinamarca) y, durante un experimento, un alambre por el cual circulaba electricidad se deslizó de su mano y cayó sobre una brújula que estaba casualmente sobre la mesa. Al recoger el alambre vio que la aguja de la brújula se había desviado. Cortó la corriente, y la brújula volvió a su posición normal, apuntando hacia el Norte. Era evidente que la corriente eléctrica tenía algún tipo de efecto magnético que había hecho desviar la brújula.

Naturalmente, las cosas no fueron exactamente así: en realidad hacía muchos años que Oersted estaba experimentando —sin éxito— sobre los efectos magnéticos de la electricidad. Más aún: durante el siglo XVIII muchos físicos habían especulado sobre las conexiones entre el magnetismo y la electricidad, fenómenos que Gilbert había separado radicalmente en el siglo anterior. Sin embargo, algunas observaciones casuales habían mostrado que el rayo actúa sobre la brújula. Además, estaba el hecho de que la ley que regía las fuerzas eléctricas era idéntica a la que gobernaba los polos magnéticos y muchos pensaban que no podía tratarse de una casualidad y que debía haber alguna relación profunda entre ambos fenómenos. Oersted era uno de ellos. También seguían una de las grandes corrientes de la época, la Naturphilosophie (filosofía de la naturaleza), que, con indudables tintes del romanticismo, imaginaba al mundo como un todo más o menos orgánico, y postulaba la unidad de todas las fuerzas.

Pero siempre —o casi siempre— es preferible la leyenda. Apenas Oersted anunció el descubrimiento, se produjo un fuerte impacto entre los físicos: la vinculación entre electricidad y magnetismo tenía un atractivo poderoso. Nadie se imaginaba cuán poderoso, en realidad.

En seguida empezaron las pruebas y los experimentos. El inglés Sturgeon arrolló una espira alrededor de una barra de hierro corriente y vio que, mientras la corriente circulaba, la barra de hierro se convertía nada menos que en un imán.

Y así nació el electroimán, que abrió el camino del telégrafo y —más tarde— del teléfono. En Francia, Ampère —que daría su nombre a la unidad de corriente eléctrica— afinaba las observaciones de Oersted y estudiaba la atracción recíproca de dos corrientes eléctricas entre sí.

Pero faltaba todavía una conexión para que este primer ciclo de la investigación en electricidad se cerrara, y fue entonces cuando apareció Michael Faraday, escuchando la conferencia de Davy (quien, entre otras cosas, desentrañó el fenómeno de la electrólisis, que era la verdadera explicación del funcionamiento de la pila de Volta).

Faraday había nacido en 1791 cerca de Londres; su familia era muy modesta y su educación, como él mismo contó,

fue del tipo más corriente: los rudimentos de lectura, escritura y aritmética en una escuela diurna común. Las horas fuera de la escuela las pasaba en mi casa y en las calles.

Es decir, nada de estudios superiores. Pero desde muy joven empezó a trabajar en la casa de un librero y a adquirir cultura por su cuenta. Fue allí donde un cliente lo invitó a la conferencia de Davy. Faraday plantó la librería y se las arregló para que Davy lo tomara como asistente. Tenía entonces veintidós años y no podía haber encontrado un maestro mejor. Junto a Davy se empapó de las técnicas de laboratorio que, una vez que empezó a experimentar por su cuenta, rindieron excelentísimos frutos: desde un método para licuar gases o el descubrimiento del benceno hasta un mejoramiento de las leyes de la electrólisis de su maestro. En su estudio del magnetismo, introdujo la idea de líneas de fuerza y el fructífero concepto de campo magnético. Paso a paso, se iba aproximando a su descubrimiento capital.

Ya era un hecho constatado que la corriente eléctrica producía un campo magnético. Faraday invirtió el problema y, puesto que la electricidad producía magnetismo, se preguntó si no sería posible que el magnetismo generara electricidad.

Arrolló una espira alrededor de una barra de hierro, y la situó frente a una segunda espira. Al circular la corriente por la primera espira, esperaba que la barra, transformada en imán, indujera una corriente en la segunda espira.

Pero no pasaba nada. Es verdad que al encender la corriente en la primera espira se producía una corriente en la segunda, pero duraba sólo un instante y desaparecía. También al cortar la electricidad que imantaba la barra volvía a aparecer una breve corriente en la segunda espira. Pero sólo eso. Faraday no lograba producir una corriente continua en la segunda espira y tardó en dar con la clave del asunto.

Y la clave del asunto es que un campo magnético no produce ninguna corriente eléctrica. Para que se produzca una corriente eléctrica el campo magnético tiene que variar o moverse. Al prender o apagar la corriente, el campo magnético variaba y aparecían breves corrientes en la segunda espira. Mientras el campo magnético permanecía invariable, nada. Pero Faraday tardó en darse cuenta. Recién el 28 de octubre de 1831, haciendo rotar una espira en un campo magnético, logró producir una corriente eléctrica permanente. Había descubierto la inducción eléctrica (que nada tiene que ver con la inducción como método de conocimiento, de la cual hemos hablado tanto).

Fue un descubrimiento feliz. Por empezar, cerró el circuito: así como la electricidad induce magnetismo, el magnetismo induce electricidad. Pero además, en la inducción estaba implícita una manera directa y práctica de generar electricidad: hacer girar un conductor en un campo magnético. Llevaría aún cuarenta años implementarla.

Faraday está en la base del mundo moderno. Con él, la electricidad y el magnetismo, los dos campos que Gilbert había separado hacía ciento cincuenta años, volvían a juntarse y a mostrar su íntima conexión e interdependencia. Sólo faltaba que alguien tradujera esa conexión en el lenguaje de las matemáticas, en una síntesis genial. Faraday no había resuelto el problema de qué es la electricidad. Esa tarea quedaría para fines del siglo XIX, y la respuesta habría de ser, en verdad, muy sorprendente. Y vendría de la mano, otra vez, de Maxwell, el responsable de la resolución de los tres misterios: la luz, el calor y el electromagnetismo.