12. Ada para sempre

A OBJEÇÃO DE LADY LOVELACE

Ada Lovelace teria gostado. Até onde nos é permitido imaginar os pensamentos de alguém que morreu há mais de 150 anos, podemos visualizá-la, toda orgulhosa, escrevendo uma carta na qual se gaba de sua intuição de que um dia dispositivos de calcular se tornariam computadores de uso geral, belas máquinas capazes não só de manipular números, mas também de fazer música, processar palavras e “combinar símbolos genéricos em sucessões de ilimitada variedade”.

Máquinas como essas apareceram na década de 1950, e nos trinta anos subsequentes duas inovações históricas as levaram a revolucionar o modo como vivemos: microchips possibilitaram que os computadores se tornassem pequenos o suficiente para serem aparelhos de uso pessoal, e redes de comutação de pacotes permitiram que eles fossem conectados como nodos em uma rede. Essa fusão do computador pessoal com a internet ensejou o florescimento, em escala colossal, da criatividade digital, do compartilhamento de conteúdo, da formação de comunidades e das redes sociais. Transformou em realidade o que Ada chamou de “ciência poética”, na qual a criatividade e a tecnologia eram a trama e a urdidura, como em uma tapeçaria em um tear de Jacquard.

Ada também poderia ter razão de se gabar de estar certa, ao menos até agora, em sua afirmação mais polêmica: que nenhum computador, por mais potente que fosse, poderia um dia ser de fato uma máquina “pensante”. Um século depois da morte de Ada, Alan Turing batizou esse argumento de “Objeção de Lady Lovelace” e tentou refutá-lo criando uma definição operacional de máquina pensante: que uma pessoa, ao fazer perguntas à máquina, não fosse capaz de distingui-la de um ser humano. Turing predisse que um computador passaria nesse teste dentro de algumas décadas. Mas lá se foram mais de sessenta anos e nenhuma máquina até hoje passou no teste muito simples e talvez não muito significativo proposto por Turing. Decerto nenhuma ultrapassou o limite superior determinado por Ada, de ser capaz de “originar” pensamentos próprios.

Desde que Mary Shelley concebeu a história de Frankenstein durante umas férias com o pai de Ada, Lord Byron, a perspectiva de uma invenção humana conseguir originar seus próprios pensamentos amedronta gerações. O tema de Frankenstein se tornou matéria-prima da ficção científica. Um vívido exemplo foi o filme de Stanley Kubrick, 2001: Uma odisseia no espaço, de 1968, protagonizado por HAL, um computador apavorantemente inteligente. Com sua voz calma, HAL exibe atributos humanos: capacidade de falar, raciocinar, reconhecer rostos, apreciar a beleza, demonstrar emoções e (é óbvio) jogar xadrez. Quando HAL parece apresentar uma falha, os astronautas decidem desligá-lo. HAL percebe o plano e mata todos, menos um. Depois uma luta heroica, o astronauta remanescente consegue acessar os circuitos cognitivos de HAL e os desliga um por um. HAL regride até que, no fim, canta “Daisy Bell”, uma homenagem à primeira música gerada por computador, cantada em 1961 nos Laboratórios Bell por um IBM 704.

Há tempos os entusiastas da inteligência artificial prometem, ou ameaçam, que máquinas como HAL surgirão em breve e provarão que Ada estava errada. Essa foi a premissa da conferência que John McCarthy e Marvin Minsky organizaram em 1956 em Dartmouth, o berço da inteligência artificial. Os conferencistas concluíram que um avanço revolucionário ocorreria em cerca de vinte anos. Não ocorreu. Década após década, novas levas de especialistas proclamaram que a inteligência artificial estava no horizonte visível, talvez dali a vinte anos. Mas isso continuou sendo uma miragem, sempre vinte anos à frente.

John von Neumann estava trabalhando no desafio da inteligência artificial pouco antes de morrer, em 1957. Depois de ajudar a criar a arquitetura dos modernos computadores digitais, ele percebeu que a arquitetura do cérebro humano é fundamentalmente diferente. Computadores digitais lidam com unidades precisas, enquanto o cérebro, até onde o compreendemos, é também, em parte, um sistema analógico que lida com um continuum de possibilidades. Em outras palavras, um processo mental humano inclui muitos pulsos de sinais e ondas analógicas vindos de diferentes nervos, que caminham juntos para produzir não só dados binários do tipo sim-não, mas também respostas como “talvez” e “provavelmente”, além de inúmeras outras nuanças, inclusive ocasionais perplexidades. Von Neumann supôs que talvez o futuro da computação inteligente exigisse o abandono da abordagem puramente digital e a criação de “procedimentos mistos” que incluíssem uma combinação de métodos digitais e analógicos. “A lógica terá de passar por uma pseudomorfose e virar neurologia”, ele declarou, o que, traduzindo de maneira tosca, significa que os computadores teriam de se tornar mais semelhantes ao cérebro humano.1

Em 1958, um professor da Universidade Cornell, Frank Rosenblatt, tentou fazer isso elaborando uma abordagem matemática para criar uma rede neural artificial como a do cérebro. Chamou-a de Perceptron. Usando inputs estatísticos ponderados, essa rede, em teoria, poderia processar dados visuais. Quando a Marinha, que estava financiando o trabalho, divulgou o sistema, atraiu o tipo de alvoroço na imprensa que acompanharia muitas pretensões subsequentes da inteligência artificial. “A Marinha revelou o embrião de um computador eletrônico com expectativas de que ele venha a ser capaz de andar, falar, ver, escrever, reproduzir-se e ser cônscio de sua existência”, noticiou o New York Times. A New Yorker mostrou entusiasmo equivalente: “O Perceptron, […], como seu nome implica, tem capacidade para produzir o equivalente ao pensamento original. […] Parece ser o primeiro rival de peso do cérebro humano já criado”.2

Isso foi há quase sessenta anos. O Perceptron ainda não existe.3 No entanto, desde então quase todo ano houve notícias empolgadas sobre alguma maravilha no horizonte capaz de replicar e superar o cérebro humano, muitas delas usando quase as mesmas frases das reportagens de 1958 sobre o Perceptron.

As discussões sobre a inteligência artificial inflamaram-se um pouco, pelo menos na imprensa popular, depois que o Deep Blue, uma máquina de jogar xadrez da IBM, venceu o campeão mundial Garry Kasparov em 1997, e em seguida Watson, um computador também da IBM que respondia a perguntas em linguagem natural, venceu os campeões Brad Rutter e Ken Jennings no programa de perguntas da TV Jeopardy!, em 2011. “Acho que isso despertou toda a comunidade da inteligência artificial”, disse a CEO da IBM Ginni Rometty.4 Porém, como ela foi a primeira a admitir, não se tratava de verdadeiras revoluções na inteligência artificial semelhante à humana. O Deep Blue venceu no xadrez pela força bruta; era capaz de avaliar 200 milhões de posições por segundo e compará-las com 700 mil jogos de grandes mestres do passado. A maioria de nós concordaria que os cálculos do Deep Blue eram em essência diferentes daquilo que consideramos raciocínio de verdade. “O Deep Blue só era inteligente no mesmo sentido em que o nosso despertador programável é inteligente”, disse Kasparov. “Se bem que perder para um despertador de 10 milhões de dólares não fez com que eu me sentisse melhor.”5

De maneira análoga, Watson venceu em Jeopardy! graças a megadoses de poder de computação: ele tinha 200 milhões de páginas de informações em seus 4 terabytes de memória, das quais toda a Wikipedia correspondia a meros 0,2%. Ele era capaz de avaliar o equivalente a 1 milhão de livros por segundo. Também era muito bom em processar o inglês coloquial. Mesmo assim, ninguém que assistiu à competição apostaria que Watson seria capaz de passar no teste de Turing. De fato, os líderes da equipe da IBM temiam que os redatores do Jeopardy! tentassem transformar a competição em um teste de Turing, elaborando perguntas destinadas a enganar a máquina, de modo que insistiram para que fossem usadas apenas perguntas antigas, de competições não transmitidas pela televisão. Apesar disso, a máquina tropeçou de maneiras que mostraram que ela não era humana. Por exemplo, foi feita uma pergunta sobre a “singularidade anatômica” do antigo ginasta olímpico George Eyser. Watson respondeu: “O que é perna?”. A resposta correta era que Eyser não tinha uma perna. O problema estava na compreensão de “singularidade”, explicou David Ferrucci, o diretor do projeto Watson na IBM. “O computador não poderia saber que a falta de uma perna é mais singular do que outra coisa qualquer.”6

John Searle, o professor de filosofia de Berkeley que inventou a “Sala Chinesa” para refutar o teste de Turing, ridicularizou a ideia de que Watson representasse o mais ínfimo vislumbre de inteligência artificial. “Watson não entendeu as perguntas, nem suas respostas, nem que algumas das respostas eram certas e algumas eram erradas, nem que ele estava participando de um jogo, nem que tinha ganhado — porque ele não entende coisa alguma”, argumentou. “O computador da IBM não foi e não podia ter sido projetado para entender. Ele foi projetado para simular o entendimento, para agir como se entendesse.”7

Até o pessoal da IBM concordava. Nunca tinham dito que Watson era uma máquina “inteligente”. “Os computadores de hoje são idiotas brilhantes”, disse o diretor de pesquisas da companhia, John E. Kelly III, depois das vitórias do Deep Blue e de Watson.

Eles possuem capacidades tremendas de armazenar informações e efetuar cálculos numéricos, muito superiores às de qualquer ser humano. Mas quando falamos em outra classe de habilidades, as capacidades de entender, aprender, adaptar-se e interagir, os computadores são miseravelmente inferiores aos seres humanos.8

Em vez de demonstrar que as máquinas estão chegando mais perto da inteligência artificial, o Deep Blue e Watson indicaram justamente o contrário. “Essas realizações recentes, por ironia, salientaram as limitações da ciência da computação e da inteligência artificial”, afirmou o professor Tomaso Poggio, diretor do Centro de Cérebros, Mentes e Máquinas do MIT. “Ainda não entendemos como o cérebro origina a inteligência, nem sabemos como construir máquinas que sejam tão abrangentemente inteligentes como nós.”9

Douglas Hofstadter, professor da Universidade de Indiana, combinou arte e ciência em seu inesperado best-seller Gödel, Escher, Bach, de 1979. Ele acreditava que o único modo de se obter uma inteligência artificial significativa era entender como funcionava a imaginação humana. Sua abordagem foi praticamente abandonada nos anos 1990, quando os estudiosos consideraram mais vantajoso executar tarefas complexas recorrendo a um enorme poder de computação para processar imensas quantidades de dados, como fazia o Deep Blue ao jogar xadrez.10

Esse sistema gerou uma peculiaridade: os computadores podem fazer algumas das tarefas mais difíceis do mundo (avaliar bilhões de possíveis posições de xadrez, encontrar correlações em centenas de repositórios de informações do tamanho da Wikipedia), mas não são capazes de executar algumas das tarefas que parecem muito simples para nós, seres humanos. Faça ao Google uma pergunta objetiva como “Qual é a profundidade máxima do mar Vermelho?”, e ele no mesmo instante responderá “2211 metros”, coisa que nem seus amigos mais inteligentes sabem. Faça-lhe uma pergunta fácil como “Jacaré sabe jogar basquete?”, e o Google não terá a menor ideia, muito embora uma criancinha de dois anos seja capaz de responder, depois de rir um bocado.11

Na Applied Minds, uma empresa de tecnologia nos arredores de Los Angeles, podemos ter uma inspiradora demonstração de como um robô está sendo programado para manobrar, mas logo fica evidente que ele ainda tem dificuldade para se orientar em uma sala desconhecida, pegar um lápis e escrever seu nome. Uma visita à Nuance Communications, uma empresa de software no entorno de Boston, mostra os espantosos avanços em tecnologias de reconhecimento de fala que fundamentam o Siri e outros sistemas, porém também é evidente para qualquer um que use o Siri que ainda não podemos ter uma conversa de fato significativa com um computador, exceto em um filme de ficção. No Laboratório de Ciência da Computação e Inteligência Artificial do MIT está em andamento um trabalho interessante para fazer computadores perceberem objetos visualmente, mas embora a máquina consiga discernir figuras de uma menina com uma xícara, um menino em um bebedouro e um gato tomando leite, não tem capacidade para o raciocínio abstrato simples necessário para deduzir que todos os três estão ocupados na mesma atividade: beber. Uma visita ao sistema de comando da polícia de Nova York em Manhattan mostra como computadores escaneiam milhares de dados de câmeras de vigilância no trabalho do Domain Awareness System [Sistema de Percepção de Domínio], mas o sistema ainda não é capaz de identificar de modo confiável o rosto da mãe de alguém numa multidão.

Todas essas tarefas têm uma coisa em comum: até uma criança de quatro anos consegue executá-las. “A principal lição de 35 anos de pesquisas em inteligência artificial é que os problemas difíceis são fáceis e os problemas fáceis são difíceis”, diz Steven Pinker, cientista cognitivo de Harvard.12 Como observaram o futurólogo Hans Moravec e outros, esse paradoxo se origina do fato de que os recursos computacionais necessários para reconhecer um padrão visual ou verbal são colossais.

O paradoxo de Moravec reforça as observações de Von Neumann, feitas há meio século, de que a química baseada em carbono do cérebro humano tem um funcionamento diferente dos circuitos de lógica binária baseados em silício de um computador. Wetware* é diferente de hardware. O cérebro humano não só combina processos analógicos e digitais, mas também é um sistema distribuído, como a internet, e não centralizado, como um computador. A unidade de processamento central de um computador pode executar instruções muito mais rápido do que um neurônio de um cérebro pode disparar. “Mas os cérebros mais do que compensam isso, pois todos os neurônios e sinapses estão ativos ao mesmo tempo, ao passo que a maioria dos computadores atuais tem apenas uma ou no máximo algumas CPUs”, explicam Stuart Russell e Peter Norvig, autores do mais destacado livro didático sobre inteligência artificial.13

Então por que não criar um computador que imite os processos do cérebro humano? “Um dia seremos capazes de sequenciar o genoma humano e replicar o modo como a natureza fez a inteligência em um sistema baseado em carbono”, conjectura Bill Gates. “É como fazer a engenharia reversa do produto criado por outra pessoa para resolver um problema.”14 Não será fácil. Cientistas levaram quarenta anos para mapear a atividade neurológica do nematelminto, um verme de um milímetro de comprimento que possui 302 neurônios e 8 mil sinapses.** O cérebro humano tem 86 bilhões de neurônios e até 150 trilhões de sinapses.15

No final de 2013, o New York Times publicou uma reportagem sobre “um avanço que está prestes a virar de cabeça para baixo o mundo digital” e “possibilitar uma nova geração de sistemas de inteligência artificial que executarão algumas das funções que os seres humanos desempenham com facilidade: ver, falar, ouvir, orientar-se, manipular e controlar”. Essas frases lembram as usadas em 1958 na reportagem desse mesmo jornal sobre o Perceptron (“Será capaz de andar, falar, ver, escrever, reproduzir-se e ser cônscio de sua existência”). Mais uma vez, a estratégia foi replicar o modo como funcionam as redes neurais do cérebro humano. Como explicou o Times, “a nova abordagem computacional baseia-se no sistema nervoso biológico, especificamente no modo como os neurônios reagem a estímulos e se conectam com outros neurônios para interpretar informações”.16 A IBM e a Qualcomm divulgaram seus respectivos planos para construir processadores de computador “neuromórficos”, ou semelhantes ao cérebro, e um consórcio de pesquisas europeu chamado Projeto Cérebro Humano anunciou que havia construído um microchip neuromórfico que incorporava “50 milhões de sinapses plásticas e 200 mil modelos de neurônio biologicamente realistas em um único tablete de silício de vinte centímetros”.17

Talvez essa última rodada de reportagens de fato signifique que, daqui a algumas décadas, haverá máquinas que pensam como seres humanos. “Estamos continuamente examinando a lista das coisas que máquinas não podem fazer — jogar xadrez, dirigir carro, traduzir línguas — e riscando as tarefas agora possíveis para as máquinas”, disse Tim Berners-Lee. “Um dia chegaremos ao fim da lista.”18

Esses avanços mais recentes talvez até possam levar à “singularidade”, termo que Von Neumann cunhou e o futurólogo Ray Kurzweil e o escritor de ficção científica Vernon Vinge popularizaram; esse termo às vezes pode ser usado para designar o momento em que computadores não só serão mais inteligentes que seres humanos, mas também capazes de projetar a si mesmos para ser ainda mais superinteligentes, deixando, assim, de precisar de nós, mortais. Vinge diz que isso ocorrerá até 2030.19

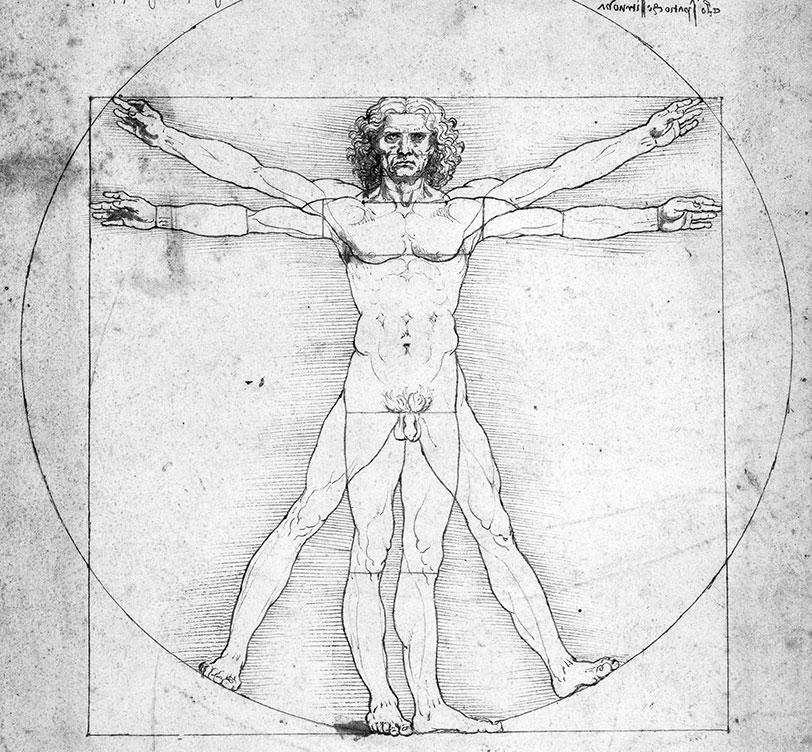

Por outro lado, essas reportagens mais recentes podem acabar se revelando como aquelas de palavreado semelhante dos anos 1950: vislumbres de uma miragem sempre distante. A verdadeira inteligência artificial talvez demore mais algumas gerações ou até mais alguns séculos. Podemos deixar esse debate para os futurólogos. Na verdade, dependendo de como definimos consciência, a verdadeira inteligência artificial pode nunca acontecer. Podemos deixar esse debate para os filósofos e os teólogos. “ O engenho humano”, escreveu Leonardo da Vinci, cujo Homem Vitruviano se tornou o símbolo máximo da interseção entre arte e ciência, “jamais inventará alguma coisa mais bela nem mais simples nem a propósito do que a natureza produz”.

Existe, porém, ainda outra possibilidade, e dessa Ada Lovelace iria gostar; baseia-se no meio século de desenvolvimento da computação na tradição de Vannevar Bush, J. C. R. Licklider e Doug Engelbart.

SIMBIOSE HOMEM-COMPUTADOR: “WATSON, VENHA CÁ, PRECISO DE VOCÊ”

“A Máquina Analítica não tem pretensão alguma de originar qualquer coisa”, declarou Ada Lovelace. “Ela pode fazer o que quer que saibamos ordenar que ela faça.” Na mente de Ada Lovelace, máquinas não substituiriam seres humanos; elas se tornariam suas parceiras. Os seres humanos, segundo ela, trariam para esse relacionamento a originalidade e a criatividade.

Essa era a ideia por trás de uma alternativa em busca da inteligência artificial pura: buscar a inteligência aumentada que ocorre quando máquinas se tornam parceiras de pessoas. A estratégia de combinar capacidades de computadores e seres humanos, de criar uma simbiose entre homem e computador, revelou-se mais proveitosa que a de procurar construir máquinas capazes de pensar por si mesmas.

Licklider ajudou a mapear esse curso em 1960 em seu artigo “Man-Computer Symbiosis”, no qual proclamou:

Cérebros humanos e máquinas de computar serão ligados de maneira muito forte, e a parceria resultante pensará como nenhum cérebro humano jamais pensou e processará dados de um modo inacessível para as máquinas de trabalhar informações que conhecemos hoje.20

As ideias de Licklider fundamentaram-se no computador pessoal memex que Vannevar Bush imaginara em seu ensaio de 1945, “As We May Think”. Licklider também se baseou em seu trabalho no projeto do sistema de defesa aérea SAGE, que requereu uma íntima colaboração entre seres humanos e máquinas.

A abordagem Bush-Licklider ganhou uma interface amigável graças a Engelbart, que em 1968 demonstrou um sistema de computação em rede com um display gráfico intuitivo e um mouse. Em um manifesto intitulado “Augmenting Human Intelect”, ele fez eco a Licklider. O objetivo, escreveu Engelbart, devia ser criar “um domínio integrado no qual palpite, tentativa e erro, atributos intangíveis e a ‘impressão’ humana sobre uma situação coexistam com […] auxiliares eletrônicos de alta potência”. Richard Brautigan, em seu poema “All Watched Over by Machines of Loving Grace”, expressou esse sonho com um pouco mais de lirismo: “Um prado cibernético/ onde mamíferos e computadores/ vivem em harmonia/ mutuamente programável”.

As equipes que construíram o Deep Blue e Watson adotaram essa abordagem da simbiose em vez de tentar atingir o objetivo dos puristas da inteligência artificial. “O objetivo não é replicar o cérebro humano”, diz John Kelly, diretor da IBM Research. Fazendo eco a Licklider, ele acrescenta: “Não se trata de substituir raciocínio humano por raciocínio de máquina. Mais exatamente, na era dos sistemas cognitivos, homens e máquinas colaborarão para produzir melhores resultados, cada qual trazendo à parceria suas habilidades superiores”.21

Um exemplo do poder dessa simbiose homem-computador provém de uma percepção de Kasparov depois de ter sido vencido pelo Deep Blue. Até em um jogo definido por regras como o xadrez, ele concluiu, “os computadores são bons naquilo em que os seres humanos são fracos, e vice-versa”. Isso lhe deu a ideia para um experimento: “E se, em vez de seres humanos versus máquinas, jogássemos como parceiros?”. Quando ele e outro grande mestre tentaram pôr em prática essa ideia, criou-se a simbiose imaginada por Licklider: “Pudemos nos concentrar no planejamento estratégico em vez de gastar tanto tempo com cálculos”, disse Kasparov. “A criatividade humana foi ainda mais preeminente nessas condições.”

Em 2005 aconteceu um torneio nessas bases. Os jogadores podiam trabalhar em equipe com computadores de sua escolha. Muitos grandes mestres participaram da competição, ao lado de computadores avançados. Mas nem o melhor grande mestre nem o mais potente computador venceu. A vitória foi da simbiose. “As equipes do tipo ser humano-máquina dominaram até os mais fortes computadores”, observou Kasparov. “A combinação de liderança estratégica humana e acuidade tática de um computador foi avassaladora.” O vencedor não foi um grande mestre nem um computador de última geração, e nem mesmo uma combinação de ambos, mas dois amadores americanos que usaram três computadores ao mesmo tempo e souberam gerenciar o processo de colaboração com suas máquinas. Segundo Kasparov,

sua habilidade de manipular e conduzir seus computadores para examinar em grande profundidade as posições combateu de forma eficaz o entendimento superior de xadrez dos grandes mestres contra quem eles jogaram e a maior capacidade computacional de outros participantes.22

Em outras palavras, o futuro talvez pertença às pessoas mais capazes de trabalhar em parceria e colaboração com computadores.

De modo análogo, a IBM concluiu que o melhor uso para o Watson, o computador que jogou Jeopardy!, seria colaborar com seres humanos em vez de tentar vencê-los. Em um projeto, usaram-se máquinas para trabalhar em parceria com médicos em planos de tratamento de câncer. “O desafio de Jeopardy! lançava o homem contra a máquina”, disse Kelly, da IBM. “Com o Watson e a medicina, homem e máquina enfrentam um desafio juntos — e vão além daquilo que qualquer um dos dois poderia fazer sozinho.”23 O sistema Watson foi alimentado com mais de 2 milhões de páginas de publicações médicas e 600 mil dados de evidências clínicas, e tinha capacidade para fazer buscas em até 1,5 milhão de prontuários de pacientes. Quando um médico digitava os sintomas e informações vitais do paciente, o computador fornecia uma lista de recomendações, em ordem decrescente de confiança.24

Para ser útil, a equipe da IBM percebeu, a máquina precisava interagir com médicos humanos de modo a tornar agradável a colaboração. David McQueeney, o vice-presidente de software da IBM Research, contou que programaram uma pretensa humildade para a máquina:

Em nossa experiência inicial, os médicos, desconfiados, resistiam, dizendo: “Tenho licença para praticar a medicina e não vou admitir que um computador me diga o que fazer”. Assim, reprogramamos nosso sistema para parecer humilde e dizer: “Eis a probabilidade percentual que é útil para você, e aqui você pode verificar por si mesmo”.

Os médicos adoraram, disseram que tinham a sensação de estar conversando com um colega bem informado. “Pretendemos combinar talentos humanos, por exemplo, nossa intuição, com os pontos fortes de uma máquina, por exemplo, o escopo infinito”, disse McQueeney. “Essa combinação é mágica, pois cada um oferece algo que o outro não tem.”25

Esse foi um dos aspectos do Watson que impressionaram Ginni Rometty, engenheira com formação em inteligência artificial que assumiu o cargo de CEO da IBM no começo de 2012. “Vi Watson interagir com os médicos como um colega”, contou. “Foi a prova mais clara de que máquinas podem de fato ser parceiras dos seres humanos em vez de tentar substituí-los. Digo isso com grande convicção.”26 Seu entusiasmo foi tamanho que ela decidiu criar uma nova divisão da IBM baseada no Watson. A nova divisão recebeu um investimento de 1 bilhão de dólares e uma nova sede na área de Silicon Alley, próxima de Greenwich Village, em Manhattan. Sua missão era comercializar “computação cognitiva”, isto é, sistemas de computação capazes de levar a análise de dados a um nível superior, ensinando a si mesmos a complementar as habilidades de raciocínio do cérebro humano. Em vez de dar um nome técnico à nova divisão, Rometty chamou-a simplesmente de Watson. Ela escolheu esse nome em honra a Thomas Watson, o fundador da IBM, que dirigiu a companhia por mais de quarenta anos, mas também para evocar o companheiro de Sherlock Holmes, dr. John (“Elementar, meu caro”) Watson e o assistente de Graham Bell, Thomas (“Venha cá, quero vê-lo”) Watson. Assim, o nome ajudou a dar a ideia de que Watson, o computador, devia ser visto como um colaborador e um companheiro, e não como uma ameaça semelhante ao HAL de 2001.

Watson foi o precursor de uma terceira onda da computação, na qual se esfumou a linha que separava a inteligência humana aumentada e a inteligência artificial. “A primeira geração de computadores eram máquinas de contar e tabular”, diz Rometty, referindo-se às raízes da IBM nos tabuladores de cartões perfurados criados por Herman Hollerith para o censo de 1890. “A segunda geração consistiu em máquinas programáveis baseadas na arquitetura de Von Neumann. Precisávamos dizer a elas o que fazer.” Começando por Ada Lovelace, programadores escreveram algoritmos instruindo esses computadores, passo a passo, a executar tarefas. “Devido à proliferação de dados”, acrescenta Rometty, “não há escolha a não ser criar uma terceira geração, composta de sistemas que não são programados, aprendem.”27

No entanto, mesmo quando isso ocorrer, o processo talvez continue a se caracterizar pela parceria e simbiose com os seres humanos, em vez de ser projetado para relegar o homem à lata de lixo da história. Larry Norton, especialista em câncer de mama do Centro de Câncer Memorial Sloan-Kettering, de Nova York, fez parte da equipe que trabalhou com o Watson. “A ciência da computação irá evoluir rápido, e a medicina evoluirá com ela”, ele proclamou. “Isso é coevolução. Ajudaremos uma à outra.”28

Essa convicção de que máquinas e seres humanos se tornarão mais inteligentes juntos é um processo que Doug Engelbart chamou de “bootstrapping”*** e “coevolução”.29 Ela traz uma perspectiva interessante: talvez, por mais rápido que seja o progresso dos computadores, a inteligência artificial nunca possa superar a inteligência da parceria homem-máquina.

Suponhamos, por exemplo, que um dia uma máquina demonstre todas as capacidades mentais de um ser humano: dar a impressão de que reconhece padrões, percebe emoções, aprecia a beleza, cria arte, tem desejos, forma valores morais e se empenha por objetivos. Uma máquina dessas poderia ser capaz de passar no teste de Turing. Talvez até passasse no que poderíamos chamar de teste de Ada, ou seja, daria a impressão de ser capaz de “originar” seus próprios pensamentos além daquilo que nós, seres humanos, a programamos para fazer.

Mas ainda haveria outro obstáculo antes que pudéssemos dizer que a inteligência artificial triunfou sobre a inteligência aumentada. Podemos chamá-lo de teste de Licklider. O teste iria além de indagar se uma máquina é capaz de replicar todos os componentes da inteligência humana; perguntaria se a máquina executa essas tarefas melhor quando funciona por conta própria ou quando trabalha em conjunto com seres humanos. Em outras palavras: é possível que seres humanos e máquinas trabalhando em parceria sejam infinitamente mais poderosos do que uma máquina de inteligência artificial trabalhando sozinha?

Se a resposta for afirmativa, então a “simbiose homem-computador”, como a chamou Licklider, permanecerá triunfante. A inteligência artificial não precisa ser o Santo Graal da computação. Em vez disso, o objetivo poderia ser descobrir modos de otimizar a colaboração entre as capacidades de seres humanos e de máquinas — forjar uma parceria na qual deixamos que as máquinas façam o que fazem melhor e nos deixam fazer o que fazemos melhor.

ALGUMAS LIÇÕES DA JORNADA

Como todas as narrativas históricas, a história das inovações que criaram a era digital tem muitas vertentes. Então que lições, além do poder da simbiose homem-máquina que acabamos de discutir, podem ser tiradas da narrativa?

Antes de qualquer outra, vem a lição de que a criatividade é um processo colaborativo. A inovação provém com mais frequência de equipes do que de momentos iluminados de gênios solitários. Isso vale para todas as eras de efervescência criativa. A Revolução Científica, o Iluminismo e a Revolução Industrial tiveram suas respectivas instituições para o trabalho em colaboração e suas redes para o compartilhamento de ideias. Ainda em maior grau, isso se aplica à era digital. Por mais brilhantes que tenham sido os muitos inventores da internet e do computador, seus avanços se deveram, em grande medida, ao trabalho de equipe. Como Robert Noyce, alguns dos melhores dentre eles tenderam a parecer mais ministros de uma congregação do que profetas solitários; foram cantores de madrigal em vez de solistas.

O Twitter, por exemplo, foi inventado por uma equipe de pessoas que trabalhavam de forma colaborativa, mas também competiam bastante. Quando um dos cofundadores, Jack Dorsey, começou a receber muito reconhecimento em entrevistas da mídia, outro cofundador, Evan Williams, um empreendedor em série que antes criara o Blogger, disse a Dorsey para baixar o topete, segundo Nick Bilton, do New York Times. “Mas eu inventei o Twitter”, replicou Dorsey.

“Não, você não inventou o Twitter”, Williams retrucou. “Eu também não inventei o Twitter. Nem Biz [Stone, outro cofundador]. Ninguém inventa nada na internet. Apenas expande uma ideia que já existe.”30

Isso contém outra lição: a era digital pode parecer revolucionária, mas baseou-se na expansão de ideias legadas por gerações anteriores. A colaboração não ocorreu meramente entre contemporâneos, mas também entre gerações. Os melhores inovadores foram os que entenderam a trajetória da mudança tecnológica e pegaram o bastão de inovadores que os precederam. Steve Jobs baseou-se no trabalho de Alan Kay, que se baseou em Doug Engelbart, que se baseou em J. C. R. Licklider e Vannevar Bush. Quando Howard Aiken estava inventando seu computador digital em Harvard, inspirou-se em um fragmento que ele encontrou da Máquina Diferencial de Charles Babbage e fez seus companheiros de equipe ler as “Notas” de Ada Lovelace.

As equipes mais produtivas foram as que reuniram pessoas com um amplo espectro de especialidades. Os Laboratórios Bell são um exemplo clássico. Em seus longos corredores na suburbana Nova Jersey trabalhavam físicos teóricos, físicos experimentais, cientistas de materiais, engenheiros, alguns empresários e até alguns técnicos que subiam em postes telefônicos e tinham graxa debaixo das unhas. Walter Brattain, físico experimental, e John Bardeen, físico teórico, partilhavam um espaço de trabalho como um libretista e um compositor que dividem o assento ao piano: um dueto que investigava como manipular o silício para produzir o que se tornou o primeiro transístor.

Embora a internet proporcionasse uma ferramenta para colaborações virtuais e à distância, outra lição da inovação na era digital é que, tanto hoje como no passado, a proximidade física é benéfica. Há nos encontros pessoais algo especial que não pode ser replicado digitalmente, como se evidenciou nos Laboratórios Bell. Os fundadores da Intel criaram um espaço de trabalho aberto e espraiado voltado para a equipe, no qual os empregados, de Noyce para baixo, viviam topando uns com os outros. Esse modelo se tornou comum no Vale do Silício. As predições de que ferramentas digitais permitiriam a telecomutação aos trabalhadores nunca se realizaram de modo pleno. Uma das primeiras medidas tomadas por Marissa Mayer como CEO do Yahoo! foi desincentivar a prática de trabalhar em casa, salientando, com razão, que “as pessoas são mais cooperadoras e inovadoras quando estão juntas”. Quando Steve Jobs criou uma nova sede para a Pixar, preocupou-se com o modo como deveria ser construído o átrio e até com a localização dos banheiros, para que possibilitassem encontros fortuitos e proveitosos entre seu pessoal. Uma das derradeiras criações de Jobs foi o projeto da nova sede característica da Apple, um círculo com anéis de espaços abertos em torno de um pátio central.

Por toda a história, a melhor liderança veio de equipes que combinaram pessoas que tinham estilos complementares. Foi o que ocorreu na fundação dos Estados Unidos. Entre os líderes havia um ícone de probidade, George Washington, pensadores brilhantes como Thomas Jefferson e James Madison, homens visionários e impetuosos como Samuel e John Adams, e um sábio conciliador, Benjamin Franklin. De modo análogo, entre os fundadores da Arpanet houve visionários, como Licklider, engenheiros que eram objetivos ao tomar decisões, como Larry Roberts, porta-vozes politicamente hábeis, como Bob Taylor, e tocadores de projeto cooperadores, como Steve Crocker e Vint Cerf.

Outra providência importante para escalar uma grande equipe é juntar visionários, capazes de gerar ideias, com gerentes de operação, capazes de executá-las. Visões sem execução são alucinações.31 Robert Noyce e Gordon Moore foram visionários, daí a importância de seu primeiro contratado na Intel ter sido Andy Grove, que sabia impor procedimentos gerenciais objetivos, forçar as pessoas a manter o foco e conseguir que as coisas fossem feitas.

Visionários que não contam com equipes como essas só costumam entrar na história como meras notas de rodapé. Persiste um velho debate histórico sobre quem mais merece ser considerado o inventor do computador digital: John Atanasoff, um professor que trabalhou quase sozinho na Universidade Estadual de Iowa, ou a equipe liderada por John Mauchly e Presper Eckert na Universidade da Pensilvânia. Neste livro, dei mais crédito a membros do segundo grupo, em parte porque foram capazes de fazer sua máquina, o ENIAC, funcionar e resolver problemas. Conseguiram isso graças à ajuda de dezenas de engenheiros e mecânicos, além de uma equipe de mulheres que se incumbiram dos trabalhos de programação. A máquina de Atanasoff, em contraste, nunca funcionou de maneira plena, em parte porque ele não tinha uma equipe para ajudá-lo a descobrir como fazer operar seu gravador da máquina de cartões perfurados. A invenção acabou jogada em um porão e por fim descartada quando ninguém se lembrava mais para que exatamente ela servia.

Assim como o computador, a Arpanet e a internet foram projetadas por equipes colaborativas. As decisões eram tomadas segundo um processo, iniciado por um respeitoso aluno de pós-graduação, que consistia em distribuir propostas classificadas como “pedidos de comentários”. Isso gerava uma rede de comutação de pacotes nos moldes da web, sem autoridade central ou hubs, na qual o poder se distribuía totalmente por todos os nodos, cada qual dotado da capacidade de criar e compartilhar conteúdo e contornar tentativas de impor controles. Assim, um processo colaborativo produzia um sistema projetado para facilitar a colaboração. A internet foi impressa com o DNA de seus criadores.

O DNA da internet teve outra contribuição: ela foi fundada por gente do Pentágono e do Congresso que desejava um sistema de comunicações capaz de sobreviver a um ataque nuclear. Os pesquisadores da Arpa não divulgaram esse objetivo, e nem sequer o conheciam; naquela época, muitos deles estavam evitando o recrutamento militar. Isso criou uma doce ironia: um sistema financiado, em parte, para facilitar o comando e controle acabou solapando a autoridade central. A rua encontra seus próprios usos para as coisas.

A internet facilitou a colaboração não só no âmbito de cada equipe, mas também entre multidões de pessoas que não se conheciam. Esse é o avanço mais próximo de ser revolucionário. Redes de colaboração existem desde que os persas e os assírios inventaram sistemas postais. Mas nunca antes fora fácil solicitar e cotejar contribuições de milhares ou milhões de colaboradores desconhecidos. Isso ensejou sistemas inovadores — a classificação de páginas do Google, os verbetes da Wikipedia, o navegador Firefox, o software GNU/Linux — baseados na sabedoria coletiva de multidões.

As equipes na era digital eram formadas de três maneiras. A primeira, por meio de financiamento e coordenação do governo. Assim foram organizados os grupos que construíram os primeiros computadores (Colossus, ENIAC) e redes (Arpanet). Isso refletiu o consenso, que foi mais acentuado nos anos 1950 sob o presidente Eisenhower, de que o governo devia implementar projetos, como o programa espacial e o sistema de rodovias interestaduais, que favorecessem o bem comum. Com frequência o governo atuou nessa área em colaboração com universidades e empresas privadas como parte de um triângulo governamental-acadêmico-industrial impulsionado por Vannevar Bush e outros. Burocratas federais talentosos (nem sempre um oximoro), como Licklider, Taylor e Roberts, supervisionaram os programas e alocaram as verbas públicas.

A iniciativa privada foi outro caminho para a formação de equipes colaborativas. Elas surgiram nos centros de pesquisas de grandes empresas, como os Laboratórios Bell e o Xerox PARC, e em novas companhias empreendedoras, como Texas Instrument e Intel, Atari e Google, Microsoft e Apple. Um dos principais propulsores era o lucro: a recompensa para os participantes e também um modo de atrair investidores. Isso requereu uma atitude de posse das inovações, que por sua vez gerou patentes e proteções à propriedade intelectual. Muitos teóricos digitais e hackers depreciaram esse caminho, mas um sistema de iniciativa privada que recompensava a invenção em termos financeiros contribuiu para a criação de inovações sensacionais em transístores, chips, computadores, telefones, dispositivos e serviços da web.

Ao longo de toda a história existiu um terceiro modo, ao lado do governo e das empresas privadas, para organizar a criatividade colaborativa: colegas trocando ideias livremente e fazendo contribuições como parte de um esforço comum voluntário. Muitos dos avanços que criaram a internet e seus serviços ocorreram dessa maneira, que o acadêmico Yochai Benkler, de Harvard, chamou de “commons-based peer production” [produção cooperativa com recursos compartilhados].32 A internet permitiu essa forma de colaboração em uma escala muito maior do que antes. A formação da Wikipedia e da web são bons exemplos, junto com a criação de software gratuito e de código aberto como o Linux e o GNU, o OpenOffice e o Firefox. Como observou o jornalista de tecnologia Steven Johnson, “sua arquitetura aberta facilita que outros tomem por base ideias existentes e as desenvolvam, como fez Berners-Lee quando criou a web sobre os alicerces da internet”.33 Essa produção cooperativa com recursos compartilhados era movida não por incentivos financeiros, mas por outras formas de recompensa e satisfação.

Os valores do compartilhamento cooperativo com frequência conflitaram com os da iniciativa privada, sobretudo no grau em que as inovações deviam ser protegidas por patente. A produção cooperativa teve raízes na ética hacker e veio do Tech Model Railroad Club do MIT e do Homebrew Computer Club. Steve Wozniak foi um dos expoentes. Comparecia às reuniões do Homebrew para exibir o circuito de computador que havia construído e distribuía gratuitamente os esquemas para que outros pudessem usá-los e aperfeiçoá-los. Mas seu vizinho de bairro, Steve Jobs, que começou a acompanhá-lo nas reuniões, convenceu-o de que deviam parar de compartilhar a invenção, melhorá-la e vendê-la. Assim nasceu a Apple, e nos quarenta anos seguintes a empresa esteve na vanguarda do registro de patentes e do lucro com suas inovações. Os instintos dos dois Steves foram úteis para a criação da era digital. A inovação é mais vibrante nas esferas onde os sistemas abertos competem com sistemas proprietários.

Há quem defenda um desses modos de produção em detrimento dos outros com base em sentimentos ideológicos. Preferem um papel maior do governo, ou exaltam a iniciativa privada, ou ainda romantizam o peer sharing. Na eleição de 2012, o presidente Barack Obama acirrou a polêmica dizendo a empresários privados: “Vocês não construíram isso”. Seus críticos interpretaram a declaração como um aviltamento da iniciativa privada. Obama quis dizer que qualquer empresa se beneficia do apoio do governo e da comunidade que compartilha recursos:

Se vocês tiveram êxito, alguém ao longo do caminho os auxiliou. Houve um excelente professor em algum momento da sua vida. Alguém ajudou a criar este inacreditável sistema americano que permitiu a vocês prosperar. Alguém investiu em estradas e pontes.

Não foi um modo muito elegante de dissipar a fantasia de que ele era um socialista enrustido, mas ressaltou uma lição da economia moderna que se aplica à inovação na era digital: combinar todas essas maneiras de organizar a produção — pelo governo, pelo mercado e pelo compartilhamento cooperativo — é mais forte do que privilegiar apenas uma delas.

Nada disso é novo. Babbage obteve a maior parte de sua verba do governo britânico, que era generoso ao financiar estudos capazes de fortalecer sua economia e seu império. Ele adotou ideias da iniciativa privada, em especial os cartões perfurados que haviam sido criados nas tecelagens para os teares automáticos. Babbage e seus amigos fundaram um punhado de novos clubes de compartilhamento cooperativo, entre eles a British Association for the Advancement of Science, e, embora possa parecer exagero considerar esse venerável grupo um precursor encartolado do Homebrew Computer Club, ambos existiram para facilitar a colaboração entre pares e o compartilhamento de ideias.

Os empreendimentos mais bem-sucedidos da era digital foram encabeçados por líderes que promoveram a colaboração e ao mesmo tempo forneceram uma visão clara. Com demasiada frequência essas características são consideradas conflitantes: ou um líder delega demais ou é um visionário fervoroso. Mas os melhores líderes podem ser as duas coisas. Robert Noyce é um bom exemplo. Ele e Gordon Moore impeliram a Intel para o sucesso baseados em uma nítida visão dos rumos que estava tomando a tecnologia dos semicondutores, e ambos eram democráticos e antiautoritários até demais. Mesmo Steve Jobs e Bill Gates, com todo o seu ardor irascível, souberam se cercar de equipes fortes e inspirar lealdade.

Muitos indivíduos brilhantes que não foram capazes de colaborar fracassaram. O laboratório Shockley Semiconductor desintegrou-se. Da mesma forma, naufragaram grupos colaborativos desprovidos de visionários arrebatados e obstinados. Após inventarem o transístor, os Laboratórios Bell perderam o rumo. E o mesmo se deu com a Apple depois que Steve Jobs foi afastado em 1985.

A maioria dos inovadores e empreendedores bem-sucedidos mencionados neste livro teve uma coisa em comum: a dedicação ao produto. Preocupavam-se com engenharia e design, áreas que entendiam a fundo. Seu interesse principal não era o marketing, e tampouco a venda ou as finanças; nas empresas conduzidas por líderes oriundos dessas três últimas áreas, com frequência a inovação sustentada saiu perdendo. “Quando o pessoal das vendas dirige a empresa, o pessoal da produção não tem muita importância, e boa parte simplesmente se desinteressa”, disse Jobs. Larry Page pensava da mesma forma: “Os melhores líderes são aqueles que têm um conhecimento mais aprofundado de engenharia e design de produtos”.34

Outra lição da era digital é tão antiga quanto Aristóteles: “O homem é um animal social”. O que mais poderia explicar o radioamadorismo e a faixa do cidadão ou seus sucessores, como o WhatsApp e o Twitter? Quase toda ferramenta digital, quer tenha sido projetada para isso, quer não, foi apropriada por seres humanos com um propósito social: criar comunidades, facilitar a comunicação ou a colaboração em projetos e permitir contatos em redes sociais. Até o computador pessoal, que em sua origem foi adotado como uma ferramenta para a criatividade individual, inevitavelmente levou à ascensão dos modems, dos serviços on-line e, por fim, do Facebook, do Flickr e do Foursquare.

As máquinas, em contraste, não são animais sociais. Não se inscrevem no Facebook por vontade própria, não procuram companhia por gosto. Quando Alan Turing disse que um dia as máquinas se comportariam como seres humanos, seus críticos argumentaram que elas nunca seriam capazes de demonstrar afeto ou ansiar por intimidade. Para satisfazer Turing, talvez pudéssemos programar uma máquina para fingir afeição ou desejo por intimidade, como certos seres humanos também fazem. Mas é provável que ele, mais do que ninguém, percebesse a diferença.

Se prosseguirmos com a segunda parte da citação de Aristóteles, a natureza não social do computador indica que ele é “ou um animal ou um deus”. Na verdade, não é nenhuma dessas coisas. Apesar de todas as proclamações dos engenheiros da inteligência artificial e dos sociólogos da internet, as ferramentas digitais não têm personalidade, intenção ou desejos. Elas são o que fazemos delas.

A ÚLTIMA LIÇÃO DE ADA: A CIÊNCIA POÍTICA

Isso traz uma última lição, que nos leva de volta a Ada Lovelace. Como ela ressaltou, em nossa simbiose com máquinas, nós, seres humanos, trouxemos para a parceria um elemento crucial: a criatividade. A história da era digital — de Bush a Licklider, de Engelbart a Jobs, do SAGE ao Google, da Wikipedia a Watson — veio reforçar essa ideia. E enquanto permanecermos uma espécie criativa, é provável que isso continue sendo verdade. “As máquinas serão mais racionais e analíticas”, diz John Kelly, diretor de pesquisas da IBM. “As pessoas entrarão com a avaliação, a intuição, a empatia, uma bússola moral e a criatividade humana.”35

Nós, seres humanos, podemos permanecer relevantes em uma era de computação cognitiva porque somos capazes de pensar de modos diferentes, algo que um algoritmo, quase por definição, não pode dominar. Possuímos uma imaginação que, como disse Ada, “junta coisas, fatos, ideias, concepções em combinações novas, originais, infinitas, sempre variáveis”. Discernimos padrões e apreciamos sua beleza. Tecemos informações em narrativas. Além de animais sociais, somos animais que contam histórias.

A criatividade humana envolve valores, intenções, julgamentos estéticos, emoções, consciência de si e um senso moral. São coisas que as artes e as ciências humanas nos ensinam, e essa é a razão de essas áreas serem tão valiosas como parte da educação quanto a ciência, a tecnologia, a engenharia e a matemática. Se nós, mortais, quisermos defender o nosso lado na simbiose homem-computador, se quisermos conservar um papel como parceiros criativos das nossas máquinas, temos de continuar a alimentar os mananciais da nossa imaginação, originalidade e humanidade. É com isso que contribuímos para a parceria.

Nos lançamentos de seus produtos, Steve Jobs concluía com um slide projetado na tela atrás de si mostrando placas de rua que indicavam a interseção das ciências humanas com a tecnologia. Em sua última apresentação desse tipo, no lançamento do iPad 2 em 2011, ele declarou, diante dessa imagem: “Está no DNA da Apple a ideia de que a tecnologia, sozinha, não basta — é a tecnologia casada com as artes, casada com as ciências humanas, que nos dá o resultado de alegrar o coração”. Essa postura fez dele o mais criativo inovador em tecnologia da nossa era.

O inverso dessa ode às humanidades também vale. Pessoas que amam as artes e as ciências humanas também deveriam fazer um esforço para apreciar as belezas da matemática e da física, como Ada. Do contrário, serão meros circunstantes na interseção das artes com a ciência, onde ocorre a maior parte da criatividade da era digital. Entregarão o controle desse território aos engenheiros.

Muita gente que celebra as artes e humanidades, que aplaude com entusiasmo os tributos à importância dessas áreas em nossas escolas, declararia sem pudor (alguns até gracejando) que não entende nada de matemática nem de física. Essas pessoas exaltam as virtudes de saber latim, mas não têm a menor ideia de como escrever um algoritmo ou como distinguir BASIC de C++, Python de Pascal. Consideram filisteus os que não distinguem Hamlet de Macbeth, mas admitem alegremente não saber a diferença entre um gene e um cromossomo, entre um transístor e um capacitor ou entre uma equação integral e uma diferencial. Esses conceitos podem parecer difíceis. Sim, mas Hamlet também é. E, como Hamlet, cada um desses conceitos é belo. Como uma elegante equação matemática, eles são expressões das glórias do universo.

C. P. Snow estava certo sobre a necessidade de respeitar “as duas culturas”, a ciência e as humanidades. Porém ainda mais importante hoje é entender como elas se cruzam. Os que ajudaram a conduzir a revolução tecnológica foram pessoas da tradição de Ada, capazes de combinar ciência e humanidades. Do pai ela recebeu a veia poética e da mãe a inteligência matemática, e isso lhe incutiu o amor pelo que chamou de “ciência poética”. Seu pai defendeu os luditas que destruíam teares mecânicos, mas ela ficou fascinada com o modo como os cartões perfurados instruíam aqueles teares a tecer belos padrões e previu que aquela impressionante combinação de arte com tecnologia poderia se manifestar em computadores.

A próxima fase da Revolução Digital trará uma verdadeira fusão da tecnologia com indústrias criativas como a mídia, a moda, a música, o entretenimento, a educação, a literatura e as artes. Até agora, boa parte da inovação consistiu em despejar vinho velho — livros, jornais, editoriais, diários, músicas, programas de TV, filmes — em novas garrafas digitais. Mas a interação entre a tecnologia e as artes resultará, por fim, em formas de expressão e formatos de mídia totalmente novos.

Essa inovação virá de pessoas capazes de associar beleza com engenharia, humanidades com tecnologia, poesia com processadores. Em outras palavras, virá dos herdeiros espirituais de Ada Lovelace, criadores capazes de florescer onde a arte se cruza com a ciência, dotados de uma rebelde faculdade de se maravilhar que lhes permite ver a beleza de ambas.

* Termo que denota o cérebro dos seres vivos considerado em sua capacidade computacional. (N. T.)

** Neurônio é uma célula nervosa que transmite informações usando sinais elétricos ou químicos. Sinapse é uma estrutura ou trajeto que conduz um sinal de um neurônio até outro neurônio ou célula.

*** Bootstrapping, neste caso, significa progredir recorrendo aos próprios recursos, sem ajuda externa. A expressão provém da ideia de erguer-se pelos cordões das próprias botas. (N. T.)