1. Jeden Tag eine neue KI

Künstliche Intelligenz ist längst Teil unseres Alltags, und doch ist das KI-Grundlagenwissen sehr unterschiedlich verteilt. Wenige Unternehmen treiben die weltweite Entwicklung voran, wodurch Arbeitgeber in Europa unter Zugzwang geraten. Die Arbeitnehmerseite kann davon profitieren: Mit wenigen Schritten ist es heute noch möglich, die eigenen KI-Fertigkeiten zu entwickeln, um sich auf dem Jobmarkt attraktiver zu machen. Den Grundstein dafür legen wir mit diesem Kapitel.

Denn es gibt tatsächlich täglich nicht nur eine neue KI: Während der Entstehung dieses Buches sind täglich eher 20 bis 30 neue KI-Tools erschienen, wenn man allein die oft kostenfreien Möglichkeiten der weltweit größten Verzeichnisse www.futurepedia.io und www.theresanaiforthat.com für entsprechende Angebote zurate zieht. Die Spielwiese auf derartigen Plattformen ist sowohl für Privatleute als auch im beruflichen Kontext Gold wert und wir können nur dazu aufrufen, dass ihr euch besser heute als morgen ein paar dieser Werkzeuge anschaut.

Dadurch, dass viele dieser – wenn auch oft noch nicht ganz ausgereiften – Lösungen einen nennenswerten Mehrwert für die unterschiedlichsten Bereiche unserer Lebens- und Arbeitswelten erzeugen, steht für uns fest:

Jeder Mensch benötigt KI-Kenntnisse.

Also ja, der Handlungsdruck ist real. Ob ihr selbst vertiefte KI-Fertigkeiten auf- oder ausbauen wollt oder Personal sucht, das darüber verfügt: Künstliche Intelligenz ist wie ein Kompetenz-Tsunami, der nach und nach den Arbeitsmarkt fluten wird. Insofern raten wir dazu, lieber früher als später die entsprechenden Vorkehrungen dafür zu treffen. Insofern gilt: KI jetzt!

Was genau ist eigentlich Künstliche Intelligenz?

Bevor wir tiefer in unser Thema einsteigen, möchten wir eine Definition von Künstlicher Intelligenz wagen. Gar kein leichtes Unterfangen, denn KI ist keine einzelne Technologie, sondern vielmehr ein Sammelbegriff für unterschiedliche technologische Lösungsansätze und Forschungsgebiete. Doch nicht alles, was nach KI aussieht, ist tatsächlich KI. Daher brauchen wir diese Grundlage unbedingt, wenn wir uns näher mit KI befassen möchten.

Die Definition für Experten

Die in unseren Augen beste und in Fachkreisen anerkannte Definition stammt von der unabhängigen, hochrangigen Expertengruppe für KI in der Europäischen Kommission:

»Systeme der künstlichen Intelligenz (KI) sind von Menschen entworfene Software-(und möglicherweise auch Hardware-)Systeme, die angesichts eines komplexen Ziels in der physischen oder digitalen Dimension handeln, indem sie ihre Umgebung durch Datenerfassung wahrnehmen, die gesammelten strukturierten oder unstrukturierten Daten interpretieren, aus diesen Daten abgeleitetes Wissen schlussfolgern oder Informationen verarbeiten und die beste(n) Aktion(en) zur Erreichung des vorgegebenen Ziels beschließen. KI-Systeme können entweder symbolische Regeln verwenden oder ein numerisches Modell erlernen, und sie können ihr Verhalten auch anpassen, indem sie analysieren, wie die Umgebung durch ihre früheren Aktionen beeinflusst wird. Als wissenschaftliche Disziplin umfasst die KI mehrere Ansätze und Techniken, wie maschinelles Lernen (wofür Deep Learning und Reinforcement Learning spezifische Beispiele sind), maschinelles Denken (das Planung, Zeitplanung, Wissensdarstellung und Schlussfolgerungen, Suche und Optimierung umfasst) und Robotik (die Steuerung, Wahrnehmung, Sensoren und Aktoren sowie die Integration aller anderen Techniken in cyber-physische Systeme umfasst).«2

Deep Learning (DL)

Deutsch: tiefes Lernen. Es handelt sich dabei um eine spezielle Methode des maschinellen Lernens, bei dem künstliche neuronale Netze mit vielen Zwischenschichten verwendet werden, um bessere KI-Entscheidungen zu ermöglichen.

RL (Reinforcement Learning)

Deutsch: verstärkendes Lernen. Eine Unterart von maschinellem Lernen, bei dem die KI – ähnlich wie ein Mensch – Aufgaben lösen muss und dafür Belohnungen erhält, um selbstständig Strategien zur Problemlösung zu testen. Der Begriff stammt aus den 1950er-Jahren, aus der Kybernetik.

Die einfachere Definition

Puh. Lasst uns das etwas vereinfachen:

- ■ Kurz: KI-Anwendungen sind technische Einrichtungen, die computergestützt Daten verarbeiten und autonom Entscheidungen treffen.

- ■ Variante für Laien: KI ist, wenn eine Maschine Probleme lösen kann, die bisher nur Menschen lösen konnten.

Wenn wir von Künstlicher Intelligenz sprechen, meinen wir also in der Regel lernende Computersysteme. Diese funktionieren mithilfe von Algorithmen, also programmierten Rechenvorgängen, die ein bestimmtes Ziel erreichen sollen. Daher ist vor allem das Konzept des maschinellen Lernens wichtig.3

Wir haben außerdem die wichtigsten Begriffe im Umfeld von KI notiert und gewichtet. Dabei entstand folgende Wortwolke:

Man sieht auf einen Blick, dass KI offensichtlich ein sehr kompliziertes und komplexes Unterfangen ist. Wenn ihr euch mit KI befasst, müsst ihr natürlich nicht alle dieser Begriffe kennen – uns geht es an dieser Stelle nur darum zu zeigen, dass KI so viel mehr ist als maschinelles Lernen oder ChatGPT. Das, was ihr als KI-Anwendungen aus dem Alltag oder dem Unternehmen kennt, ist nur die Spitze des Eisbergs.

Ganz wichtig: Um mit KI arbeiten zu können, müsst ihr nicht sämtliche Grundlagen verstehen, sondern nur die wichtigsten Zusammenhänge. Schließlich sind die wenigsten von uns in der Lage, ein Stromnetz und die nötigen Schaltkreise für eine funktionierende Versorgung mit Elektrizität im Haushalt herzustellen – wir drücken einfach den Stromstecker in die Steckdose.

Schwache und starke KI

KI lässt sich in eine »schwache« und eine »starke« Variante unterscheiden:

- ■ Schwache KI ist alles, was wir jetzt schon an KI-Anwendungen sehen.

- ■ Eine starke KI wäre gegeben, wenn eine Maschine oder Software plötzlich eigenständige Motive oder Lösungswege aufzeigt, die wir Menschen nicht mehr nur nicht verstehen (das ist heute schon bei manchen Systemen der Fall), sondern die ohne Erteilung einer Aufgabe zu komplett autonomen Handlungen führt. Ein anderer Begriff für »starke KI« ist AGI, die Artificial General Intelligence, oder auch AKI, die Allgemeine Künstliche Intelligenz. In Kapitel 6 beschäftigen wir uns etwas näher damit.

Mit den aktuellen Mitteln und basierend auf klassischen Silizium-Computerchips wird diese starke KI jedoch nicht erreicht werden – auch wenn das gern behauptet wird. Das Hauptmotiv für die Firmenchefs sehr großer KI-Unternehmen aus den USA, solche eher bedrohlichen Entwicklungen öffentlichkeitswirksam zu verbreiten, liegt auf der Hand: Sie betreiben damit Marketing und verunsichern nicht nur die Bevölkerung, sondern auch die Gesetzgeber. Letzteres hat nachweislich dazu geführt, dass der Gesetzgebungsprozess in der Europäischen Union zum EU AI Act deutlich aufgehalten wurde. Auf den Internetseiten des Europäischen Rates findet sich die Pressemitteilung zum EU AI Act.4

»Vertrauen in die KI«

Zwar nutzt inzwischen jeder dritte Mensch in Deutschland KI-Systeme wie ChatGPT, doch das übergreifende Vertrauen in KI-Entscheidungen beispielsweise in der Medizin, im Verkehr oder für Unternehmensstrategien ist nach wie vor niedrig ausgeprägt. Grund für das Misstrauen sind Betrugs- und Desinformations-Fälle, die mithilfe von KI durchgeführt und in den Medien groß herausgestellt werden – größer als die lebensrettenden oder umsatzsteigernden Anwendungen, die dank KI realisiert werden.

Zudem existiert eine Wahrnehmungsverzerrung in vielen Organisationen: Viele Führungskräfte unterstellen ihren Beschäftigten, dass diese Angst vor KI hätten, weil dadurch womöglich ihr Job gefährdet werden würde (auch bekannt als FOBO: fear of becoming obsolete, dt.: die Angst, ersetzt zu werden). Die Beschäftigten wiederum würden sich selbst allerdings oft die Einbindung in KI-Entwicklung wünschen, da sie sich dadurch Arbeitserleichterung erhoffen. Für das Gelingen jedes KI-Projekts ist es daher erfolgskritisch, vorher eine offene Kommunikation über die geplanten Schritte zu pflegen und auch Bedenken transparent zu besprechen.

Die europäische Wirtschaft hatte die große Befürchtung, dass diese Regulation zu streng ausfallen könnte. Zum Zeitpunkt, da dieses Buch in den Druck geht, ist das Ergebnis noch nicht öffentlich verfügbar (nur ein Leak des Entwurfs)5, doch es deutet sich eine gewisse Harmonisierung an, was zu einem finalen Durchbruch in der Verbreitung von KI in Europa beitragen könnte.

Was KI nicht ist

Großartig! Jetzt haben wir einen Überblick darüber, was KI ist. Doch nicht alles, was wie KI aussieht, ist auch KI. In diese Rubrik gehören beispielsweise einfache Big Data-Analysen, das heißt, Auswertungen aus sehr großen Datenmengen. Big Data ist zwar einerseits die Grundlage für sämtliche KI-Anwendungen, denn ohne Daten kann weder eine Maschine noch eine Software »wissen«, was zu tun ist. Andererseits steckt nicht in jeder Schlussfolgerung auf der Basis von Big Data zwangsläufig KI.

Big Data

Deutsch: große Datenmengen. Im Zuge der Digitalisierung und der Datafizierung fallen immer mehr große Datenmengen an, die für herkömmliche Methoden der manuellen oder IT-Datenverarbeitung zu umfangreich sind. Big Data ist allerdings auch ein Sammelbegriff für Methoden und Technologien im neueren IT-Umfeld.

Ebenso enthalten statistische Modelle nicht unbedingt KI, beispielsweise die Vorausberechnung einer Lagerlogistik. Diese basiert zwar auf umfangreicher Programmierung und ebenfalls vielen Daten, doch in der Regel greift man hier nur auf historisches Wissen zurück. Wenn am 13. April 2021, 2022 und 2023 die Verteilung von bestimmten Paketen auf eine bestimmte Art und Weise organisiert war, wird ein einfaches IT-System genau dieselbe Organisation mit einer vorher klar definierten Abweichung zum Mittelwert auch für das Jahr 2024 vorschlagen. Wenn dann aber ein Unwetter, der Ausfall eines Lieferanten oder sogar eine Pandemie dazwischenkommt, liefert das System unsinnige Empfehlungen.

Viele Roboter, so z. B. Rasenmäher-, Staubsauger- oder Industrieroboter, sind ebenfalls nicht KI-basiert, auch wenn sie möglicherweise so wirken. Zwar verfügen diese Geräte über jede Menge Computerchips und Sensorik, doch die Software dahinter ist oft nicht viel mehr als ein kompliziertes Regelwerk. Ihr könnt euch das nach einer einfachen »wenn dies, dann das«-Logik vorstellen:

Wenn der Saugroboter mit seiner Kamera ein Hindernis erkennt, dann drosselt er die Geschwindigkeit, umfährt es oder dreht um. Das macht er so lange, bis sein Akku leer oder der Auffangbehälter voll ist. Er kommt nicht selbstständig auf die Idee, vorher den Raum auf Hindernisse zu scannen oder sich die störenden Möbel zu merken, wenn dies nicht programmiert ist. (Ausnahmen bestätigen die Regel: Ab 2024 soll der erste Saugroboter [»Matic«] auf den Markt kommen, der tatsächlich KI einsetzt.)

Wenn eine Arbeitskraft an einer Produktionsstraße ein Werkteil in den Roboterarm legt, dann verwendet dieser seinen Schwenkarm, um das Schweißgerät anzusetzen und die Naht zu schließen. Das Teil muss aber exakt positioniert sein, und die Maße und Erkennungszeichen wie eine Naht oder Markierung sind jedes Mal identisch. Der Industrieroboter käme nicht allein auf die Idee, einen Schritt davor oder danach eigenständig zu optimieren. Er lernt nicht dazu. Alles, was nicht vorher bedacht und einprogrammiert wurde, kann der Roboter dann nicht verarbeiten.

Erst wenn das System in der Lage ist, aus den Umgebungsdaten eigenständig zu lernen, oder wenn eine fortgeschrittene Steuerung per Sprache integriert ist, kann man von KI-Systemen sprechen. Manchmal sind die Übergänge jedoch fließend.

Nicht alles, was wie KI aussieht, ist auch KI.

Und umgekehrt.

Hier sind einige Beispiele für KI-Anwendungen und solche, die vielleicht so wirken, aber es in der Regel nicht sind:

Das ist KI |

Das ist (in der Regel) keine KI |

Sprachassistenten wie Alexa, Siri, Cortana, Bixby |

Hausroboter |

Anzeige von Werbung und Social Media Posts bei X, Facebook, Tiktok etc. |

Einfache Industrieroboter |

Objekterkennung in Fahrzeugen |

Wetterprognosen |

Moderne Betrugserkennung |

Empfehlungssysteme von Netflix oder Amazon |

MRT-Diagnostik mit Watson |

Business Intelligence Tools |

Vorausschauende Wartung |

Regelbasierte Preisanpassung |

ChatGPT – der Anbruch einer neuen Ära

Mit Erscheinen von ChatGPT brach im November 2022 eine neue Ära der künstlichen Intelligenz an.

Warum?

Dank der Entwicklung des interaktiven Sprachmodells schaffte das Unternehmen hinter ChatGPT, OpenAI, etwas, das renommierte Firmen wie Meta, Microsoft und Google trotz zahlreicher Versuche bislang nicht geschafft hatten: einen KI-Chatbot für die Massen zu entwickeln. (ChatGPT ist natürlich nicht das einzige System, das diesen Weg ging. Auch ein deutsches Unternehmen – Aleph Alpha – oder das ebenfalls von einem Deutschen entwickelte You.com sind gut aufgestellt, nur weniger bekannt.) Das Erscheinen von ChatGPT markiert eine Zeitenwende in der Geschichte der KI, ähnlich wie die Einführung des iPhones 2007 für die Telekommunikation, der Sputnik-Schock 1957 für die Geopolitik oder die Verbreitung elektrischen Stroms gegen Ende des 19. Jahrhunderts für die wirtschaftliche Produktivität.

EXKURS

Der »Werdegang« von ChatGPT

Einer der größten Investoren des Unternehmens OpenAI, das für ChatGPT verantwortlich ist, ist der Tech-Gigant Microsoft. Weder das Unternehmen OpenAI noch die Technologie hinter ChatGPT sind komplett neu, das erste GPT stammt wie bereits erwähnt aus dem Jahr 2017. Doch ausgestattet mit mehreren Milliarden Dollar hatte OpenAI in den letzten Jahren die beste Ausgangsposition, um die KI-Programmierung zu optimieren und das große Sprachmodell (LLM) GPT-3 zu trainieren. Es umfasste 175 Milliarden Parameter, also Worte und auch Bedeutungszusammenhänge mehrerer Wörter.

Ende 2022 veröffentlichte OpenAI dann mit der GPT-Version 3.5 auch die Chat-Schnittstelle namens ChatGPT. Kurze Zeit später baute Microsoft das Sprachmodell in seine Suchmaschine Bing ein und stieß damit über Nacht das bis dato unangefochtene Google vom Thron der Suchmaschinen. So viel zur wirtschaftlichen Motivation. Inzwischen ist GPT-4 verfügbar und basiert auf schätzungsweise einer Billion Parametern.

Tatsächlich ist KI längst Teil unseres digitalen Alltags, auch wenn wir sie oft gar nicht wahrnehmen. Denn genau genommen sind zumindest wir in Europa seit Jahren Nutznießer von KI.

Wer sich schon einmal mit Alexa oder Siri unterhalten hat, nutzt KI-Sprachassistenten, die auf natürlicher Sprachverarbeitung (NLP) basieren. Die Sprach-KI wurde mit unzähligen Sprachaufnahmen trainiert, um selbst Dialekte einigermaßen zu verstehen und dann die entsprechenden Befehle auszuführen.

Alexa

Sprachassistent von Amazon, der seit einigen Jahren im Umlauf ist und eine Sprachschnittstelle zum Internet anbietet. Erstmals wurde Alexa im intelligenten Lautsprecher »Amazon Echo« verbaut, ist inzwischen aber auch auf Geräten anderer Hersteller verwendbar. Klassischer Anwendungsfall ist es, per Sprachbefehl Aktionen wie Musikprogramm oder -lautstärke sowie Informationsabfragen zu delegieren, Alexa kann aber auch für die Hausautomation eingesetzt werden. Damit ist Alexa der älteste KI-Anwendungsfall für NLP (Natural Language Processing) im Massenmarkt.

NLP (Natural Language Processing)

Deutsch: natürliche Sprachverarbeitung oder Computerlinguistik. Gemeint sind Systeme, die natürliche Sprache von Menschen erkennen und verarbeiten können. Dazu zählen Sprachassistenten wie Alexa und Siri oder moderne Übersetzungstools wie DeepL.

Wer Musik oder Podcasts über Spotify, Apple Podcasts oder Amazon Music hört, profitiert von KI, die anhand der eigenen Nutzungs- und Hörgewohnheiten individuelle Empfehlungen erzeugt. Dahinter stecken die Klassifizierung der Musik und ein ausgeklügelter Algorithmus, der die individuellen Vorlieben der User mit dem Angebot abgleicht. Alle bekommen individuelle Vorschläge.

Auch wer gelegentlich eine Suchmaschine konsultiert – also wohl fast alle –, macht sich KI-Power zunutze. Und wer sich dabei schon einmal über die teilweise sehr passgenauen Werbeanzeigen gewundert hat, die Inhalte darbieten, über die man sich gerade erst mit einer Kollegin unterhalten hat, wird auch an dieser Stelle mittels KI adressiert.

Dasselbe gilt übrigens auch für die Auswahl der Beiträge in den sogenannten »sozialen« Medien wie Facebook, Instagram, Tiktok, X (ehemals Twitter) und Co. Deren Ziel ist es, euch länger auf der Plattform zu behalten, da sie nämlich Geld damit verdienen, dass euch Werbeanzeigen angezeigt werden, die nicht komplett irrelevant sind. Und das erreichen sie, indem ihr relevante Werbeanzeigen seht, die wiederum zu den Beiträgen eurer Freund:innen und Bekannten passen, die ihr euch anschaut.

Selbst beim Einkaufen kommt ihr indirekt mit KI in Berührung, wenn ihr in größeren Supermärkten shoppen geht: Die Lieferketten moderner Lebensmitteleinzelhändler sind längst KI-optimiert. Das Sortiment unterscheidet sich regional und saisonal, die Steuerung wird aber kaum noch von menschlichen Einkäufern bestimmt – sondern von KI.

Nicht zuletzt kommt selbst die Zeitungsleserschaft in den Genuss der Technologie: Einfache Texte wie die Wettervorhersage, Horoskope oder Sportergebnisse werden in größeren Verlagen seit Jahren von KIs geschrieben, die ähnlich wie ChatGPT funktionieren – nur bisher ausschließlich auf der Grundlage strukturierter Daten. Einige selbst größere Newsportale stellen aktuell komplett auf KI-Redaktionen um.

All diese Anwendungszwecke waren bislang jedoch auf sehr eingeschränkte Funktionen optimiert. Eine herkömmliche Suchmaschine kann zwar in atemberaubender Geschwindigkeit Milliarden von Internetseiten nach den eingegebenen Suchbegriffen durchforsten und sie in eine (mehr oder weniger) sinnvolle Reihenfolge bringen, sie kann aber keine Musikempfehlung geben, Supermarktregale befüllen oder die Sportnachrichten schreiben. Das Atemberaubende an ChatGPT ist: Es kann selbst komplizierte Texteingaben in allen Sprachen verarbeiten, sinnvolle Antworten liefern und über Schnittstellen zu anderen Systemen aktuelle Quellen einbeziehen. Und das innerhalb sehr kurzer Zeit und auch mit unstrukturierten Daten.

ChatGPT »versteht« Sprache

und ist praktisch einsetzbar für alle.

Noch wichtiger für unsere Zwecke ist aber Folgendes: ChatGPT bietet Schnittstellen zu anderen Diensten an. In der Premiumvariante können Unternehmen und Entwickler:innen relativ einfach und auch ohne fortgeschrittene Kenntnisse Lösungen erschaffen, um zum Beispiel einen Chatbot für die eigene Website zu erstellen – basierend auf den eigenen Angaben – oder Blogbeiträge im eigenen Schreibstil verfassen zu lassen. Auch die Anbindung an Drittanbieter wie Videoplattformen ist möglich, sodass Transkripte von YouTube-Videos im Handumdrehen extrahiert werden können. Hier liegt auch der zukünftige Kern des Geschäftsmodells: Durch Anbindung an beliebige Unternehmen oder Maschinen verdient OpenAI bei jedem KI-Prozess mit – so, wie Apple an jedem App-Verkauf im Apple Store eine Provision erhält. Damit sichert sich OpenAI voraussichtlich für lange Zeit die Pole-Position im Markt der generativen KI und finanziert vor allem die horrenden Investitionen.

In dem Moment, in dem das System also textbasierte Beschreibungen erhält, kann es damit weiterarbeiten. Selbst auf der Basis des frei verfügbaren Sprachmodells liefert es plausible Texte, was sehr schnell auch Studierende, Schüler:innen und die Werbebranche zum eigenen Vorteil erkannt haben. Auf die Risiken, die durch den Einsatz von KI entstehen, gehen wir in einem späteren Unterkapitel ein. Allerdings geht es in diesem Buch vorrangig um die Vorteile und Einsatzmöglichkeiten dieser und ähnlicher Systeme.

Die wichtigste Erkenntnis aus unserer Praxis lautet: Prozesse müssen gar nicht mehr standardisiert und digitalisiert werden, sondern können mittels einfacher Sprache digital an ChatGPT übermittelt werden.

Mit ChatGPT endet die Management-Ära,

in der eine umfassende Standardisierung der Prozesse

fester Bestandteil der Agenda war.

Die Schattenseiten der KI

Durchaus etablierte und renommierte große wie auch kleine und mittlere Unternehmen können von innovativen Wettbewerbern und Angreifern vom Markt gedrängt werden, wodurch viele Arbeitsplätze gefährdet werden, heute mehr denn je. Das ist sicher eine Gefahr, die von KI ausgeht – aber nichts Neues in einem dynamischen, sich entwickelnden Markt, Stichwort »Elektrizität«. Wer bereit ist, sich auf die neuen Technologien einzulassen, kann seine Mitbewerber so möglicherweise leicht aus dem Feld schlagen. Risikobereitschaft und Mut zur Innovation lohnen sich oft. Dazu später noch mehr.

In diesem Kapitel wollen wir der Vollständigkeit halber erwähnen, dass KI-Anwendungsfälle nicht immer zur Steigerung der Produktivität oder für humanistische Zwecke eingesetzt werden und auch bei deren Nutzung nicht alles eitel Sonnenschein ist.

Zum einen ist das Training und teilweise der Betrieb von KI wahnsinnig energieintensiv: Das Training eines Sprachmodells wie ChatGPT wird auf ca. 10 Gigawattstunden (GWh) geschätzt. Der tägliche Energieverbrauch allein von ChatGPT wurde im Juli 2023 auf 1 GWh pro Tag geschätzt. Zum Vergleich: Alle deutschen Privathaushalte verbrauchen im Jahr etwa 130.000 GWh. Hinzu kommt, dass für jedes KI-Produkt Hardware in Form von sehr vielen Mikrochips benötigt wird, für deren Herstellung wiederum diverse Rohstoffe verarbeitet werden müssen. Umso wichtiger ist es, dass die weltweite Energieerzeugung möglichst schnell auf erneuerbare Quellen wie Wind, Sonne und Wasser umgestellt wird!

Ebenso entscheidend ist es, rechtzeitig die Grundlagen für KI in Organisationen zu schaffen, da die Technikpreise möglicherweise eines Tages nicht mehr aufgrund der Skaleneffekte sinken, sondern aufgrund der erwartbaren Rohstoffengpässe steigen werden – Stichwort: KI jetzt!

In der Kriegsführung spielt Künstliche Intelligenz längst eine zentrale Rolle, was dann oft als »Cyberkrieg« in den Nachrichten auftaucht. So setzen Regierungen und Nachrichtendienste KI ein, um verfeindete Staaten oder Menschen auszuspionieren, empfindliche strategische Ziele zu sabotieren oder Wahlen zu manipulieren. Das kann direkt durch IT-Angriffe passieren, bei denen Server oder wichtige Websites verändert oder lahmgelegt werden, es kann aber auch auf Umwegen passieren, wie das Beispiel der US-Präsidentschaftswahlen von 2016 eindrucksvoll gezeigt hat. Hier wurde insbesondere auf Facebook massive Desinformation betrieben, indem unter anderem die russische Regierung zunächst die Facebook-User:innen herausfand, die noch unentschieden waren, wen sie wählen sollen. Anschließend wurden diesen Menschen gezielt immer wieder Meldungen und Beiträge angezeigt, die ein bestimmtes Weltbild festigen sollten – mit Erfolg. Der Hardliner Donald Trump gewann die Wahl.

Häufig diskriminieren KI-Anwendungen eher fahrlässig bestimmte Personengruppen, weil sie schlecht trainiert wurden. Habt ihr schon mal vom »rassistischen Seifenspender« gehört? Dabei handelt es sich um eine Fehlfunktion, die von einem Twitter-User in Nigeria geschildert wurde, der in einer öffentlichen Toilette keine Seife bekam – anders als hellhäutige Menschen. Hintergrund war hier, dass die Infrarottechnik, die man für die neuen Seifenspender verwendet hatte, auf die Erkennung heller Haut optimiert war und bei dunkler Haut nicht auslöste. Dieser Fall klingt vielleicht für einige eher lustig, doch bedrohlich wird es, wenn ähnliche Fehler bei selbstfahrenden Fahrzeugen zum Einsatz kommen – hier ist die Fehlerkennung möglicherweise ein Todesurteil für dunkelhäutige Passanten.

In Personalabteilungen wird KI immer häufiger eingesetzt, um Bewerberprofile zu bewerten und die Vorauswahl für die HR-Manager:innen einfacher zu machen. Doch auch hier passieren häufig Fehler, wenn die KI beispielsweise ausschließlich mit den Profilen der bereits beschäftigten Mitarbeiter:innen trainiert wurde, diese aber aus diversen Gründen eher homogen sind. Die KI wird dann ohne Korrektiv weiterhin Menschen vorschlagen, die beispielsweise ein bestimmtes Alter, ein bestimmtes Geschlecht und eine bestimmte Hautfarbe haben.

Vermutlich haben fast alle von euch, die dieses Buch lesen, bereits mit ChatGPT oder anderen Chatbots experimentiert. Hand aufs Herz: Habt ihr die Informationen, die euch angezeigt wurden, anschließend überprüft? Moderne Chatbots haben eine faszinierende Fähigkeit, Texte zu generieren – doch sie sind manipulierbar! Das ist eine der wichtigsten Erkenntnisse, die im Umgang mit ChatGPT und anderen beachtet werden müssen. Es kommt sogar häufig vor, dass historische Fakten verdreht, rassistische oder antisemitische Behauptungen aufgestellt werden. Forschende nennen das »Halluzinationen«. Das heißt nicht, dass die Systeme an sich diskriminieren »wollen«, es unterstreicht einfach, dass sie nicht denken können. Sie sind immer nur so gut wie ihre Trainingsdaten und die einprogrammierten ethischen Rahmen. Naturgemäß haben somit US-amerikanische Chatbots auch andere ethische Prinzipien als europäische, was man besonders gut in Dilemma-Situationen eindrucksvoll ausprobieren kann. ChatGPT und Co. sollten also stets nur als Anregung oder Zwischenschritt genutzt werden; das Denken müssen grundsätzlich immer noch Menschen übernehmen!

XAI, die »Erklärbarkeit von KI«

Seit einigen Jahren ist das Thema XAI (explainable AI, dt.: erklärbare KI) wichtiger geworden. Es handelt sich um eine technische Disziplin, die die Erklärung von KI-Entscheidungen (künstliche neuronale Netze, maschinelles oder tiefes Lernen) zum Ziel hat. In vielen neueren KI-Systemen ist dies bereits implementiert: So kann man bei Sprachmodellen der generativen KI beispielsweise nachfragen, warum eine Antwort gegeben wurde.

Hintergrund ist, dass KI normalerweise in einer Art Black Box Daten verarbeitet und die Schlussfolgerungen daraus in der Regel schwer nachvollziehbar sind. Ziel von XAI-Ansätzen ist es, dass die KI selbst erklärt, wie und warum sie zu einem Ergebnis gekommen ist. Noch wichtiger als die Erklärbarkeit ist aber, dass sie eigene Vorurteile aufdeckt und bestenfalls vermeidet – dadurch wiederum können auch die Menschen in den Organisationen lernen. Der unserer Meinung nach bessere Begriff als Erklärbarkeit ist also »Nachvollziehbarkeit«.

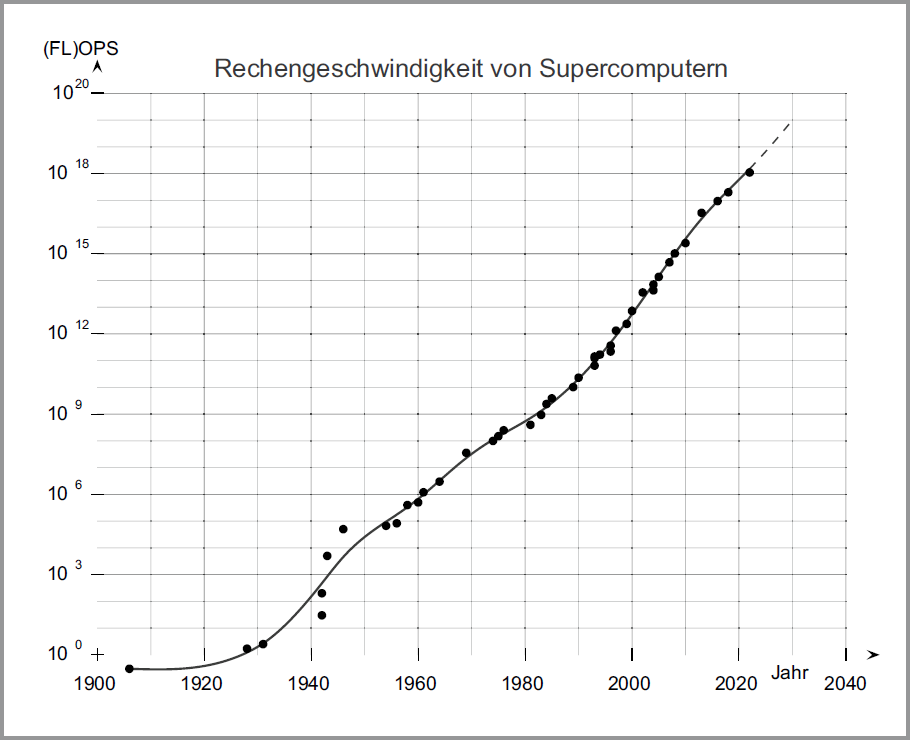

Die exponentielle Entwicklung der IT – Grundlage für die KI

Technologie entwickelt sich – anders als unsere sozialen, politischen oder wirtschaftlichen Systeme – seit einigen Jahrzehnten exponentiell. Diese Erkenntnis ist wahnsinnig wichtig, wenn man KI verstehen möchte. Daher folgt nun ein kurzer Ausflug in die Geschichte der Informationstechnologie, die uns auf wenigen Seiten quer über den Globus hetzt.

Wie alles begann

Als Konrad Zuse im Mai 1941 mit dem Z3 den ersten programmierbaren Digitalcomputer der Welt vorstellte, ahnte noch niemand, wie bedeutend dieser Moment war. (Parallel entstanden viele weitere, vergleichbare Systeme, die gelegentlich als »erster Computer der Welt« gelten. Uns geht es hier ums Prinzip, weshalb wir uns für den Z3 entschieden haben.) Und doch war es plötzlich möglich geworden, sehr komplizierte mathematische Berechnungen an eine Maschine zu delegieren, anstatt Menschen mit Rechenschiebern oder Vierspezies-Rechenmaschinen damit zu beauftragen. Der Z3 ist etwa so groß wie ein Kleinbus, und um ihn zu bedienen, mussten die Menschen umfangreiche Kenntnisse der gerade entstehenden Informatik mitbringen. Einen Nachbau des Pioniergeräts könnt ihr im Deutschen Museum in München bestaunen.

Eben weil der Z3 so groß war, konnte sich kaum jemand vorstellen, dass Computer eines Tages unerlässlich für unseren Alltag werden würden. Nicht einmal Thomas Watson, der Vorstandsvorsitzende des späteren Weltmarktführers für Computer, IBM, glaubte an deren Siegeszug und äußerte 1943 seine inzwischen legendäre Fehlprognose:

»Ich denke, dass es weltweit einen Markt für vielleicht fünf Computer gibt.«

THOMAS WATSON, CHAIRMAN VON IBM, 1943

Immerhin füllten die frühen Computer noch ganze Räume. Und wie viele Privatnutzer brauchen schon eine komplizierte Chiffrierungsmaschine wie die Enigma, die im Zweiten Weltkrieg vom Militär eingesetzt wurde, um Nachrichten zu verschlüsseln?! Was Watson noch nicht wusste: Infolge des hohen staatlichen und bald auch wirtschaftlichen Interesses an Computern und in Anbetracht der offensichtlichen Vorzüge gegenüber menschlicher Arbeitskraft investierten sowohl Regierungen als auch Unternehmen wahnwitzige Summen in die Weiterentwicklung der Computertechnologie.

Immer leistungsfähiger, immer billiger

Rund zehn Jahre nach Watsons Fehlprognose prägte Gordon E. Moore, der spätere Gründer des IBM-Konkurrenten Intel, das nach ihm benannte Mooresche Gesetz: Er beobachtete eine regelmäßige Verdopplungsrate der Transistoren pro Computerchip bei gleichzeitiger Abnahme der Herstellungs- und Energiekosten. Anders ausgedrückt: Alle etwa zwei Jahre verdoppelt sich die Leistungsfähigkeit eines Computerchips, während der Preis sinkt. Bereits 1965 rechnete Gordon Moore vor, dass dieser Trend mindestens zehn Jahre anhalten würde – und er liegt bis heute richtig.

Die Wachstumsrate blieb bzw. bleibt also gleich, weshalb wir es mit exponentiellem Wachstum zu tun haben. Diese Art von Wachstum kennen wir aus der Biologie beispielsweise von der Zellteilung oder Viren, die sich immer wieder verdoppeln und dadurch sehr schnell entweder komplexe Organismen oder tödliche Pandemien hervorbringen können. Das haben wir in der Coronapandemie anschaulich erlebt.

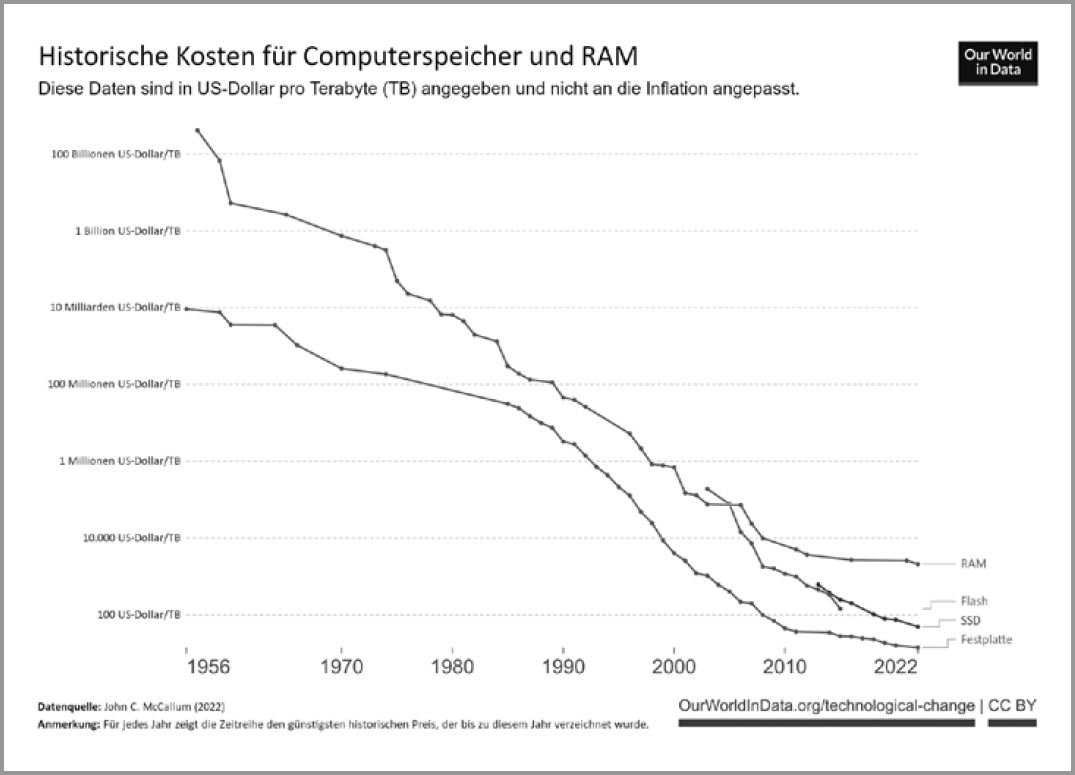

Dadurch, dass weltweit so viele Unternehmen an der Optimierung dieser Systeme arbeiten, sinken gleichzeitig mit der Zunahme der Rechengeschwindigkeit die Preise. Das kennen wir alle aus dem Privatbereich: Wer sich um die Jahrtausendwende eine vernünftige Festplatte für den Heim-PC angeschafft hat, musste dafür noch mehrere Hundert Euro investieren. Heute gibt’s ein Vielfaches der Speicherkapazität zu einem Bruchteil des Preises. Die folgende Abbildung zeigt den Verfall der Preise pro Terabyte (= 1000 Gigabyte) in US-Dollar für die vier Speicherarten, die üblicherweise in Computern verbaut werden. Falls ihr euch schon mal gewundert habt, wie es möglich ist, dass so viele Technikunternehmen zig Millionen Geräte im Jahr produzieren und trotzdem noch Gewinn dabei machen – die folgende Abbildung enthält die Antwort darauf.

Kaum zu glauben, aber wahr: Heute stecken Computerspeicher in vielen Geräten, die teilweise nur wenige Euro kosten. Vor wenigen Jahren und Jahrzehnten hätten diese Geräte einerseits ein Vermögen gekostet, andererseits brauchte die Mehrheit der Menschen auch noch kein Computersystem mit wahnsinnig viel Speicher, weil schlicht kaum Daten digital gespeichert werden mussten. Schauen wir uns das mal für Standard-Smartphones an: Diese werden heute oft mit 128 Gigabyte Speicher ausgeliefert – darin stecken sogenannte SSD-Speicher (SSD = Solid State Drive), die sehr viel schneller sind als herkömmliche Festplatten. Auch hier sind die Preise seit 2013 von 625 auf rund 50 US-Dollar pro Terabyte gefallen. Während also 2013 allein der Speicher eines heutigen Smartphones schon 80 US-Dollar gekostet hätte, sind es heute theoretisch nur noch 6,40 US-Dollar. Vielleicht erinnert ihr euch noch daran, wie ihr in den 1980er- oder 90er-Jahren Technik im Heimcomputer nachgerüstet habt; für einige Hundert Megabyte (!) musste man damals noch Hunderte D-Mark ausgeben. Heute gibt’s für den Preis ein Vielfaches an Kapazität, selbst Werbegeschenk-USB-Sticks haben viele Gigabyte oder sogar ein Terabyte. Und diese Entwicklung wird sich in Zukunft voraussichtlich weiter fortsetzen, da die Preise für Halbleiter weiter sinken und Wettbewerbs- und Skaleneffekte den Rest erledigen.

Keine Angst, noch technischer wird es an dieser Stelle nicht. Aber es ist wichtig, diese KI-Grundlage zu verinnerlichen. Denn ohne dieses Wissen könnte der Eindruck entstehen, KI wäre »plötzlich« aufgetaucht. So ist es aber nicht: Die Basis für heutige KI-Systeme wurde bereits in den 1940er-Jahren gelegt, die Entwicklung der Computersysteme hat sich schleichend über Jahrzehnte entwickelt, während erst eine globale Nachfrage für effiziente Computersysteme entstand. Für KI benötigt man neben Computerspeicher noch effiziente Grafikspeicher und Computerprozessoren, die Entwicklung an der Stelle zeigt in dieselbe Richtung.

CPU (Central Processing Unit)

Deutsch: Computerprozessor, heute in der Regel Mikroprozessor. Es handelt sich dabei um das technische Herzstück von Computern, Smartphones etc. Der Prozessor führt getaktete Berechnungen von binären Daten (0 und 1) aus. Sämtliche Eingaben von Peripheriegeräten wie Tastatur oder Maus sowie von laufender Software werden hier verarbeitet.

GPU (Graphics Processor Unit)

Deutsch: Grafikprozessor. GPUs zeichnen sich durch eine höhere Effizienz gegenüber CPUs aus, weshalb sie im KI-Bereich eine wichtige Rolle spielen.

Der Begriff »Künstliche Intelligenz« wiederum wurde schon 1956 auf der Dartmouth Conference geprägt und ist seitdem eine akademische Forschungs- und Entwicklungsrichtung. Der Reifegrad der praktischen Anwendungen allerdings wurde in den meisten Bereichen erst in den 2010er-Jahren erreicht – und das klappte nur, weil Konrad Zuse 70 Jahre zuvor einen programmierbaren Computer gebaut hat.

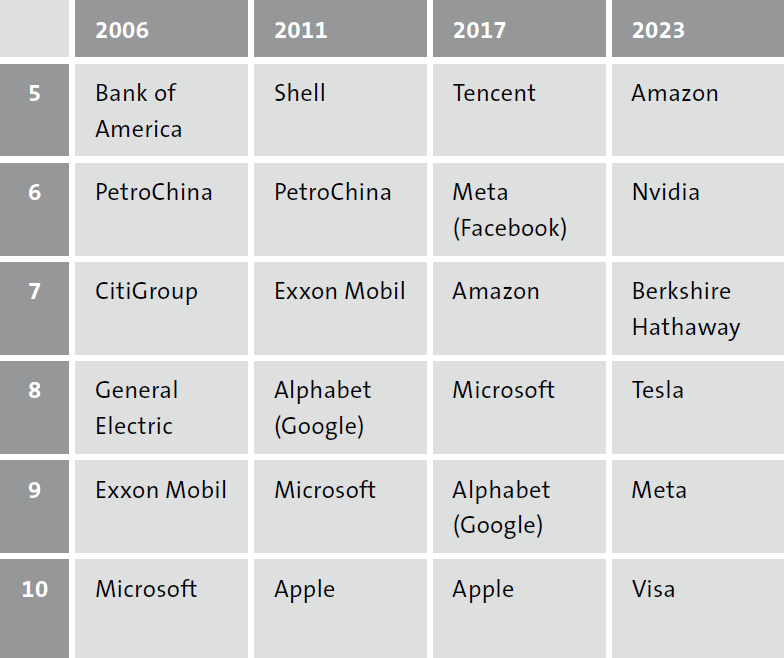

Wer die Nase vorn hat: Der Siegeszug von MANAMAT

Heute dominieren Unternehmen die Weltwirtschaft, die diese Entwicklung ernst genommen haben. Während im letzten Jahrhundert vor allem die Rohstoff- und Automobil-Unternehmen die Rangliste der wertvollsten Unternehmen anführten, sind es heute die IT- und KI-Pioniere sowie diejenigen, die sich mit Plattformen unerlässlich für das tägliche Leben von Milliarden Menschen gemacht haben.

MANAMAT, das sind die Kürzel der Tech-Riesen Meta (Mutterkonzern von Facebook, Instagram, WhatsApp und Oculus, gegründet 2004), Alphabet (Mutterkonzern von Google, gegründet 1998), Nvidia (Grafikkartenhersteller, wichtig für KI!, gegründet 1993), Amazon (gegründet 1994), Microsoft (gegründet 1975), Apple (gegründet 1976) und Tesla (gegründet 2003) – alle mit Hauptsitz in den USA. Dazu kommt TSMC (Halbleiter, gegründet 1987) aus Taiwan. Wir haben die Buchstaben so sortiert, dass man sie als Merksatz aussprechen kann. Sie stehen symbolisch für das entscheidende Element in der »neuen« Wirtschaft des 21. Jahrhunderts: für ein Geschäftsmodell, das auf den Vorzügen der digitalen Infrastruktur inklusive KI beruht.

In diesem Zusammenhang heißt es oft, Daten seien das neue Öl. Die folgende Tabelle zeigt die Rangliste der wertvollsten zehn Unternehmen nach Börsenwert jeweils Ende 2006, 2011, 2017 und 2023 und verdeutlicht, was damit gemeint ist:

Im Jahr 2006 wurden die Top Ten von einem Automobilunternehmen, einer Reihe Erdölunternehmen und ein paar Banken dominiert. 2023 schafften es noch ein Erdölunternehmen (Saudi Arabian Oil Company) und der Mischkonzern von Starinvestor Warren Buffett (Berkshire Hathaway) in die Liste und schließlich Visa als Zahlungsdienstleister, der massiv von der Pandemie profitiert hatte. Der Rest der wertvollsten zehn Unternehmen weltweit besteht aus Technologie-Unternehmen – Tesla ist ein Hybrid, denn es verkauft zwar Autos, der entscheidende Wettbewerbsvorteil basiert aber auf Software-Entwicklung in Verbindung mit ihren KI-Fähigkeiten und dem maßgeblich digital getriebenen Direktvertrieb. Die »old economy« wird langsam aber sicher hinsichtlich ihrer Marktkapitalisierung auf die Zuschauerränge verdrängt.

Mit anderen Worten: Viele der wertvollsten Unternehmen der Welt gab es entweder vor 25 Jahren noch gar nicht oder sie haben zumindest den Kern ihres Geschäftsmodells erst nach der Jahrhundertwende neu definiert: Daten sowie die digitale Infrastruktur mit Cloud, KI, Quantencomputer und Metaverse. Denn die sind inzwischen wertvoller als Öl, Gas und Autos.

QC (Quantencomputer)

Ein Quantencomputer nutzt andere Mechanismen als klassische Mikroprozessoren, um Informationen zu verarbeiten: quantenmechanische Eigenschaften. Anstatt nur binäre Daten (0 und 1) zu verarbeiten, wird mittels Quantenverschränkung, Superposition und mit QBits statt Bits eine größere Bandbreite darstellbarer Informationen ermöglicht. Quantencomputer sind technisch sehr aufwendig, weshalb die Verbreitung aktuell noch eher gering ist. Bisherige Geräte können allerdings schon jetzt Probleme in kurzer Zeit lösen, für die herkömmliche Computer mehrere Jahrhunderte bräuchten; umgekehrt eignen sie sich nicht für viele klassische Berechnungen. Die wichtigsten Anbieter auf dem Gebiet sind IBM, Honeywell, D-Wave, Google, QCI, Xanadu und Microsoft Azure Quantum.

Was bei diesen Listen immer wieder auffällt: Kein einziges der zehn größten Unternehmen kommt aus Europa. Nur drei deutsche Unternehmen schafften es 2023 in die Top 100: SAP, Siemens und die Telekom. Das bedeutet zwar nicht im Umkehrschluss, dass alle anderen Unternehmen wertlos geworden sind. Es bedeutet auch nicht, dass Großunternehmen der europäischen Industrie für immer aufs Abstellgleis befördert wurden. Aber es bedeutet, dass sie sich in die Lage versetzen müssen, mit den neuen Technologien umzugehen – einfach, weil die Nachfrageseite es erwartet und Aktionäre tendenziell dem Ruf der Innovation folgen. Ihr würdet doch auch keine Aktie von einem Unternehmen kaufen, das keinen Stromanschluss hat, oder?

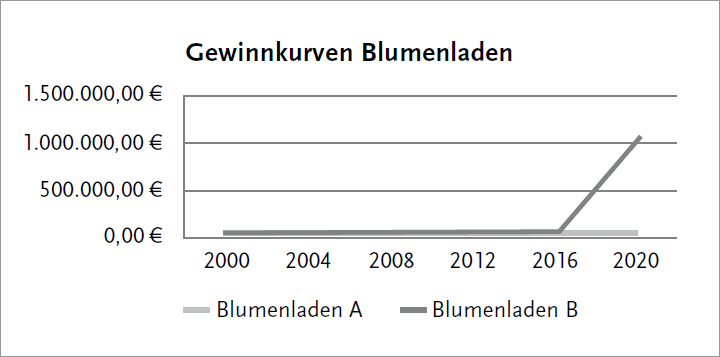

Wenn die Top Ten der wertvollsten Unternehmen in rund zehn Jahren ausgetauscht wurden, kann durch die KI-Skaleneffekte in einigen Bereichen dasselbe auch in heimischen Märkten passieren. Immerhin sind die meisten Unternehmen keine Global Player, sondern kleine und mittelständische Firmen (KMU). Sehen wir uns das mal anschaulich an einem fiktiven Praxisbeispiel an.

EXKURS

Praxisbeispiel: Die Auswirkungen der exponentiellen Entwicklung auf kleine und mittlere Unternehmen

Nehmen wir an, ihr habt im Jahr 2000 einen Blumenladen A eröffnet, nennen wir ihn mal »ALLE BLUMEN«. Ihr habt euer Geschäftsmodell linear geplant: Die Gewinne sollen jedes Jahr um 1000 Euro ansteigen.

Im ersten Jahr macht ihr nach den Anfangsausgaben, nach Steuern und Inflation wie geplant 1000 Euro Gewinn, im fünften Jahr schon 5000 Euro, dann wären es nach zwölf Jahren schon 12.000 Euro, und wenn alles gut läuft, erwirtschaftet ihr mit eurem Blumenladen im Jahr 2020 ganze 20.000 Euro Gewinn. Klingt nach einer tollen Leistung, oder?

Verglichen mit einem exponentiellen Ansatz verblasst diese Leistung leider recht schnell. Stellen wir uns einen benachbarten Blumenladen B vor, der im selben Jahr den Betrieb aufgenommen hat und sich »BESTE BLUMEN« nennt. Dieser hat sein Geschäftsmodell allerdings exponentiell geplant und möchte seine Gewinne jedes Jahr verdoppeln.

Er investiert frühzeitig in eine Website und einen Onlineshop und kümmert sich schon in den 2010er-Jahren um KI-Prozesse. »BESTE BLUMEN« startet deshalb zwar nur mit 1 Euro Gewinn im Jahr 2000, weil der Betrieb höhere Ausgaben hatte.

Im Jahr 2004 stehen nach Steuern und Inflationsausgleich gerade mal 16 Euro Gewinn unter dem Jahresergebnis und ihr reibt euch in eurem Blumenladen »ALLE BLUMEN« schon die Hände, weil ihr denkt, der Nachbar macht es wohl nicht mehr allzu lang. Immerhin muss er auch immense Darlehen tilgen. 2012 macht der Nachbar dann aber doch schon 4096 Euro Gewinn. Im Jahr 2020 sind es schließlich unglaubliche 1.048.576 Euro. Mehr als eine Million Euro Gewinn, wie kann das angehen?!

Der Teufel steckt im Detail: Jeder einzelne Schritt auf der exponentiellen Skala steht für eine Verdopplung des Gewinns von Blumenladen B (»BESTE BLUMEN«), während der Gewinn von Blumenladen A (»ALLE BLUMEN«) im selben Zeitraum stetig um denselben Betrag von 1000 Euro wächst. Zwar startet der innovativere Blumenladen B mit viel weniger Gewinn, doch durch die regelmäßige Verdopplung der Gewinne wächst sein Kontostand schlagartig an. Allein von 2019 auf 2020 verdoppelt sich sein Gewinn von 524.288 Euro auf 1.048.576 Euro. Exponentiell eben.

Diese fiktive Modellrechnung ist einer der Gründe dafür, warum die großen Technologieunternehmen aus dem Silicon Valley regelmäßig neue Produkte entwickeln und seit Jahren mit KI experimentieren. Anfang der 2000er-Jahre hatte kaum ein anderes Unternehmen KI auf dem Schirm, außer Investmentbanken und innovativen Wagniskapitalgebern. Und selbst andere Technologiefirmen dieser Zeit wie Nokia, die den weltweiten Markt für Mobiltelefone dominierten, oder Kodak, zur Jahrtausendwende unangefochtener Marktführer für Kameras, übersahen die frühen Entwicklungsschritte von Apple, Amazon, Samsung und Co. Und so wurden sie aus ihrem Marktsegment verdrängt, denn: Wer den Anschluss verliert und in einem Jahr denkt, der Wettbewerber oder Angreifer hätte sich vertan, könnte unter Umständen ein böses Erwachen erleben, wenn sich dessen Investitionen schlagartig doch auszahlen.

So erging es auch Googles Mutterkonzern Alphabet Ende 2022. Mit der Veröffentlichung von ChatGPT war klar: Google, das bis dahin weltweit als innovativstes KI-Unternehmen galt, hatte den Wettbewerber OpenAI – ein Start-up! – unterschätzt. Anfang 2023 verhängte Google deshalb offiziell den »Code Red«, Alarmstufe rot. Denn der Kern des Geschäftsmodells von Google (die Werbeanzeigen in Suchmaschinen und anderen Websites) war über Nacht hinfällig geworden. Plötzlich müssen Internet-User nicht mehr den Umweg über die Suchmaske gehen, sondern befragen einfach den Chatbot bei ChatGPT oder in der Konkurrenz-Suchmaschine Bing und erhalten eine Antwort, anstatt sich durch die Sucherergebnisse zu klicken. Zwar wird es noch eine Weile dauern, bis die Erlöswege von Google nicht mehr funktionieren, aber der Imageschaden für den ehemals Klassenbesten ist irreparabel. Das ist so, als würde herauskommen, dass der beste Schüler einer Schulklasse nur durch Abschreiben und Bestechungen von Sitznachbarn zu seinen Bestnoten kam. Was bleibt? Ein schlechter Ruf.

KI – nicht nur Thema für Software-Unternehmen

Wer bisher glaubte, dass diese Entwicklung nur Software-Unternehmen betrifft, irrt. Vielleicht ist nicht unbedingt jeder Blumenladen unmittelbar der Gefahr durch exponentielle Geschäftsmodelle ausgesetzt, sicher aber jedoch jedes Unternehmen aus dem Mittelstand in allen Bereichen: von IT bis Maschinenbau, von Versicherungen bis Baugewerbe, von Mobilität zum Handwerk und vom Handel bis ins privatwirtschaftliche Gesundheitswesen.

Das größte Kapital der Unternehmen ist jetzt nicht mehr ihr Kernprodukt wie ein Hochdruckreiniger, ein Kran, eine Orthese oder ein Scanner, sondern das Wissen darüber, wie diese Produkte und Dienstleistungen im Wesentlichen funktionieren. Mithilfe von KI-Systemen lassen sich sämtliche Produkte, Prozesse und Dienstleistungen grundsätzlich optimieren, unter Berücksichtigung geltender Normen und veröffentlichter Konstruktionsdaten, versteht sich. Und genau das wird der entscheidende Vorteil sein: Durch die optimierten Prozesse kann unser Blumenladen B »BESTE BLUMEN« nach etwas Durchhaltevermögen den beschaulichen Laden »ALLE BLUMEN« kaufen, wenn die Kundschaft nicht ohnehin schon wegen der innovativeren Marke gewechselt hat.

Ähnlich wie die Geschäftswelt ändern sich dadurch unmittelbar auch die Anforderungen an Beschäftigte. Nehmen wir die Automobilbranche: Sprach man früher noch vom »Kfz-Mechaniker«, wandelte sich das Berufsbild Anfang der 2000er-Jahre zum »Mechatroniker«. Die Fahrzeuge enthalten immer mehr Sensoren und elektrische Verbindungen, die verstanden werden müssen; das vernetzte Fahrzeug von heute enthält Hunderte Mikrochips und die Rolle der Software im Bordcomputer gewinnt an Stellenwert, während unter anderem Kenntnisse über Verbrennungsmotoren angesichts der Zunahme an Elektrofahrzeugen und anderen Antriebsformen an Bedeutung verlieren. Wichtiger werden die Kenntnisse im Umgang mit innovativen Diagnosegeräten, zu denen neben klassischen Computern oder Notebooks in absehbarer Zeit auch smarte Brillen mit gemischter Realität gehören werden. Weitere Jobs, die durch KI verändert werden, schauen wir uns im nächsten Kapitel an.

Die Entwicklung ist längst nicht vorbei. Denn der nächste große Meilenstein für die Informationstechnologie ist schon erkennbar: Quantencomputer. Sobald sich deren Betriebskosten und Effizienzsteigerung auf die Mooresche Kurve begeben, ähnlich wie die bei klassischen Computerchips, beginnt das nächste Wettrennen um die Mehrwertgenerierung durch noch schnellere Datenverarbeitung. Zwar wird diese Kurve erst in den 2030er-Jahren spürbar werden, innovative Unternehmen und Menschen sind jedoch gut beraten, schon jetzt die Auswirkungen auf das eigene Umfeld zu bedenken. Was das bedeuten kann, beschreiben wir im sechsten Kapitel.

Ausblick: KI in Europa

Das US-amerikanische Innovations-Epizentrum liegt unweit der kalifornischen Westküste und heißt Silicon Valley. Viele der großen Technologieunternehmen, die die Weltrangliste im Börsenwert dominieren, stammen von hier und ziehen Talente und Start-ups magisch an. Auch trotz schwächelnder Tendenzen und platzender Spekulationsblasen gilt das Valley nach wie vor international als Goldschmiede der IT-Szene. Unter dem Suchbegriff »Silicon Valley Reise« spucken moderne Suchmaschinen Hunderte Millionen Ergebnisse für maßgeschneiderte Innovations-Trips aus, denn wer es nicht mit eigenen Augen gesehen hat, kann in der Innovationsszene nicht mitreden. Heißt es.

Aber: Dortige Innovationssysteme inklusive der Finanzströme unterscheiden sich von europäischen Staaten in nahezu allen Dimensionen. Dies liegt nicht zuletzt an einer Mentalität, die in einer emsigen Gründungskultur und in dem Streben nach Erfüllung des »American Dream« resultiert. Diese Haltung zieht ein mächtiges Geflecht risikobereiter Investor:innen nach sich und erfasst nicht zuletzt auch die Eliteuniversitäten in der unmittelbaren Umgebung.

Diese Bedingungen sind in Europa grundsätzlich anders ausgeprägt. Herkömmliche Wirtschaft und Industrie spielen hier eine historisch gewachsene grundlegend andere Rolle, und auch die strengeren Arbeitnehmer- und Patentgesetze begrenzen hier den Handlungsspielraum der freien Wirtschaft. Politik und Verwaltung sind vorrangig darauf ausgerichtet, Stabilität zu erhalten und zu verwalten.

Kulturell wird auf dem »alten« Kontinent eher jemand anerkannt, der oder die ein stabiles, weniger aufregendes Unternehmen führt oder eine Beamtenlaufbahn eingeschlagen hat. So ist es auch nicht verwunderlich, dass mit dem europäischen »AI Act« erst die Regulation kommt, bevor die Entwicklung an Fahrt aufnimmt. Und das, obwohl viele der Grundlagen und auch einige der weltweit führenden Unternehmen aus dem europäischen Raum stammen und mehr als ein Viertel der weltweit produzierten Haushalts- und Industrieroboter in Europa produziert werden.9 Natürlich setzen zahlreiche Unternehmen und auch die Administration inzwischen KI ein, doch die überwältigende Mehrheit tut dies noch nicht. Einige, weil sie abwarten, einige, weil sie KI noch nicht für ausreichend entwickelt halten. Das mag bisher auch gestimmt haben. Doch das ist jetzt vorbei. In Zeiten, in denen die erfolgreichsten Unternehmen der Welt ihre Strategien auf »AI first« (KI zuerst) umstellen, gerät der Rest der Wirtschaft in Zugzwang.

Somit stellen wir fest: Obwohl wir das Silicon Valley weder als erstrebenswertes Vorbild noch als unbedingte Reiseempfehlung ansehen, treiben die Entwicklungen von Google, Apple und Co. die europäische Wirtschaft voran. Spannend wird zudem die Entwicklung in China, wo inzwischen ernstzunehmende Konkurrenz für das Silicon Valley entstanden ist und auch im aktuellen Fünfjahresplan, der bis 2025 strenge Auflagen für die Wirtschaft setzt, Künstliche Intelligenz eine zentrale Rolle spielt. Durch die zunehmende Konfliktlage zwischen China und Taiwan, wo mit dem Unternehmen TSMC der größte Chiphersteller der Welt beheimatet ist, entstehen aktuell sowohl in Europa als auch den USA eigene Fabriken für die technologische Unabhängigkeit.

Man kann vom Silicon Valley oder dem chinesischen Pendant Shenzhen halten, was man möchte, das Potenzial der aktuellen und absehbaren Entwicklungen lässt nur einen Schluss zu: Das KI-Thema ist für alle Unternehmen interessant, vom Kleinbetrieb zum enorm wichtigen Mittelstand in Mitteleuropa sowie für Konzerne in sämtlichen Bereichen und Branchen.

Daher geht es auf dem Weg zu einer KI-Wirtschaft letztlich auch um Selbstschutz. Denn während es in den vorherigen industriellen Revolutionen neben Pionieren und Optimierern noch die späte Mehrheit gab, die von den später günstigeren Bedingungen und Preisen profitiert hat, könnte das mit KI anders verlaufen. Dadurch, dass KI als Querschnittstechnologie – wie Elektrizität – verstanden werden muss, könnte es teuer werden, auf die späte Mitläuferschaft zu warten. Es geht nicht darum, KI als Produkt zu begreifen, sondern Prozesse jetzt auf KI umzustellen und KI in die Entscheidungsfindung bzw. Automatisierung einzubinden. Daher kommt auch der Titel dieses Buches – KI ist ein technologisches Hilfsmittel, um euren Arbeitsalltag zu vereinfachen. Aus der Vogelperspektive betrachtet wird KI die Entwicklung von Lösungen und die Transformation ganzer Industriezweige beschleunigen.

Mit diesem ersten Kapitel haben wir den Grundstein für euer KI-Wissen gelegt. Ihr seid nun gut gerüstet, um tiefer ins Thema einzutauchen. Im zweiten Kapitel gehen wir darauf ein, für wen genau dieser Weg wichtig ist und welche Berufe heute oder in naher Zukunft von KI verändert werden. Daher folgen nun KI-Beispiele in den häufigsten Berufsgruppen.

Auf einen Blick

Dies ist eine Zusammenfassung des Kapitels, die ihr gern fotografieren und mit anderen teilen oder sie ausgedruckt ins Büro hängen könnt.

Die 10 Kernaussagen des Kapitels

- 1. ChatGPT hat die Welt verändert: Spätestens seit November 2022 ist Künstliche Intelligenz (KI) nicht mehr aus dem Alltag der Menschheit wegzudenken. ChatGPT ist aber nur eines von vielen nennenswerten KI-Tools, es gibt auch deutsche Anbieter wie Aleph Alpha, ein nennenswerter Teil der KI-Grundlagenforschung geschieht zudem in Deutschland und Europa.

- 2. Neben industriellen Anwendungen ist KI inzwischen besser als Menschen darin, Texte, Grafiken, Musik oder Videos zu erzeugen. Dahinter steckt generative KI, sehr viele Trainingsdaten und sehr viel Rechenleistung. Außerdem stecken darin riesige Profite. Nicht zufällig sind viele der wertvollsten Unternehmen der Welt diejenigen, die die Nase in der KI-Entwicklung vorn haben.

- 3. Täglich erscheinen Hunderte neue KI-Tools, die zwar nicht intelligent sind, aber oft produktive Arbeitsschritte ausführen können, die zuvor nur Menschen erledigen konnten. Dabei sind nicht die Lösungen mitgezählt, die nur innerhalb von Organisationen für eigene Zwecke entwickelt wurden. Die beiden besten Plattformen für KI-Tools sind www.futurepedia.io und www.theresanaiforthat.com.

- 4. Für Unternehmen heißt das: Der Handlungsdruck ist in der Wirtschaft angekommen. So, wie elektrischer Strom vor rund 120 Jahren erst langsam die Welt erobert hat, wird KI die kommenden Jahre prägen – und bald werden wir uns kaum mehr vorstellen können, wie Aufgaben oder Prozesse überhaupt ohne KI funktionieren konnten.

- 5. Unsere KI-Definitionen:

- – KI-Anwendungen sind technische Einrichtungen, die computergestützt Daten verarbeiten und autonom Entscheidungen treffen.

- – Variante für Laien: KI ist, wenn eine Maschine Probleme lösen kann, die bisher nur Menschen lösen konnten.

- – Wenn wir von Künstlicher Intelligenz sprechen, meinen wir also in der Regel lernende Computersysteme. Diese funktionieren mithilfe von Algorithmen, also programmierten Rechenvorgängen, die ein bestimmtes Ziel erreichen sollen. Daher ist vor allem das Konzept des maschinellen Lernens wichtig.

- 6. Vieles, was wie KI aussieht, zum Beispiel Saugroboter, enthält normalerweise keine KI. KI ist, wenn nicht nur vorgegebene Regeln abgearbeitet werden, sondern wenn eine Maschine durch Analyse neuer Umgebungsdaten eigene Entscheidungen trifft. So wie bei ChatGPT oder den Anwendungsfällen im 5. Kapitel.

- 7. Exponentielles Wachstum ist, wenn sich über längere Zeit die Menge oder Qualität eines Objekts mit gleichbleibendem »Tempo« verändert. Bei Computern sind das unter anderem der Speicher, die Rechengeschwindigkeit und der Preis – und das seit Jahrzehnten. Das ist eine wichtige Grundlage für Künstliche Intelligenz, denn sie benötigt viel Computer-Hardware.

- 8. Exponentielles Wachstum ist für uns Menschen schwer vorstellbar, weshalb viele Unternehmen aktuell gefährdet sind, die KI-Entwicklung zu übersehen. Wenn dann aber Wettbewerber schneller in der KI-Entwicklung sind, verlieren sie den Anschluss und können den Vorsprung nicht mehr einholen. Das gilt für direkte Wettbewerber genauso wie für Regionen, weshalb der globale KI-Wettlauf vergleichbar mit dem Weltraum-Wettrennen der 1950er- und 60er-Jahre ist.

- 9. KI ist nicht »intelligent«, wie wir Menschen es sind, der Begriff ist im Grunde irreführend. Dennoch gibt es einige Risiken zu beachten – auch für Privatleute, Jugendliche, Pensionierte und Erwerbstätige. KI wird längst dazu genutzt, um kriminelle Machenschaften zu skalieren oder Menschen zu überwachen. Außerdem verbraucht KI wahnsinnig viel Energie.

- 10. Innovation und Technologieentwicklung spielt sich überall auf der Welt unterschiedlich ab. In diesem Buch legen wir Wert auf eine europäische, eher auf den Mittelstand konzentrierte Betrachtung. Darin steckt auch die Botschaft: KI ist zu komplex für einen einfachen Bestellprozess, es gibt zahlreiche KI-Anwendungen, die passen könnten – unerlässlich ist und bleibt jedoch ein Grundverständnis der Technologien und Mechanismen.