5. Angewandte KI

Digitalisierung war gestern, die Zukunft gehört der KI. In diesem Kapitel geht’s an die Substanz: Wir haben die wichtigsten und naheliegendsten Anwendungsfälle für euch zusammengestellt und erläutern die wichtigsten Merkmale. Dabei vermeiden wir die allseits bekannten Use Cases wie die Krebserkennung von IBM Watson oder die Proteinfaltung von AlphaFold. Stattdessen widmen wir uns den klassischen Unternehmensprozessen und -funktionen und klären, wo durch KI ein Mehrwert entsteht, was der Spaß in etwa kostet, ob die Technologie aktuell schon reif dafür ist oder man doch lieber noch abwarten sollte.

Warnhinweis: Bitte stellt sicher, dass alle, die diese Anwendungsfälle lesen, erst das letzte Unterkapitel im zweiten Kapitel gelesen haben (»Vermeidbare Stolpersteine«). Für Kopierfehler übernehmen wir keine Haftung!

In diesem Kapitel geht’s ans Eingemachte, es ist das Herzstück dieses Buches. Wir skizzieren 22 Beispiele, die in der Realität existieren, einige davon haben sich bereits als Standard in manchen Branchen etabliert, einige sind noch echte Unikate – zumindest in exakt dem Setup, wie wir es uns angeschaut haben. Das ist auch der Grund, warum wir keine Unternehmensnamen der Beispiele nennen: Schlicht, weil wir Verschwiegenheit in einigen Fällen zugesagt haben und in anderen die Eingabe der Eckdaten in eine Suchmaschine eurer Wahl hilfreich sein wird. Die Brisanz dieses Kapitels ist der Grund dafür, warum wir bis hierher so viel Platz und Energie darauf verwendet haben, die KI-Grundlagen zu vermitteln. Denn ohne ein Grundverständnis der Mechanik von KI, ihren wichtigen Fallstricken und Stolpersteinen, wird die Anpassung auf den eigenen Prozess wahrscheinlich scheitern.

Für die Ungeduldigen: Am Ende des Kapitels findet ihr eine Tabelle mit allen Use Cases, sortiert nach Unternehmensbereichen (s. u.).

Einige Vorbemerkungen und Hinweise

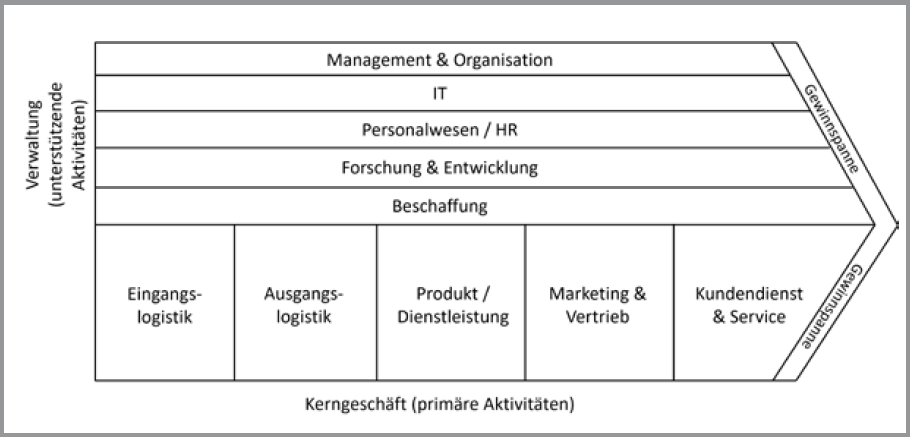

Es gibt mehrere Möglichkeiten, Anwendungsfälle zu präsentieren: sortiert nach Branche, Alphabet, Innovationsgrad oder Handlungsdruck. Wir haben uns für Geschäftsprozesse bzw. Unternehmensbereiche nach Michael Porter entschieden, da sich dieses Modell seit seiner Vorstellung in Porters Bestseller »Competitive Advantage: Creating and Sustaining Superior Performance« von 1985 weltweit verbreitete. Wir haben einige Begriffe leicht angepasst und IT ergänzt. Wir nehmen an, dass es mit minimalen Abweichungen auch heute noch in 90 Prozent der mittelständischen und großen Unternehmen fast aller Branchen so gilt:

Da wir also davon ausgehen, dass der Großteil der mittelständischen und großen Unternehmen im Wesentlichen nach diesem Schema aufgebaut ist, werden viele von euch, die dieses Buch lesen, in solchen Unternehmen beschäftigt sein. Wir möchten euch also die KI-Anwendungsfälle entlang der typischen Unternehmensbereiche und Geschäftsprozesse vorstellen. Viele Use Cases können auch in öffentlichen Einrichtungen funktionieren, vielleicht genügt dann aber der Blick in den zweiten Bereich »Verwaltung und Management (unterstützende Aktivitäten)«. Denn das hat nun wirklich jede Organisation.

Wegen der Wirtschaftsstruktur in Deutschland, wo dieses Buch erscheint, haben wir vermehrt Use Cases aus Industrieunternehmen in die finale Auswahl übernommen. Die wichtigste Erkenntnis über alle Anwendungsfälle ist, dass viele Prozesse, von denen man bis vor Kurzem vielleicht noch dachte, sie seien in absehbarer Zeit nicht von Maschinen ausführbar, nun doch von Maschinen ausführbar sind. Allerdings haben wir auch einige Beispiele aufgeführt, die sich als erstaunlich schwer umsetzbar erweisen oder in ihrer Wirtschaftlichkeit (noch) eher unattraktiv sind.

Neben der strategischen Bedeutung dieser 22 Anwendungsfälle erkennen Beschäftigte und Angestellte darin, welche Tätigkeiten in den kommenden Jahren mit hoher Wahrscheinlichkeit an eine KI übertragen werden. Darauf gehen wir nicht im Detail ein, denn der Fokus liegt klar auf den Anwendungsfällen – Arbeiten und Bücher über Automatisierungspotenzial von Jobs gibt es schon genug.

Damit die Darstellung der Anwendungsfälle möglichst einheitlich und vergleichbar wird, haben wir ein Raster entwickelt, welche Kriterien wir bei allen Anwendungsfällen in Kürze erläutern:

Raster für die Use Cases

- ■ Ziel & Mehrwert

- ■ KI-Anwendungsfall

- ■ Beispiel

- ■ Reifegrad

- ■ Wirtschaftlichkeit

- ■ Handlungsdruck

- ■ Risiken

Aus Gründen der Übersichtlichkeit haben wir uns auf die 22 interessantesten und mutmaßlich anschlussfähigsten Fälle beschränkt – im besten Fall wird hier jede:r mehrfach fündig. Diese Anwendungsfälle sollten ausreichen, um die nächste Strategiesitzung zu sprengen. Bei einigen Rubriken handelt es sich um rein qualitative Einschätzungen aus unserer Erfahrung, bei anderen haben wir in einem aufwendigen Verfahren numerische Werte verteilt, um eine sinnvolle Abstufung beispielsweise der Reifegrade oder Wirtschaftlichkeit zu erreichen:

- ■ 0 unrealistisch / unethisch,

- ■ 1 – 3 gering,

- ■ 4 – 6 mittel,

- ■ 7 – 9 hoch,

- ■ 10 extrem / gesichert.

Einer der zwei großen Bereiche von Aktivitäten, die wir uns anschauen werden, ist das Kerngeschäft – also die primären Aktivitäten in jeder Organisation. Wir konzentrieren uns bei den Anwendungsfällen auf Unternehmen, aber das heißt nicht, dass nicht einige auch für öffentliche Einrichtungen, Kommunen oder Ämter funktionieren können.

Die fünf Unternehmensbereiche im Kerngeschäft, auf die zwölf der 22 Use Cases aufgeteilt sind, sind:

- ■ Eingangslogistik

- ■ Ausgangslogistik

- ■ Produkt / Dienstleistung

- ■ Marketing & Vertrieb

- ■ Kundendienst & Service

Der zweite große Bereich betrifft Verwaltung und Management. Sie dienen der Aufrechterhaltung des operativen Geschäfts sowie dem Management des Personals und der Technik. Auch hier konzentrieren wir uns bei den Anwendungsfällen auf Unternehmen, aber das heißt nicht, dass nicht einige auch für öffentliche Einrichtungen, Kommunen oder Ämter funktionieren können. Auf die folgenden Sparten entfallen zehn Use Cases:

- ■ Management & Organisation

- ■ IT

- ■ Personalwesen / HR

- ■ Forschung & Entwicklung

- ■ Beschaffung

Wenn eure Organisation einige Unternehmensbereiche nicht hat, springt gern zum jeweiligen Unterkapitel, das für euch passt.

Nützliche Begleitfragen

Schließlich möchten wir euch ein paar Fragen an die Hand geben, die euch während und nach der Lektüre helfen könnten:

- ■ Welcher Anwendungsfall lässt sich daraus für uns ableiten? Wie sehen unsere Prozesse analog zu den Use Cases aus dem Buch »KI jetzt!« aus?

- ■ Lässt sich aus dem Anwendungsfall ein Einfluss auf unser Kerngeschäft oder Geschäftsmodell ableiten?

- ■ Wollen wir Pionier oder Optimierer / Follower sein?

- ■ Setzt die direkte oder indirekte Konkurrenz in diesem Fall schon KI ein?

- ■ Passt dieser KI-Anwendungsfall zu unserer Organisationskultur (heute oder in Zukunft)?

- ■ Gibt es zugängliche Informationen über den Anwendungsfall X in meinem Umfeld?

- ■ Gibt es Start-ups, die Anwendungsfall Y automatisieren? Wenn ja: Was tun wir mit dieser Information?

- ■ Ist Anwendungsfall Z in unserem Fall zwar voraussichtlich extrem rentabel, aber aktuell nicht umsetzbar (make, buy, partner)?

- ■ Liegen die Kosten über dem Wertbeitrag und wenn ja, sollten wir trotzdem KI implementieren, um mittelfristig nicht abgehängt zu werden?

- ■ Haben wir die Ressourcen, eine noch nicht reife Technologie selbst zur Blüte zu entwickeln? Brauchen wir dafür Partnerschaften, Wagniskapital, öffentliche Förderungen und Zuschüsse oder ein Darlehen?

Die 22 naheliegendsten KI-Anwendungsfälle

Kerngeschäft Eingangslogistik

Bei der Eingangslogistik geht es um die Prozesse, die unmittelbar damit zusammenhängen, welche Rohstoffe verarbeitet werden und wie diese beispielsweise von Lieferanten angeliefert werden. Für dieses Buch haben wir uns für zwei industrielle Anwendungsfälle entschieden, ansonsten ist dieser Bereich natürlich auch übertragbar auf Dienstleistungsunternehmen, die weniger mit Rohstoffen als mit Informationen handeln.

#1 Disposition

Ziel & Mehrwert

Reduzierung der ungenutzten Kapazitäten

KI-Anwendungsfall

Optimierung und Vorhersage

Beispiel

Ein Unternehmen hat ein Warenlager, in dem 100 Lkw täglich Waren anliefern und abholen. Das Lager kann aber nur 15 Lkw pro Stunde gleichzeitig abfertigen. Um die Standzeit der Lkw zu optimieren, muss die Tageszeit möglichst effizient genutzt werden. Typischerweise müssen sich die Spediteure per Internet einen Zeitraum »buchen«, wann sie wo ankommen und abgefertigt werden. KI kann u. a. mittels IoT-Daten flexibler Entscheidungen über die Logistikkette treffen. Weit verbreitet beispielsweise in der Automobilindustrie sind »just in time«- und »just in sequence«-Anlieferungsmodelle. Hier könnte die KI die Daten der Anlieferungs-Lkw »überwachen« und autonom Entscheidungen treffen, inwiefern Änderungen bei Produktionsaufträgen getätigt werden können oder müssen. Letztendlich übernimmt hier die KI die Verantwortung, um (weitreichende) ProduktionsplanÄnderungen zu tätigen. Der übernächste Entwicklungsschritt ist AIoT (Artificial Intelligence of Things), in dem die verschiedenen KI-Systeme von Produktion, Disposition und Logistik autonom untereinander Entscheidungen treffen, etwa zum benötigten Liefervolumen, idealem Zeitpunkt der Abholung etc.

AIoT (Artificial Intelligence of Things)

Deutsch: Künstliche Intelligenz der Dinge. Immer mehr technische Geräte haben nicht nur Internetzugang (s. IoT), sondern enthalten Hardware- oder Softwarekapazitäten für KI-Anwendungen. Dadurch lassen sich immer mehr Mehrwertgenerierungen zwischen virtuellen und physischen Systemen erzeugen.

Reifegrad

Schwer zu bewerten, erste Ideen gibt es mutmaßlich bereits in Wolfsburg, Ingolstadt oder Sindelfingen. Auch für kleine, überschaubare Anwendungsfälle gibt es einfache Lösungen, aber für Industrie-Anwendungsfälle gibt es hier noch sehr viel Potenzial. Insbesondere Datenverfügbarkeit und Datenqualität sind große Baustellen, die geklärt werden müssten. Zumal es hier über mehrere Unternehmensgrenzen hinweg geht, bei denen Standards eingehalten werden und teilweise erst noch geschaffen werden.

Wirtschaftlichkeit

Hohe Investitionen, insbesondere in die IoT-Dateninfrastruktur sowie in die KI-Modellentwicklung, hoher Implementierungsaufwand, geringe Verfügbarkeit von Standard-Software.

Handlungsdruck

Hoch, insbesondere im Nachhaltigkeitsumfeld (Stichwort Lieferkettengesetz!), um vorhandene Ressourcen effizienter zu nutzen. Auch die Lieferfähigkeit war in den letzten Jahren sehr schwer einzuschätzen: Genau hier kann die KI bei Vorhersagen unterstützen. Herausforderung ist die Datenverfügbarkeit. Darüber hinaus ist in vielen Bereichen der Lkw-Bedarf weiterhin groß und kann nur sehr schwer gedeckt werden.

Risiken

Lange Amortisierungszeit, potenziell schwierige Datenverfügbarkeit. Es braucht Mut, Entscheidungshoheit an KI abzugeben (Stichwort Unternehmenskultur!).

#2 Wareneingangskontrolle

Ziel & Mehrwert

Kontrolle der Produktqualität

KI-Anwendungsfall

Sensorgestützte Überprüfung, u. a. Sensor Fusion und Computer Vision

Beispiel

Ein fiktiver Automobilhersteller erhält eine Lieferung von 100 Pkw-Cockpits. Jedes einzelne Cockpit wird per Videokamera und Computer Vision automatisch auf Mängel überprüft, bevor es ins Auto eingebaut wird. Die größere Herausforderung bei diesem Anwendungsfall ist nicht die Technologie oder die Entwicklung, sondern die, genug Bilder zu haben, die Qualitätsmängel enthalten. Denn der klassische Trainingsprozess setzt voraus, dass sehr viele Produkte mit Fehlern fotografiert werden, um der KI beizubringen, welcher Zustand zu vermeiden ist. Da wir (noch) sehr gute Qualität prozieren, sind die Fehler tatsächlich äußerst selten und es kann sehr lange dauern, bis man genügend Fehler-Bilder zusammen hat, um die KI zu trainieren. Dieses Problem gehört jedoch langsam der Vergangenheit an, denn mithilfe synthetischer Daten, also durch Bilder, geniert von einer KI, lässt sich die Qualitäts-KI trainieren. Konsequenz ist, dass diese Anwendungsfälle der Qualitätskontrolle deutlich einfacher umsetzbar sein werden und deutlich früher zum Einsatz kommen.

Reifegrad

Unabhängig von der Nutzung von synthetischen Daten jetzt schon relativ hoch, wobei wir hier gerade erst am Anfang des Möglichen sind.

Wirtschaftlichkeit

Sei es die Prozessfertigung oder auch die diskrete Fertigung, Qualitätskontrolle muss automatisiert werden, um teure Ausbesserungen oder sogar Ausschuss (Abfall) zu eliminieren. Jeder hier investierte Euro rechtfertigt die KI-Qualitätskontrolle.

Handlungsdruck

Hoch, insbesondere angesichts Fachkräftemangel und Repetitivität

Risiken

Trainingsdaten über fehlerhafte Produkte sind rar. Erfahrungen haben gezeigt, dass die Entwicklung der KI relativ einfach umzusetzen ist. Jedoch benötigen die Software und Infrastruktur deutlich mehr Zeit und Aufwand als gedacht (bzw. geplant).

Kerngeschäft Ausgangslogistik

In diesem Bereich geht es darum, die hergestellten Produkte zur Kundschaft zu liefern. An dieser Stelle fokussieren wir auf das produzierende Gewerbe, aber auch für Dienstleistungsunternehmen lohnt sich ein Blick darauf, wie ihre »Produkte« den Weg zu ihrer Kundschaft finden. Sie müssen dann vielleicht weniger Waren- oder Hochregallager optimieren, dafür umso mehr die Kommunikation.

#3 Auslieferungsoptimierung

Ziel & Mehrwert

Reduzierung unnötiger Zeiten und Wege bei der Auslieferung

KI-Anwendungsfall

Optimierung

Beispiel

Das sogenannte »Travelling Sales Man«-Problem gilt noch immer als ungelöst. Es basiert darauf, dass eine Liste von Wegepunkten möglichst effizient abgefahren werden muss, ob von einem Paketdienst oder einem Versicherungsvertreter. Sowohl die Beladung der Fahrzeuge (bzw. Vorbereitung des Vertreters) sowie die Optimierung der Route unter Echtzeit-Aktualisierung angesichts der aktuellen Verkehrs- oder Wettersituation kann mit KI gelöst werden.

Reifegrad

Geringer Umsetzungsgrad, da sehr rechenintensiv und individuell. Letztendlich wird dieses Problem erst lösbar sein mit Quantencomputing / Quantum Machine Learning, da hier aufgrund der Parallelisierung deutlich mehr Optionen in einer sehr kurzen Zeit gerechnet werden können.

QML (Quantum Machine Learning)

Deutsch: Maschinelles Lernen auf Quantencomputern. Schon jetzt gibt es erste Ansätze, auf den noch jungen Quantencomputern KI-Algorithmen anzuwenden. IBM bietet hier einen kostenlosen QML-Kurs an: https://learning.quantum.ibm.com.

Wirtschaftlichkeit

Schaut man sich an, was heute ein Quantencomputer kostet, ist hier definitiv die Wirtschaftlichkeit nicht gegeben. Nichtsdestotrotz gibt es schon mathematische Modelle, die hier unterstützen und gute Optimierungen ermöglichen.

Handlungsdruck

Daher bitte nicht erst auf die Zukunft warten, sondern jetzt schon in KI-Modelle investieren, um erste Optimierungen durchzuführen. Auch aus dem Grunde, dass hier jeder nicht gefahrene Kilometer Geld spart und auch der Umwelt zugutekommt.

Risiken

Großes Thema ist hier definitiv der Fachkräftemangel, entsprechende Engineers zu finden, die diese mathematischen und KI-Modelle bauen, oder verlässliche Partner zu haben, die individuelle Lösungen wirtschaftlich erstellen.

#4 Hochregallageroptimierung

Ziel & Mehrwert

Auslastung bzw. Belegung erhöhen

KI-Anwendungsfall

Optimierung

Beispiel

Lagerhallen benötigen sehr viel Platz und müssen aufgrund der hohen Investitionen optimal genutzt werden. Ein- und Auslagerungsstrategien sind, wenn überhaupt, regelbasiert und damit sehr starr. Viele Hochregallager sind so fragmentiert befüllt, dass sie nur zu maximal 80 Prozent belegt sind und dennoch keine weitere Palette mehr eingelagert werden kann. KI kann die Ein- und Auslagerungsstrategie dynamisch und in Echtzeit optimieren und zusätzlich durch Vorhersagen die Auslastung optimieren.

Reifegrad

Technologisch möglich, aber die Umsetzung bzw. Verprobung ist sehr herausfordernd.

Wirtschaftlichkeit

Abhängig von der Größe grundsätzlich rentabel (Skaleneffekt)

Handlungsdruck

Eher hoch angesichts der Zinssituation und steigender Nachhaltigkeitsanforderungen.

Risiken

Veränderungen sollten vorab in Simulationen getestet werden, da Stillstände vermieden werden müssen. Mutmaßlich ist die Akzeptanz einer vollständigen KI-Steuerung eher gering, weshalb frühzeitig in transparente Kommunikation über die Einführung investiert werden sollte.

Kerngeschäft Produkt / Dienstleistung

Dieser Bereich ist das Kernstück jedes Unternehmens; in der Regel handelt es sich natürlich um mehre Produkte oder Dienstleistungen. Auch hier bewegen wir uns eher im industriellen Umfeld, betreten aber auch größere Schnittmengen zu Dienstleistungsunternehmen.

#5 Vorausschauende Wartung (Predictive Maintenance)

Ziel & Mehrwert

Ausfallzeiten minimieren und »planen«

KI-Anwendungsfall

Vorhersage

Beispiel

Komplexe Maschinen bzw. technische Einrichtungen sind störanfällig bzw. haben Verschleißteile. In der Industrie sind es die Motoren, die es typischerweise in einer Produktion zu Hunderten gibt, so etwa die Motoren der Förderbänder oder Motoren in einer Maschine selbst, die wiederum Maschinen bewegt, von kleinen Bohnen über Autos. So zum Beispiel auch in vielen neueren Geräten wie Windkraftanlagen. Dort wird Sensorik verbaut, die unter anderem Vibration, Schwingungen oder Temperatur misst. Basierend auf dieser Sensorik lässt sich eine Anomalie-Vorhersage erstellen. Herausfordernd ist die Festlegung des Normalzustands und ab welcher Anomalie die »rote Zone« erreicht und ein Defekt unausweichlich wird – sowie die Definition der »gelben Zone«, in welcher bestenfalls die schadhaften Teile identifiziert und ausgewechselt werden, ohne unnötige Kapazitäten zu verschwenden. Grundlage dafür sind qualitativ hochwertige Daten und digitalisierte Wartungsberichte. Inzwischen sind auch Start-ups in dem Bereich tätig, die nachrüstbare Sensorikboxen vertreiben.

Dabei ist die Anomalie-Erkennung eigentlich nur der erste Schritt, nämlich die Erkennung, dass etwas nicht »rund« läuft. Der zweite Schritt wäre nun die genaue Vorhersage, was kaputtgehen wird. Voraussetzung dafür sind nicht nur die Daten der Sensorik, sondern die Fähigkeit, diese Daten mit den Instandhaltungsdaten abzugleichen, um dann genau zu ermitteln, welches Teil ausgetauscht werden muss.

Genau diese Datenqualität ist in vielen Unternehmen jedoch nicht vorhanden oder liegt in einem System, aus dem diese Daten nur schwer zu extrahieren sind. Der finale Schritt wäre, dass die KI die Anomalie erkennt, dann entscheidet, was für eine Störung vorliegen wird, anschließend den Instandhaltungsauftrag erstellt und im Lager prüft, ob die notwendigen Teile vorhanden sind und, wenn nicht, diese auch bestellt. Letztendlich wird sie den »Linienstillstand« ebenfalls planen und auch die notwendigen Fachkräfte einteilen.

Reifegrad

Weniger verbreitet als möglich – fehlende Datengrundlage ist meist der limitierende Faktor. Mithilfe generativer KI könnten durch die synthetische Datenerzeugung Versäumnisse aufgeholt werden. Zusätzlich müssen die Instandhaltungsdaten vielerorts auch noch digitalisiert werden. Grundsätzlich ist dieser Anwendungsfall aber komplett umsetzbar.

Wirtschaftlichkeit

Besonders wenn der komplette Prozess nicht nur digitalisiert, sondern durch die KI auch noch voll automatisiert wird, ist die Wirtschaftlichkeit extrem hoch.

Handlungsdruck

Eher hoch, abhängig vom Leidensdruck

Risiken

Datenverfügbarkeit und Datenqualität; beide haben große Auswirkungen auf die Qualität der KI. Aktuell würde dieser Anwendungsfall hinweg über mehrere IT-Systeme automatisiert werden müssen. Das birgt enormes Potenzial für Chaos und insbesondere Datenqualitätsprobleme.

#6 KI-basierte Maschinensteuerung

Ziel & Mehrwert

Maschinensteuerung automatisieren

KI-Anwendungsfall

Sensor Fusion, Optimierung, Vorhersage

Beispiel

Der »heilige Gral« in einem Produktionsunternehmen. Die KI übernimmt die vollständige Steuerung einer Maschine oder sogar einer Fertigungslinie. Sei es in der Prozessfertigung, der Anlagensteuerung oder in der diskreten Fertigung; das Ziel ist die Steuerung über mehrere Arbeitsschritte bzw. Roboter hinweg. Die Entwicklung dieses Anwendungsfalls ist eine der komplexesten, aber auch eine (wenn sie funktioniert) mit dem höchsten Mehrwert. Hier spielen mehrere Aspekte eine Rolle, vom Fertigungsauftrag über Anlagenparameter über Sensorik hin zu Rohstoffqualitäten.

Als Beispiel könnte man sich die Prozessindustrie vorstellen, wo die Herstellung eines bestimmten Rohstoffes über zehn Stunden dauern kann. Der Prozess ist höchst volatil und hat eine zweistellige Anzahl an Parametern wie Temperatur, Fließgeschwindigkeit oder Druck. Dieser Prozess könnte komplett von einer KI gesteuert und automatisiert werden.

Reifegrad

Technisch machbar, bedarf jedoch hoher Investitionen. Erste Prototypen existieren bereits, sind aber noch nicht vom Anlagenfahrer oder Führungskräften akzeptiert bzw. das Vertrauen ist (noch) nicht vorhanden.

Wirtschaftlichkeit

Sehr hohe Investitionen, daher eigentlich nur vom Anlagenhersteller umsetzbar, damit er die Synergien hinweg über mehrere Anlagen verteilen kann. Möglicherweise sinnvoll als Partnerprojekt.

Handlungsdruck

Automatisierungsdruck von vielen Stellen angesichts der Fachkräfteproblematik und Preisdrucks v. a. aus Asien, wo diese Anwendungsfälle bereits umgesetzt werden.

Risiken

Die größte Herausforderung ist das Testen der KI. Die Maschinen sind meist mehrere Millionen Euro wert, nicht selten zweistellig. Die Hersteller der Maschine sind komplett überfordert mit KI, aber der Käufer möchte gerne KI nutzen. Und nun kommt die größte Herausforderung: die Gewährleistung. Sobald man falsche Einstellungen oder sogar Sensorik nachbaut, kann die Gewährleistung verfallen. Daher ist es wichtig, vor dem Kauf drei Themen unbedingt zu klären: Erstens, wem gehören die Daten, die die Maschine (Linie) erzeugt? Zweitens, wie kann man externe KI-Modelle integrieren, die die Maschine automatisch steuern? Drittens: Wie steht es um die Datenhoheit, ein extrem wichtiges und oft unterschätztes Thema?

#7 Qualitätskontrolle

Ziel & Mehrwert

Produktmängel reduzieren

KI-Anwendungsfall

Optimierung, Computer Vision

Beispiel

Besonders bei Metallteilen und bei der Lebensmittelproduktion kann die KI-Qualitätskontrolle Wunder bewirken, da Fehler ohne zeitaufwendige Kontrolle durch menschliche Fachkräfte analysiert werden können. Hinzu kommt, dass die Daten aus der Fehleranalyse an die Produktion zurückgespielt werden können, um Fertigungsprobleme aufzudecken und letztendlich Ausschuss zu minimieren.

Mängel an Teilen werden in einigen Bereichen der Automobilindustrie seit Langem bereits im Fertigungsprozess einer Qualitätskontrolle unterzogen. Besonders bei sicherheitskritischen Werkstücken, die beispielsweise an Achsen oder im Motor verbaut werden, wird hohe Qualität gleichbleibend eine wichtige Rolle spielen. Darüber hinaus passt sich der weitere Verarbeitungsprozess automatisch an die ggf. erkannten Mängel an. Mithilfe von Computer Vision und Tiefensensorik (u. a. mit Ultraschall) erfolgt so die automatische Fehlerdetektion. Bei der Lebensmittelproduktion ist eine relevante Stellgröße das Mindesthaltbarkeitsdatum, was immer stimmen muss. Auch hier lohnt es sich, per Computer Vision die Kontrolle direkt an der Linie einzusetzen.

Reifegrad

Hoch, wenn nicht sogar sehr hoch – technologisch umsetzbar und in der Prozess- und Diskretionsfertigung kurz vor dem Sprung, »Commodity« zu werden.

Wirtschaftlichkeit

Hoch

Handlungsdruck

Hoch – Automatisierung ist das Stichwort sowie »Made in Germany« als Qualitätssiegel zu verteidigen, besonders im produzierenden Mittelstand.

Risiken

Für das Training der KI muss ausreichend Datenmaterial von fehlerhaften Produkten vorliegen; Abhilfe können synthetische Daten mittels generativer KI verschaffen.

#8 Produktionsplanung

Ziel & Mehrwert

Verringerung der Umrüstzeiten sowie Erhöhung der OEE-Kennzahlen

KI-Anwendungsfall

Optimierung und Vorhersage

Beispiel

Stellen wir uns einen fiktiven Keksproduzenten vor, der jeweils ein Werk in Nord- und Süddeutschland betreibt. In jedem Werk gibt es mehrere Linien mit unterschiedlichen Kapazitäten, allerdings sind beide Werke so flexibel, dass sie auch das gesamte Sortiment produzieren können. Nun geht es darum, die Fertigungsaufträge möglichst effizient zu verteilen. Eine komplexe Aufgabe, denn verschiedene Variablen – von der Linienkapazität über Rohstoffe, Logistikwege, Lagerkapazitäten, Mitarbeiterverfügbarkeit etc. – spielen eine Rolle. KI-Modelle können unterstützen, diese Planung zu automatisieren und im nächsten Schritt die Entscheidung zu treffen, wenn kurzfristige Ausfälle oder Lieferschwierigkeiten die Produktion beeinträchtigen.

Je nachdem, ob man in der diskreten oder Prozessfertigung unterwegs ist – die Produktionsplanung ist ein komplexes Konstrukt, wo auch die Anbieter von Standardsoftware Potenziale entdeckt haben, diese zu optimieren. Der Einsatz von KI ist jedoch nicht so trivial, wie man sich das vorstellt, insbesondere, wenn man diese über mehrere Werke und oder Standorte hinweg durchführen möchte. KIs müssen angelernt werden, was normalerweise stattfindet, indem Vergangenheitsdaten (am besten über mehrere Jahre) verwendet werden, um die KI zu trainieren. Die gelernte KI nutzt man dann, um die Produktionsplanung durchzuführen, jedoch ist jedes Fertigungsunternehmen so individuell, dass dadurch die KI-gestützte Planung noch nicht so weit verbreitet ist.

Reifegrad

Technologie ist vorhanden, die Daten sollten auch in Standard-ERP-Systemen vorhanden sein. Doch der Aufwand, diese zu extrahieren und zu nutzen, kann sehr hoch sein kann. Der Anwendungsfall ist aber umsetzbar und auch schon verprobt.

Wirtschaftlichkeit

Hoch

Handlungsdruck

Sehr hoch – die Produktvielfalt und Produktausprägungen wachsen stetig, insbesondere auch durch den Wunsch der Kundschaft auf Individualität.

Risiken

Vertrauen in die KI-Produktionsplanung muss gegeben sein, Fehleinschätzungen müssen unbedingt evaluiert und ausgebessert werden.

Kerngeschäft Marketing & Vertrieb

Dieser Bereich ist zwar nicht wertschöpfend, aber doch essenziell für jedes Unternehmen und auch öffentliche Einrichtungen: Ohne den zielgruppenspezifischen Hinweis auf die eigenen Angebote wird keine Organisation überleben. Zudem unterliegt dieser Bereich ganz besonders dem Einfluss der Digitalisierung, KI-Anwendungsfälle sollten hier in jedem Fall geprüft werden.

#9 Absatzvorhersage

Ziel & Mehrwert

Optimierung des optimalen Produkts

KI-Anwendungsfall

Vorhersage

Beispiel

Wie viel muss ich genau produzieren, damit diese Anzahl auch genau abgenommen wird? Nehmen wir einen fiktiven Bekleidungshersteller, der die T-Shirt-Produktion für die nächste Sommerkollektion plant. Neben den üblichen Variablen der Kundschaft spielen möglicherweise geplante Werbekampagnen oder variable Verkaufspreise eine Rolle. Basierend auf der Vergangenheit kann KI hier den optimalen Bedarf je Größe planen. Dieses Beispiel ist grundsätzlich für alle Produkte denkbar. Einzige Voraussetzung ist – wie so oft – eine gute Datenbasis aus der Vergangenheit mit allen relevanten Datenpunkten, die nach Produkt unterschiedlich sein können.

Bei digitalen Produkten stellt sich diese Frage weniger, doch bei physischen ist sie umso wichtiger. Überproduktion führt zu teuren Lagerhaltungskosten, Unterproduktion beschädigt das Image und führt im schlimmsten Fall zum Verlust der Kundenschnittstelle. KI-Modelle können relativ gut, basierend auf der Vergangenheit und aktuellen Variablen bzw. Parametern, vorhersagen, was produziert werden sollte. Die große Herausforderung ist es hier, die unterschiedlichen Einflüsse wie zum Beispiel Marketing Campaigning, Social Events wie Fußballweltmeisterschaften oder virale Social-Media-Posts zu berücksichtigen, zu operationalisieren und entsprechend zu bewerten. Hier zeigt sich besonders, wie wichtig interdisziplinäre Teams für KI-Entwicklung sind.

Reifegrad

Hoch, wobei gerade der Einzelhandel hier gute Ergebnisse zeigt.

Wirtschaftlichkeit

Standardmodelle sind vorhanden, Einstiegshürde ist auch gering, somit »no brainer«.

Handlungsdruck

Sollte schon im Unternehmen genutzt werden, da die Einstiegshürde hier gering ist.

Risiken

Schlechte Datenbasis, da Fehleinschätzungen sehr teuer enden können.

#10 Texterstellung

Ziel & Mehrwert

Reduzierung der Zeit für das Erstellen oder Prüfen von Texten

KI-Anwendungsfall

Large Language Models (LLM wie ChatGPT oder Aleph Alpha)

Beispiel

Der aktuell wohl offensichtlichste KI-Anwendungsfall ist das Verfassen von Texten für sämtliche Marketingkanäle inklusive klassischer Pressemeldungen oder (werblicher) E-Mails. Kurz nach Veröffentlichung von ChatGPT wurden die sozialen Medien von automatisch generierten Texten geflutet, die augenscheinlich nicht von Menschen formuliert wurden. Besser war und ist es, die automatisch generierten Vorschläge vor Veröffentlichung zu prüfen und anzupassen – im Zusammenspiel mit der Technik entfalten Marketingabteilungen erst ihr volles Potenzial.

Fortgeschrittene Beispiele nutzen die Eingaben (prompts) in generative Chatbot-Systeme, um sie zunächst mit eigenen Daten und Texten anzulernen, damit sie bestimmte Schreibstile kopieren. Schon früh begann außerdem OpenAI, für ChatGPT einen Plugin-Markt zur Verfügung zu stellen – beispielsweise für geprüfte wissenschaftliche Quellen. Wenn diese Quellen nun die eigene Patent- und Innovationsdatenbank sind, erhöht sich die Innovationsrate exponentiell.

Reifegrad

Sehr hoch bei Drittanbietern und einfach umsetzbar

Wirtschaftlichkeit

Sehr hoch, geringe technische Hürden

Handlungsdruck

Extrem

Risiken

Datensicherheit und -schutz, insbesondere bei nicht-europäischen Firmen ist Vorsicht geboten – größere Organisationen sollten ihre eigenen Sprachmodelle antrainieren bzw. feintunen. Das bedeutet nicht immer hohe Investitionen, hier können Open-Source-Modelle wie Llama von Meta genutzt werden oder auch proprietäre Sprachmodelle wie zum Beispiel von Aleph Alpha.

Kerngeschäft Kundendienst & Service

In diesem Bereich geht es um die Kommunikation mit der Kundschaft, die Produkte und Dienstleistungen bereits einsetzt. Bei haptischen Produkten spielt zusätzlich der Bereich »Wartung & Reparatur« sowie der dazugehörige Service eine wichtige Rolle, der stark von KI profitieren kann.

#11 Chatbot (Schrift und Sprache)

Ziel & Mehrwert

Automatisierung des First Level Supports intern und extern

KI-Anwendungsfall

Large Language Models (LLM wie ChatGPT oder Aleph Alpha)

Beispiel

Schon 2019 stellte Google mit seinem Duplex-Assistenten eine KI vor, die im Auftrag der User eigenständig Friseurtermine vereinbaren konnte – am Telefon, nicht per E-Mail. Inzwischen wurden diese Systeme von einigen Großunternehmen mit sehr großen Callcenter-Kapazitäten weiterentwickelt, um insbesondere den First Level Support automatisiert abwickeln zu können. Denn seien wir mal ehrlich: Der Großteil der Anfragen beim Kundenservice lässt sich ohne großen Aufwand lösen, manchmal geht es den Anrufenden einfach darum, schnell eine Lösung für ihr Problem zu bekommen und sie hatten schlicht keine Lust oder Zeit, in der Gebrauchsanweisung oder den FAQ nachzuschauen.

Neben Predictive Maintenance ist dies schon heute ein KI-Klassiker. Die neue Generation der Chatbots basiert auf großen Sprachmodellen wie ChatGPT von OpenAI. Entsprechend gut und schnell sind also auch die Formulierungen am Telefon oder im Chat. Wie schon bei dem Anwendungsfall Texterstellung sind große Sprachmodelle fähig, mit einem Menschen eine sehr ausgiebige und intellektuelle Konversation zu führen. Jedoch werden Chatbots meistens im Kundenservice eingesetzt, und dort ist es wichtig, dass diese spezifische Informationen über das Unternehmen, das Produkt oder kundenspezifische Daten haben, wie zum Beispiel alle Handbücher für die Produkte, den Bestellstatus aller Bestellungen oder Rechnungsdispute. Alle Anwendungsfälle haben unterschiedliche technische Anforderungen. Vom Finetuning des Sprachmodells mit den Handbüchern über Echtzeitverbindung zur CRM-Datenbank oder FI/CO des Unternehmens – KI unterstützt heute in den innovativeren Callcentern bereits die Callcenter-Agents, der nächste Schritt ist die Automatisierung der Sprache.

Reifegrad

Die Nutzung von großen Sprachmodellen ist erst seit Ende 2022 im »Mainstream« – aber schon durchaus länger in der Entwicklung. Vieles ist sicherlich Hype und einige Anwendungsfälle brauchen noch Monate, um sie in einem nutzbaren Reifegrad zu haben.

Wirtschaftlichkeit

Das Potenzial ist enorm in jeder Hinsicht. Von Prozessvereinfachung hin zur Automatisierung bis zur Kundenzufriedenheit.

Handlungsdruck

Riesig, da wohl jedes Technologieunternehmen neue Funktionen und Produktideen verprobt bzw. anbieten will. Gerade der Mittelstand muss sich jetzt (!) Gedanken machen, was das bedeutet für die eigenen Daten und wie die Anbindung an die eigenen Systeme gelingen kann.

Risiken

Die Verwendung von externen bzw. in der Cloud gehosteten Sprachmodellen hat große Datensicherheitsaspekte, die nicht zu unterschätzen sind. Zusätzlich hat der EU AI Act große Auswirkungen auf die Risiken, die aktuell noch nicht bewertet werden können.

#12 ER-Instandhaltung

Ziel & Mehrwert

Schließen der Fachkräftelücke

KI-Anwendungsfall

Computer Vision & Augmented Reality

Beispiel

Ein KI-Anwendungsfall, der aktuell noch eher wenig Aufmerksamkeit in der Masse bekommen hat. Ein großer deutscher Industriekonzern, der unter anderem Rolltreppen und Fahrstühle betreibt, hat sich hier schon vor einigen Jahren als Pionier hervorgetan und sein Personal früh bei der Wartung und Reparatur defekter Technik mit Datenbrillen ausgestattet (in dem Fall Microsoft Hololens). Diese Datenbrillen verfügen über Informationen über die benötigten Maschinen oder Geräte, die zu warten bzw. reparieren sind, und unterstützen das Personal direkt am Einsatzort. Im Zweifelsfall kann über eine Internetverbindung ein direkter Draht zu verfügbaren Kollegen hergestellt werden.

Extended Reality (ER) wird in einigen Jahren Standard im Produktionsumfeld sein (müssen). Insbesondere getrieben durch den Fachkräftemangel können nicht ausgebildete Fachkräfte durch KI-gestützte Geräte Instandhaltungen oder betriebs- bzw. produktionsplanbedingte Änderungen auch ohne spezielle Ausbildung durchführen. KI steckt in diesem Fall in Form von Computer Vision in dem Gerät, das die Augmentation (Erweiterung der Realität) anzeigt. Die Daten vor der Kamera müssen interpretiert werden – ein Teil muss also detektiert und klassifiziert werden. Im Anschluss kann der visuell geführte Prozess folgen und Beschäftigte anleiten. Voraussetzungen sind unter anderen, dass die relevanten Objekte erkannt und diese mit der eigenen Teile-Datenbank abgeglichen werden, eine Visualisierung erstellt wird und schließlich der korrekte Prozess beispielsweise für den Austausch oder die Reparatur eines Teils angeleitet wird.

Reifegrad

In den Anfängen

Wirtschaftlichkeit

Enorm – sowohl für Fachkräftelücke als auch Maschinenoptimierung und weitere Automatisierung.

Handlungsdruck

Mäßig, aber first mover sind schon lange aktiv.

Risiken

Datenschutz und -sicherheit; unbedingt Betriebsrat rechtzeitig einbinden (Stichwort Überwachung, potenzieller Missbrauch, Vertrauen in Technik, Corporate Digital Responsibility).

Der zweite der beiden großen Bereiche von Aktivitäten, die wir uns anschauen, sind die Verwaltung und das Management – also die unterstützenden Aktivitäten in jeder Organisation.

Management & Organisation

In diesem Bereich fokussieren wir auf die Verwaltung und KI-Potenziale für die Organisation von Unternehmen oder öffentlichen Einrichtungen. An dieser Stelle wird schnell deutlich, dass Lösungen immer sehr individuell ausfallen, weshalb wir nur zwei Anwendungsbeispiele ausgewählt haben.

#13 Szenarienmanagement

Ziel & Mehrwert

Strategische Überlegungen regelmäßig und ohne externe Beratung durchführen

KI-Anwendungsfall

Simulation und Large Language Models (LLM wie ChatGPT oder Aleph Alpha)

Beispiel

Die meisten Organisationen planen höchstens drei bis fünf Jahre in die Zukunft und fokussieren stattdessen aufs Tages- und Kerngeschäft. Dabei ist spätestens nach den letzten Krisen globalen Ausmaßes (ihr wisst schon, welche) deutlich geworden, dass ein umfassendes 360°-Monitoring sowie langfristige Vorausschau überlebenswichtig sein können. Einige der Krisen, Kriege oder Katastrophen der letzten fünf Jahre waren vorhersehbar – allerdings nicht, wenn man nur alle fünf Jahre ein Update der langfristigen Strategie macht. Umso wertvoller sind Szenarienprozesse und strategische Vorausschau (Foresight) in Organisationen heute und in Zukunft.

Insbesondere große Sprachmodelle in Verbindung mit individuellen Vorhersagemodellen ermöglichen es, strategische Fragestellungen deutlich effizienter und effektiver zu antizipieren. Dabei sollten sich Organisationen aber auf keinen Fall auf vorhandene Sprachmodelle wie ChatGPT verlassen, sondern eigene Systeme antrainieren, die wiederum externe Datenströme auslesen können. Hinzu kommen qualitative Einschätzungen speziell geschulten Personals, das auf sogenannte Wildcards hinweist, sodass die Systeme das Internet kontinuierlich auf schwache Signale für deren Eintreten absuchen können. Das Ziel ist eine regelmäßige Szenarienauswahl mit unterschiedlichen Eintrittswahrscheinlichkeiten, gern erweitert um Simulationen und KI-generierte Texte und andere Medien zur Visualisierung, um ein zentrales Warnmanagement für potenzielle Disruptionen zu er halten – sowie Anlässe, um im Management über konkrete Handlungsoptionen zu sprechen.

Reifegrad

Sehr gering, für first mover der Startzeitpunkt

Wirtschaftlichkeit

Je nach Einsetzung des Werkzeuges kann es über den Fortbestand einer Unternehmung entscheiden.

Handlungsdruck

Essenziell für Unternehmen, die generationsübergreifend planen bzw. wirtschaften – mindestens ab Mittelstand aufwärts großer Druck.

Risiken

Untätigkeit wäre hier das größte Risiko; ganz ohne Datenauswertung kann in der VUCA-Welt des 21. Jahrhunderts keine resiliente Strategie mehr auskommen.

VUCA

Deutsch: VUKA. VUCA steht für Volatility (Volatilität), Uncertainty (Ungewissheit), Complexity (Komplexität) und Ambiguity (Mehrdeutigkeit) und fasst vier zentrale Herausforderungen der globalisierten und digitalen Welt im 21. Jahrhundert zusammen.

#14 Dunkelverarbeitung von Rechnungen

Ziel & Mehrwert

Rechnungsverarbeitung automatisieren

KI-Anwendungsfall

Maschinelles Lernen (ML)

Beispiel

Ob im Einzelhandel, in der Finanzberatung, in der Fertigung oder in Kliniken: In allen Organisationen fallen täglich unzählige unstrukturierte Informationen an, darunter (Ab-)Rechnungen. In vielen Bereichen werden immer noch Papierrechnungen verschickt, doch das ist seit einigen Jahren eigentlich nicht mehr nötig. Ab dem Zeitpunkt der Digitalisierung einer Rechnung, beispielsweise durchs Einscannen mit dem Smartphone kann KI den darin enthaltenen Text digitalisieren und ihn zur Verarbeitung vorbereiten. Im Fall von Rechnungen nutzen dies große Softwarehäuser beispielsweise im Buchhaltungssegment bereits dazu, erste Buchungsvorschläge oder Einordnungen vorzuschlagen. Komplexere Themen könnten die Prüfung des korrekten Buchungskreises, die Zuordnung von Bestellung und Lieferschein zur Rechnung umfassen. Einige Länder haben hier schon Lösungen entwickelt und die EU arbeitet an einem Gesetz.

Reifegrad

Hoch – einige Software-Dienstleister bieten Lösungen an, sogar Voll-Service-Anbieter sind schon vorhanden: Rechnungen werden direkt an diese geschickt und dort »dunkel« verarbeitet, also automatisch bereinigt, aggregiert, analysiert und für Entscheidungen vorbereitet.

Wirtschaftlichkeit

Je nach Unternehmensgröße ein interessanter Anwendungsfall, der auch schnell wirtschaftlich sein kann.

Handlungsdruck

Mittel bis hoch, je nach Altersdurchschnitt in dem Segment; der Nachwuchs der Studierenden und Azubis wird bereits mit den Grundlagen der Automatisierung vertraut gemacht.

Risiken

Buchung von nicht validen Rechnungen. Es kommt immer wieder vor, dass Unternehmen Rechnungen bekommen, in denen sich beispielsweise die Bankdaten geändert haben. Dabei kann es sich auch um Betrug handeln; hier muss ein Fokus auf die Sicherheit gelegt werden.

IT

Dieser Bereich wurde von Michael Porter noch nicht als unterstützende Aktivität definiert, heute ist er es definitiv. Schließlich spielt sich ein Großteil der Aktivitäten einer Organisation auf Computern ab.

#15 Vorausschauende Wartung (Predictive Maintenance)

Ziel & Mehrwert

Logfile-Überwachung

KI-Anwendungsfall

Vorhersage und Optimierung

Beispiel

Obwohl KI-Entwicklung im IT-Bereich verortet wird, kommen in der IT-Infrastruktur nur selten KIs zum Einsatz. Dabei fallen gerade hier sehr viele Daten an, beispielsweise beim Server und dessen Prozessen, Festplatten, Arbeitsspeicher, Netzwerk Switch oder die Softwarelösungen – die Rede ist von Logfiledaten. An dieser Stelle ist das Training einer KI auf Anomalien sehr gut möglich. Zwar kommt es eher selten zu Auffälligkeiten, doch wenn sie auftreten und der Server einer Keksfertigung und zusätzlich dessen redundantes System ausfällt, wird dies ein sehr teurer Schaden.

Ein weiterer Anwendungsfall wird durch Sprachmodelle möglich. Trainiert man ein eigenes Unternehmens-GPT mit Logfiledaten, können mittels intelligenter Abfragen Mehrwerte gefunden werden, die nicht trainiert wurden. Hinzu kommt die Möglichkeit, Anomalie-Datensätze zu erstellen, mit denen weitere KI-Modelle trainiert werden können.

Reifegrad

Gering, außer bei Firewall oder Spamfiltern

Wirtschaftlichkeit

Da die KI-Experten ja schon in der IT sitzen und quasi das Verständnis für die jeweiligen Anwendungsfälle bereits mitbringen, ist das ein »no brainer«, also definitiv wirtschaftlich und einfach umsetzbar.

Handlungsdruck

Im Zeitalter von Cloud nicht unbedingt der höchste Handlungsdruck, doch auch hier können KI-Modelle helfen, die Cloud-Kosten zu reduzieren, indem sie Lastspitzen prognostizieren und entsprechend automatisch reagieren. Für Unternehmen, die nach wie vor auf physische Datenspeicher setzen, definitiv ratsam.

Risiken

Es fallen Unmengen von Daten an; hier ist es wichtig, nicht den Überblick zu verlieren und sich auf die wesentlichen zu konzentrieren. Da wäre auch eine FMEA (Fehlermöglichkeits- und Einflussanalyse) im IT-Betrieb ein ratsamer Prozess.

#16 Programmierung

Ziel & Mehrwert

Software-Entwicklung automatisieren

KI-Anwendungsfall

Large Language Models (LLM wie ChatGPT oder Aleph Alpha)

Beispiel

Einige Programmiertechniken beherrschen ChatGPT und Co. bereits hervorragend. So kann mit einfachen Texteingaben der Code für Websites, Javascript und viele andere Programmierbausteine automatisch erzeugt werden. Dadurch können inzwischen auch Menschen ohne Programmierkenntnisse einfache Anwendungen realisieren. Der Produktivitätsgewinn ist enorm. Das ersetzt allerdings nicht die Programmierer, denn für komplexe Ideen und Programmierbausteine benötigt es nach wie vor den Menschen. Aber die Produktivität eines Entwicklers ist mit der Hilfe solcher Unterstützung enorm steigerbar.

So zum Beispiel auch beim sogenannten »Debugging«, mit dem Programmierer:innen einen nennenswerten Teil ihrer Arbeitszeit verbringen, also der Suche und Korrektur von fehlerhaftem Code, auch während des Entwicklungsprozesses. Dieser Schritt kann mithilfe von großen Sprachmodellen deutlich beschleunigt werden, wodurch die Effizienz von Programmierung deutlich erhöht wird – in Zeiten von IT-Fachkräftemangel ist dieses Element somit Gold wert.

Reifegrad

Gering, aber mit einer wahnsinnig schnellen Entwicklung, sodass man hier nicht sagen kann, wie weit der Anwendungsfall in wenigen Monaten entwickelt sein wird. Er ist jetzt aber schon in vielen Programmierabteilungen angekommen und nicht mehr wegzudenken.

Wirtschaftlichkeit

Sehr einfach umsetzbar und damit sehr schnell wirtschaftlich

Handlungsdruck

Riesiger Handlungsdruck, da viele Unternehmen damit bereits experimentieren, um Ideen noch schneller in die Umsetzung zu bringen.

Risiken

Geistiges Eigentum bzw. intellectual property – wann immer Entwicklungen durch KI-Systeme erzeugt werden, die nicht von der eigenen Organisation betrieben werden, sind buchstäblich urheberrechtliche Konflikte vorprogrammiert. In dem Fall: Mit welchem Programmier-Code wurde die KI trainiert? Das kann in Zukunft zu Herausforderungen kommen, wenn Gerichte entscheiden, dass ein bestimmter Programmier-Code nicht verwendet werden darf.

Personalwesen / HR

In diesem Bereich schauen wir auf eine der wohl wichtigsten unterstützenden Aktivitäten jeder Organisation: auf das Personal und wie dessen Management von KI-Anwendungen profitieren kann.

#17 Bewerberanalyse

Ziel & Mehrwert

Unternehmenskultur KI-basiert verbessern, Konflikte vorwegnehmen, geeignetes Personal finden

KI-Anwendungsfall

Affective AI, Predictive Behavioral Analytics

Beispiel

Welcher Bewerber, welche Bewerberin passt am besten ins Team? Diese Frage wird bis heute in der Regel anhand einer strukturierten Vorgehensweise, vor allem aber nach dem Bauchgefühl beantwortet. Doch Teamkultur und einige Charaktereigenschaften lassen sich messen. Und so hat das britische Unternehmen Starling Trust schon früh genau das getan und stellt seine KI-Software Unternehmen zur Verfügung, die maximal rationale Personalentscheidungen treffen möchten. Ist Person X eher risikoscheu, eher Teamplayer oder Individualist, sagt sie die Wahrheit?

Es handelt sich unserer Einschätzung nach um einen sehr spannenden Anwendungsfall, der allerdings berechtigterweise Datenschützer:innen, Betriebsräte oder auch Gewerkschaften auf den Plan ruft. Allein die Auswertung des Lebenslaufs oder die Analyse von Bewerbungsgesprächen (Video und Audio) drängt uns an die Grenzen des ethisch Vertretbaren.

Reifegrad

Sehr hoch und einfach umsetzbar

Wirtschaftlichkeit

Definitiv hoch, aber rechtliche Fragestellungen unbedingt klären!

Handlungsdruck

In Europa eher nicht gegeben, aber in anderen Länder definitiv – klare ethische Fragestellung, wie sich ein Arbeitgeber dazu positioniert. Möglicherweise lohnt sich hier die goldene Mitte einer Mischung aus menschlicher und künstlicher Intelligenz, sofern eine Zustimmung erteilt wurde.

Risiken

Im Rahmen der DSGVO und des EU AI Acts sehr schwer umsetzbar, wenn überhaupt.

#18 Kündigungsprognose (Fluktuationsprognose)

Ziel & Mehrwert

Kündigungen vorhersagen und verhindern

KI-Anwendungsfall

Big Data und maschinelles Lernen (ML)

Beispiel

Ein KI-Anwendungsfall, der tatsächlich einfacher ist als gedacht. Anhand eines Personalwechsel-Index (Turnover Propensity Index, TPI) lässt sich mittels weniger Datenpunkte sowie eines ML-Algorithmus frühzeitig erkennen, wie wahrscheinlich die Kündigung oder ein Wechsel von Angestellten aktuell ist. Wichtige Variablen dafür sind beispielsweise organisationale Ereignisse wie markante Umsatzveränderungen, Neufirmierungen, Fusionen oder Wechsel der Führungskräfte oder persönliche Ereignisse der Angestellten von Nachwuchs über Weiterbildungen zu Verlust von Angehörigen; der Anstieg an Krankheitstagen und die ungewöhnliche Verteilung von Urlaubstagen sind hierbei besonders wertvolle Indikatoren. Je nach Stichprobengröße und Datensatz lassen sich einige Variablen sogar mit Wahrscheinlichkeiten modellieren, um anschließend die Führungskräfte und / oder das Personalwesen zu sensibilisieren und besonders im Falle von sehr wertvollen Stellen den Wechsel oder die Kündigung doch noch abzuwenden.

Reifegrad

Gering, aber umsetzbar, und lässt sich auch teilweise ohne KI umsetzen.

Wirtschaftlichkeit

Abhängig vom Rationalisierungsgrad des Personalwesens (HR) und teilweise auch von der Organisationsgröße; grundsätzlich sind Rekrutierungs- und Einarbeitungszeiten sowie andere Opportunitätskosten der Neubesetzung von Stellen enorm.

Handlungsdruck

Gering

Risiken

Passt eine HR-KI zur Firmenkultur? Wenn nicht, Finger weg. Entscheidend ist zudem die Compliance (Regeltreue) mit dem Datenschutz sowie eine minutiöse Co-Entwicklung mit Personal- bzw. Betriebsrat.

Forschung & Entwicklung

Innovative Organisationen forschen stetig an der Verbesserung ihrer eigenen Produkte und Dienstleistungen. Anschließend werden die Erkenntnisse aus der Forschung in die Entwicklungsabteilungen weitergegeben. Auch hier kann KI Potenziale heben.

#19 Produktentwicklung

Ziel & Mehrwert

Innovationen effizienter entwickeln

KI-Anwendungsfall

Large Language Models (LLM wie ChatGPT oder Aleph Alpha)

Beispiel

Ein fiktives Architekturbüro hat sämtliche Ingenieursdokumente, Normen und CAD-Zeichnungen in ein multimodales Sprachmodell eingegeben, um mit einfachen Sprachbefehlen neue Produkte zu entwickeln. Im Ergebnis werden sowohl Texte und Bilder als auch genaue Konstruktionsdaten ausgegeben. Dieser Anwendungsfall könnte auch ohne konkrete Aufgabenstellung funktionieren und bislang unlösbare Probleme ins Zentrum stellen, so zum Beispiel die Erforschung neuer Materialkombinationen mit verfügbaren Fertigungstechnologien. Mithilfe der ausgereiften Weltmodelle (Foundation Models) und digitaler Zwillinge könnte KI, kombiniert mit kreativen Innovationsteams, einen erheblichen Innovationssprung in allen Branchen auslösen.

Durch die KI-Fähigkeiten lassen sich neue Produkte, Materialien und Services entwickeln, die vorher unmöglich waren. Wir sind hier noch am Anfang des Möglichen, aber vor allem Sprachmodelle werden hier insbesondere im Medikamentenumfeld und in der Materialforschung neue Wege deutlich schneller und effizienter ermöglichen als vorher. Die Frage ist: Wie stark wird KI den Produktentwicklungsprozess verändern? Die Antwort aus unserer Sicht ist klar: komplett. Wir sind an einem Punkt angekommen, wo menschliche Fähigkeiten nicht mehr mit den Möglichkeiten einer KI mithalten.

Reifegrad

Gering, aber hier werden bald pfiffige Start-ups Werkzeuge entwickeln, um mehrere KI-Disziplinen zu kombinieren und dadurch einen Mehrwert zu erzeugen. Die Innovationsgeschwindigkeit wird hier in den nächsten Jahren sehr hoch sein und diejenigen, die sich nicht »jetzt!« damit befassen, werden einen Wettbewerbsnachteil erleiden.

Wirtschaftlichkeit

Sehr hoch, je nach Produkt und Zielstrebigkeit der Umsetzung

Handlungsdruck

»Make or break an organization« – Unternehmen leben davon, sich weiterzuentwickeln, ihre Produkte und Prozesse zu optimieren und neue Produkte auf den Markt zu bringen. KI wird hier neues Potenzial freisetzen. Anders ausgedrückt: Wenn ein Wettbewerber schneller ist und KI erfolgreich einsetzt, wird der Vorsprung nicht so leicht einholbar sein.

Risiken

Geistiges Eigentum (IP) muss geschützt werden, und da kommt eine kompetente IT zum Tragen. Diese Daten zu schützen und Datenabfluss absolut auszuschließen, muss höchste Priorität haben. Somit ist dies nicht nur ein KI-Thema, sondern multidisziplinär hinweg über KI, IT, Informationssicherheit, Engineering, Marketing und vor allem die Geschäftsführung, die diese Themen verstehen muss und die Priorität entsprechend vorgibt.

#20 Patenttexte

Ziel & Mehrwert

Forschung & Entwicklung optimieren

KI-Anwendungsfall

Large Language Models (LLM wie ChatGPT oder Aleph Alpha)

Beispiel

Im Top-Management eines Automobilkonzerns wird beschlossen, dass in eine neue Region expandiert werden soll. Anstatt einen monatelangen Prozess zur Marktforschung und Anwendbarkeit der Produkte oder Dienstleistungen anzustoßen, erfolgt lediglich die Eingabe ins UnternehmensGPT. Sekunden später stehen die Marktdaten parat, wenige Minuten später werden angepasste und nebenbei kostenoptimierte Konstruktionspläne für den Neubau von Fertigungsanlagen, Logistikanbieter sowie ein Entwurf von Patent- und Markenanmeldungen für regionale Patentämter geliefert.

Die bekannten Sprachmodelle wie ChatGPT oder Luminous haben keinen inhaltlichen Fokus – ihre Stärke liegt in der allgemeinen Kommunikationsfähigkeit mit Rückgriff auf Allgemeinplätze. Wirtschaftlich spannend werden die Modelle erst, wenn sie in gesicherten Umgebungen auch die unternehmensinternen Daten, Prozesse und strategischen Ziele verarbeiten können.

Reifegrad

(Offiziell) Noch nicht vorhanden, aber nur eine Frage der Zeit und nicht in Jahrzehnten, sondern eher in Jahren oder Monaten.

Wirtschaftlichkeit

Entwicklungsaufwand zwar hoch, mittelfristig aber sehr rentabel und langfristig auch anwendbar auf Heimmärkte.

Handlungsdruck

Gering

Risiken

Die Entwicklung eines komplett eigenen Sprachmodells intern ist sehr teuer, mit Partnern datensensibel, zudem menschliches Know-how in Zielmärkten nicht zu unterschätzen (human in the loop!). Jedoch gilt auch hier wieder: Es muss nicht gleich ein eigenes Modell trainiert werden, sondern vorhandene Modelle können mit den eigenen Unternehmensdaten angepasst werden.

Beschaffung

Dieser letzte Bereich fokussiert auf den Prozess vor allem im produzierenden Gewerbe, wonach stets die Verträge mit Zulieferern oder die Auswahl von Rohstoffen eine wichtige Rolle spielen.

#21 Preisverhandlung

Ziel & Mehrwert

Optimierte und konkrete Preisverhandlung

KI-Anwendungsfall

Maschinelles Lernen (ML)

Beispiel

Preisverhandlungen sind eine anstrengende und nervenaufreibende Tätigkeit. Eine fiktive Keksfabrik möchte zum Beispiel eine neue Supermarktkette von ihren Produkten überzeugen und sollte theoretisch eine Win-win-Situation erzeugen – gar nicht so leicht in einem umkämpften Markt. Der Supermarkt muss das Gefühl haben, den bestmöglichen Preis zu erhalten, und umgekehrt muss die Keksfabrik die Rendite erhöhen, da die Produktionskosten gestiegen sind.

Hier können Sprachmodelle helfen, die Argumentation zu automatisieren, insbesondere im E-Mail-Verkehr. Zusätzlich können sie dabei unterstützen, Informationen schnell zu finden und bereitzustellen. Voraussetzung hierbei ist, dass die Sprachmodelle aktuell sind bzw. eine Echtzeit-Verbindung ins Internet und natürlich die CRM- und ERP-Systeme haben.

Reifegrad

Gering

Wirtschaftlichkeit

Mittel, je nach Qualität des Sprachmodells

Handlungsdruck

Sehr unterschiedlich je nach Branche, Marktumfeld und Preisdruck

Risiken

Das größte Risiko hier ist, dass Sprachmodelle dazu tendieren zu halluzinieren. Das bedeutet, dass sie in manchen Situationen Fakten frei erfinden. Diese Halluzinationen weitestgehend zu unterbinden, bedarf noch technologischer Weiterentwicklung bzw. Modellen, die konkret anzeigen, worauf ihre Aussagen beruhen.

Spannend wird auch sein, wenn auf beiden Seiten Sprachmodelle eingesetzt werden, wie zum Beispiel in der Kommunikation via E-Mail. Was passiert dann? Diese Frage ist vermutlich bereits Realität, und aktuell gibt es dazu noch keine Antwort. Definitiv ein Risiko, mit dem man sich auseinandersetzen sollte.

#22 Lieferantenauswahl

Ziel & Mehrwert

KI-gestützte Optimierung der Kosten

KI-Anwendungsfall

Large Language Models (LLM wie ChatGPT oder Aleph Alpha)

Beispiel

Unsere fiktive Keksfabrik möchte eine neue Produktreihe erproben, die auf komplett anderen Rohstoffen basiert – zum Beispiel vegane Dinkelkekse, deren Zutaten vorher noch nicht verarbeitet wurden. Früher hätte das Personal vielleicht über eine gewöhnliche Suchmaschine versucht, einen ersten Überblick über relevante Lieferanten der benötigten Zutaten zu erhalten. Nach spätestens zwei Ergebnisseiten wäre die Suche beendet und eine ausreichende Kontaktliste erstellt. Mithilfe von Sprachmodellen wird es in naher Zukunft möglich sein, eine gewünschte Liste der zehn am besten bewerteten Lieferanten zu erstellen inklusive der Angaben über durchschnittliche Preise und Lieferzeiten.

Es ist nur ein kleiner weiterer Schritt nötig, um daraufhin Entscheidungsvorlagen in PowerPoint (o. Ä.) für die Geschäftsführung und den potenziellen Lieferanten zu erzeugen, um ein Angebot einzufordern.

Reifegrad

Gering – wie bei all den anderen Anwendungsfällen mit LLM (Sprachmodellen) stehen wir hier noch am Anfang und die Innovationskurve wird in den nächsten Monaten und Jahren steil ansteigen. Insbesondere Start-ups werden hier innovative Automatisierungslösungen bereitstellen.

Wirtschaftlichkeit

Hoch angesichts der Automatisierung von Prozessen.

Handlungsdruck

Gegeben, um Beschäftigte zu entlasten.

Risiken

Wie bei allen Sprachmodellen können Fehler durch KI-Halluzinationen passieren. Der Mensch bleibt also (vorerst?) wichtig zur Überprüfung der Entscheidungsvorlagen.

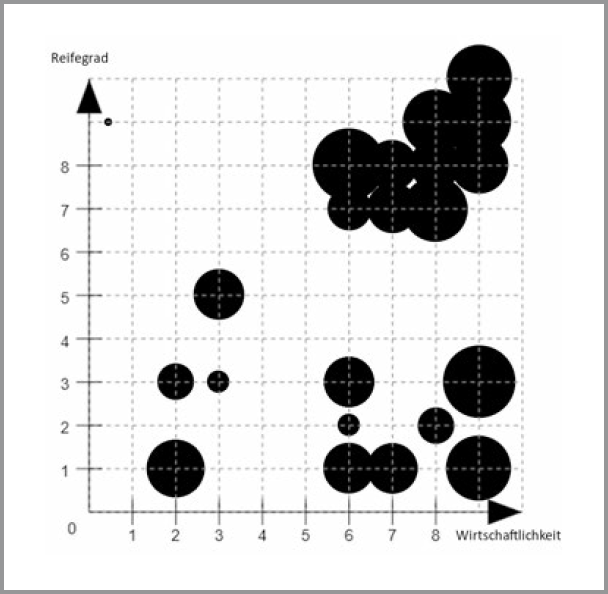

Koordinatensystem aller 22 KI-Anwendungsfälle

Hier findet ihr die 22 Anwendungsfälle in einem Koordinatensystem. Jeder Anwendungsfall ist durch einen Kreis symbolisiert, die Größe der Kreise steht für den Handlungsdruck:

- ■ klein = sehr gering,

- ■ groß = sehr hoch.

Die untere x-Achse bildet die Wirtschaftlichkeit ab, die linke y-Achse steht für den Reifegrad. Beide bewegen sich auf der Skala von 0 (unrealistisch oder unethisch) bis 10 (gesichert).

Hier wird auf einen Blick ersichtlich, dass wir einen Fokus auf relativ reife und wirtschaftliche Anwendungsfälle gelegt haben. Besonders spannend sind aber gerade die Ausreißer, die noch nicht besonders reif sind, dafür aber eine hohe Wirtschaftlichkeit versprechen.

Fazit

Die Anwendungsfälle zeigen sehr deutlich, dass es schon zahlreiche Möglichkeiten gibt, KI im Unternehmen einzuführen. Und das ist nur die Auswahl, die wir getroffen haben – angefangen haben wir mit über 40 real existierenden Beispielen, die wir dann aber gekürzt haben.

Besonders die Wirtschaftlichkeit der Umsetzung ist in vielen Fällen sehr positiv zu bewerten, der Reifegrad variiert noch recht stark. Die Bewertung des Handlungsdrucks haben wir auf der Grundlage von vielen Gesprächen mit anderen Brancheninsidern vorgenommen. Alle Werte basieren letztlich auf unserer Einschätzung und können in manchen Branchen oder Regionen in beide Richtungen variieren; dazu kommt, dass zur Veröffentlichung des Buchs wieder ein paar Monate vergangen sein werden, nachdem wir die unten stehende Tabelle erstellt haben.

Die Geschwindigkeit, mit der sich besonders die Wirtschaftlichkeit der Anwendungsfälle verändern wird, dürfte auch infolge des ChatGPT-Moments nochmals zulegen. Immerhin sind die Investitionen in KI seitdem global angestiegen, was auch die Gründung zahlreicher Startups in vielen profitablen anwendungsorientierten Bereichen mit sich bringt. Konkurrenz erwarten wir aus Asien, wo KI deutlich positiver bewertet, entsprechend gefördert und auch schneller eingesetzt wird. In Deutschland werden die Unternehmen nur eigenständig erfolgreich in die erweiterte KI-Anwendung kommen, wenn es genug mutige Entscheidungsträger gibt, die zudem risikoaffine Geldgeber für ihre Ideen begeistern können.

Und so tragen wir hoffentlich mit diesem Buch einen Teil dazu bei, dass »Made in Germany« nicht nur ein Teil der Vergangenheit, sondern auch der Zukunft sein wird.

Auf einen Blick

Dies ist eine Zusammenfassung des Kapitels, die ihr gern fotografieren und mit anderen teilen oder sie ausgedruckt ins Büro hängen könnt.

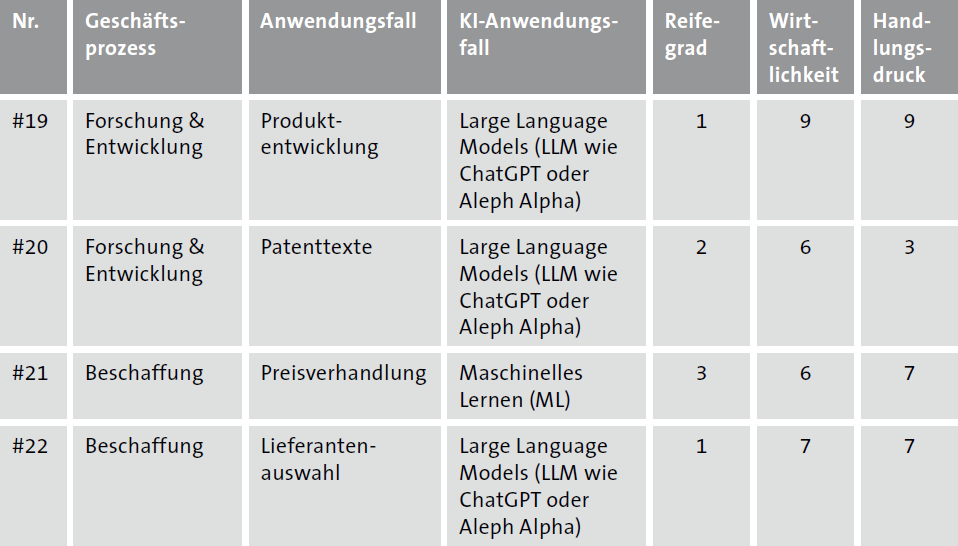

Tabelle aller 22 KI-Anwendungsfälle

Die folgende Tabelle führt auf einen Blick alle Anwendungsfälle von oben auf samt der Werte, die wir für Reifegrad, Wirtschaftlichkeit und Handlungsdruck vergeben haben.