Bits und Bytes

Die Größe eines Computerspeichers (des RAM-Speichers oder einer Festplatte) wird in Bits oder Bytes angegeben, heutzutage eher in Gigabytes oder sogar Terabytes. Was hat es genau damit auf sich? Dazu muss man wissen, wie ein Computer eine Zahl oder einen Buchstaben überhaupt speichert. Schließlich schreibt er keine kleinen Zettel, auf denen die Werte draufstehen. Der Prozessor und der Speicher eines Computers bestehen im Wesentlichen aus Millionen bzw. Milliarden winziger Transistoren. Das sind elektronische Bauteile, die wie Schalter funktionieren, die man durch Strom ein- oder ausschalten kann und die ihren Zustand behalten, solange der Computer Strom bekommt. Jeder dieser Schalter wird als ein Bit bezeichnet. Mit einem Bit kann man die Zahl 1 oder die Zahl 0 speichern – 1 heißt: Der Schalter ist angeschaltet. 0 heißt: Er ist ausgeschaltet.

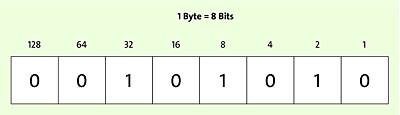

Wie speichert man nun größere Zahlen als 1 oder 0? Ganz einfach: Indem man mehrere Bits zu einer Zahl zusammenfasst. Eine Gruppe von 8 Bits wird als Byte bezeichnet. Mit einem Byte kann man bereits alle ganzen Zahlen von 0 bis 255 speichern. Das ist nämlich die Anzahl der möglichen Kombinationen von Einsen und Nullen in 8 Bits.

Abbildung 2.2 Ein Byte besteht aus 8 Bits – hier die Zahl 42 als Byte dargestellt.

Ein Zahlensystem, das nur aus Einsen und Nullen besteht, nennt man auch Dualsystem oder Binärsystem. Damit arbeitet jeder Computer intern, und in diesem System kann man alle Zahlen der Welt speichern, nur dass man mehr Stellen braucht als in unserem sonst üblichen Dezimalsystem, das wir gewohnt sind.

[+] So speichert der Computer Zahlen mit 8 An-Aus-Schaltern

00000000 = 0

00000001 = 1

00000010 = 2

00000011 = 3

00000100 = 4

00000101 = 5

11111111 = 255

Man könnte mit 8 Bits bei Bedarf auch die Zahlen von –127 bis +127 darstellen, indem man das erste Bit als Vorzeichen deutet (0 = plus, 1 = minus) und die restlichen Bits als Zahlenwert versteht.

Und da 256 verschiedene Zahlen mehr sind als es Buchstaben in unserem Alphabet gibt, kann man jedes Byte nicht nur als eine Zahl, sondern auch als einen Buchstaben bzw. ein Schriftzeichen verstehen. Dazu wurde früher der ASCII-Code erfunden: 65 steht darin zum Beispiel für A, 66 für B, 67 für C usw. So kann ein Byte im Computer für eine von 256 Zahlen oder auch für eines von 256 Zeichen stehen.

Weil aber viele Berechnungen höhere Zahlenräume benötigen, werden heutzutage mehr als 8 Bits zu einem Wert zusammengefasst. Zunächst 16 Bit (genannt ein Word oder Doppelbyte – damit gehen schon 65.536 verschiedene Ganzzahlen), dann 32 Bit und dann auch noch 64 Bit. Mit 64 Stellen lassen sich die meisten Werte, die heutzutage in Berechnungen gebraucht werden, problemlos darstellen. Dementsprechend hat sich auch der Aufbau der Prozessoren (= Rechenmodule) im Computer geändert. Während die frühen Computer 8-Bit-Prozessoren hatten, also 8 Bit gleichzeitig verarbeiten konnten, erschienen später die 16-Bit-Computer, dann kamen 32 Bit – heutzutage haben die aktuellen Computer eine 64-Bit-Architektur. Das heißt, dass in der Regel 64 Bits zu einem Wert zusammengefasst werden und gleichzeitig vom Prozessor in einem Befehl verarbeitet werden können.

[+] Kilo, Mega, Giga, Tera: Speicherkapazitäten wachsen mit ihren Aufgaben

Ein Byte sind also 8 Bit, also 8 Transistorschalter auf einem Chip. Bei den ersten Computern in den frühen 1980er-Jahren wurde die Gesamtkapazität des Computerspeichers in Kilobyte angegeben – Kilo steht für tausend, aber wegen des Binärsystems waren damit exakt 1.024 Byte gemeint. Ein Homecomputer hatte damals 4, 8, 16, 32 oder 64, später 128 Kilobyte. Das galt in den 1980er-Jahren als »ausreichend für alle Aufgaben«. Dann kamen die ersten Festplatten auf den Markt. Sie konnten von Anfang an mehrere tausend Kilobyte speichern. Da sie somit mehrere Millionen Byte speicherten, drückte man ihre Größe in Megabyte aus. 1 Megabyte sind also etwa 1 Million Bytes. Festplatten hatten früher 5, 10, 20 und dann immer mehr Megabytes Kapazität. Als dann einige Jahre danach die 1.000-Megabyte-Grenze überschritten wurde, begann man, die Größe in Gigabyte auszudrücken. 1 Gigabyte sind also etwa 1.000 Megabyte. Auch der elektronische Speicher der meisten Computer heute bewegt sich im Gigabyte-Bereich. Und bei Festplatten geht es heute zumeist um Terabytes. 1 Terabyte = 1.000 Gigabyte = 1 Million Megabyte = 1 Milliarde Kilobytes = 1 Billion Bytes = 8 Billionen Bits.