. Das Problem P wird auch unrestringiertes Optimierungsproblem

genannt. Allgemeiner werden manchmal auch Probleme mit offener zulässiger Menge M als unrestringiert bezeichnet. In der Tat lassen sich die im folgenden Abschn. 2.1 besprochenen Optimalitätsbedingungen ohne Weiteres auf diesen Fall übertragen, was wir aus Gründen der Übersichtlichkeit aber nicht explizit angeben werden. Abschn. 2.2 diskutiert ausführlich verschiedene numerische Lösungsverfahren für unrestringierte Optimierungsprobleme, die auf den zuvor hergeleiteten Optimalitätsbedingungen basieren.

. Das Problem P wird auch unrestringiertes Optimierungsproblem

genannt. Allgemeiner werden manchmal auch Probleme mit offener zulässiger Menge M als unrestringiert bezeichnet. In der Tat lassen sich die im folgenden Abschn. 2.1 besprochenen Optimalitätsbedingungen ohne Weiteres auf diesen Fall übertragen, was wir aus Gründen der Übersichtlichkeit aber nicht explizit angeben werden. Abschn. 2.2 diskutiert ausführlich verschiedene numerische Lösungsverfahren für unrestringierte Optimierungsprobleme, die auf den zuvor hergeleiteten Optimalitätsbedingungen basieren.2.1 Optimalitätsbedingungen

Zur Herleitung von ableitungsbasierten notwendigen bzw. hinreichenden Optimalitätsbedingungen führen wir in Abschn. 2.1.1 zunächst das ableitungsfreie Konzept der sogenannten Abstiegsrichtung für eine Funktion f an einer Stelle  ein. Für jede differenzierbare Funktion f lässt sich mit Hilfe der (mehrdimensionalen) ersten Ableitung von f an

ein. Für jede differenzierbare Funktion f lässt sich mit Hilfe der (mehrdimensionalen) ersten Ableitung von f an  eine hinreichende Bedingung dafür angeben, dass eine Richtung Abstiegsrichtung für f an

eine hinreichende Bedingung dafür angeben, dass eine Richtung Abstiegsrichtung für f an  ist, woraus wir in Abschn. 2.1.2 als zentrale notwendige Optimalitätsbedingung die Fermat’sche Regel herleiten werden.

ist, woraus wir in Abschn. 2.1.2 als zentrale notwendige Optimalitätsbedingung die Fermat’sche Regel herleiten werden.

Die dafür erforderliche Definition der mehrdimensionalen ersten Ableitung führt auf den Begriff des Gradienten der Funktion f an  , der selbst ein Vektor der Länge n ist. Die in Abschn. 2.1.3 diskutierten geometrischen Eigenschaften solcher Gradienten sind grundlegend für das Verständnis sowohl der Optimalitätsbedingungen als auch der numerischen Verfahren in Abschn. 2.2.

, der selbst ein Vektor der Länge n ist. Die in Abschn. 2.1.3 diskutierten geometrischen Eigenschaften solcher Gradienten sind grundlegend für das Verständnis sowohl der Optimalitätsbedingungen als auch der numerischen Verfahren in Abschn. 2.2.

Sofern f zweimal differenzierbar ist, lässt sich die obige hinreichende Bedingung für die Abstiegseigenschaft einer Richtung durch Informationen über die zweite Ableitung von f an  verfeinern, was eine stärkere notwendige Optimalitätsbedingung als die Fermat’sche Regel liefert, nämlich die in Abschn. 2.1.4 besprochene notwendige Optimalitätsbedingung zweiter Ordnung. Durch eine einfache Modifikation wird sich aus dieser Bedingung auch eine hinreichende Optimalitätsbedingung konstruieren lassen. Allerdings wird zwischen der notwendigen und der hinreichenden Optimalitätsbedingung zweiter Ordnung eine „Lücke“ klaffen. Wir diskutieren kurz, warum dies keine gravierenden Konsequenzen hat. Der abschließende Abschn. 2.1.5 reißt kurz an, wie die Optimalitätsbedingungen sich vereinfachen, wenn die Zielfunktion f zusätzlich konvex auf

verfeinern, was eine stärkere notwendige Optimalitätsbedingung als die Fermat’sche Regel liefert, nämlich die in Abschn. 2.1.4 besprochene notwendige Optimalitätsbedingung zweiter Ordnung. Durch eine einfache Modifikation wird sich aus dieser Bedingung auch eine hinreichende Optimalitätsbedingung konstruieren lassen. Allerdings wird zwischen der notwendigen und der hinreichenden Optimalitätsbedingung zweiter Ordnung eine „Lücke“ klaffen. Wir diskutieren kurz, warum dies keine gravierenden Konsequenzen hat. Der abschließende Abschn. 2.1.5 reißt kurz an, wie die Optimalitätsbedingungen sich vereinfachen, wenn die Zielfunktion f zusätzlich konvex auf  ist.

ist.

2.1.1 Abstiegsrichtungen

Um zu klären, welche notwendigen Bedingungen die Funktion f an einem Minimalpunkt erfüllen muss, geht man nach folgendem Ausschlussprinzip vor: Wenn man den Punkt  entlang einer Richtung

entlang einer Richtung  verlassen kann, während die Funktionswerte (zumindest zunächst) fallen, dann kommt

verlassen kann, während die Funktionswerte (zumindest zunächst) fallen, dann kommt  offensichtlich nicht als Minimalpunkt infrage. Die Punkte, die man beim Verlassen von

offensichtlich nicht als Minimalpunkt infrage. Die Punkte, die man beim Verlassen von  entlang d besucht, lassen sich per Punktrichtungsform einer Geraden explizit als

entlang d besucht, lassen sich per Punktrichtungsform einer Geraden explizit als  mit Skalaren t ≥ 0 adressieren.

mit Skalaren t ≥ 0 adressieren.

2.1.1 Definition (Abstiegsrichtung)

und

und  . Ein Vektor

. Ein Vektor  heißt Abstiegsrichtung

für f in

heißt Abstiegsrichtung

für f in  , falls

, falls

2.1.2 Übung

Für  sei

sei  ein lokaler Minimalpunkt. Zeigen Sie, dass dann keine Abstiegsrichtung für f in

ein lokaler Minimalpunkt. Zeigen Sie, dass dann keine Abstiegsrichtung für f in  existiert.

existiert.

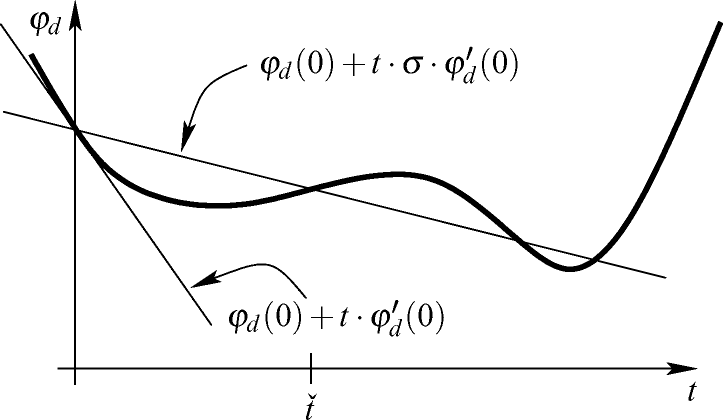

Im Folgenden werden wir die nur von der eindimensionalen Variable t abhängige Funktion  genauer untersuchen und geben ihr dazu eine eigene Bezeichnung.

genauer untersuchen und geben ihr dazu eine eigene Bezeichnung.

2.1.3 Definition (Eindimensionale Einschränkung)

, ein Punkt

, ein Punkt  und ein Richtungsvektor

und ein Richtungsvektor  . Die Funktion

. Die Funktion

in Richtung d verlaufende Gerade.

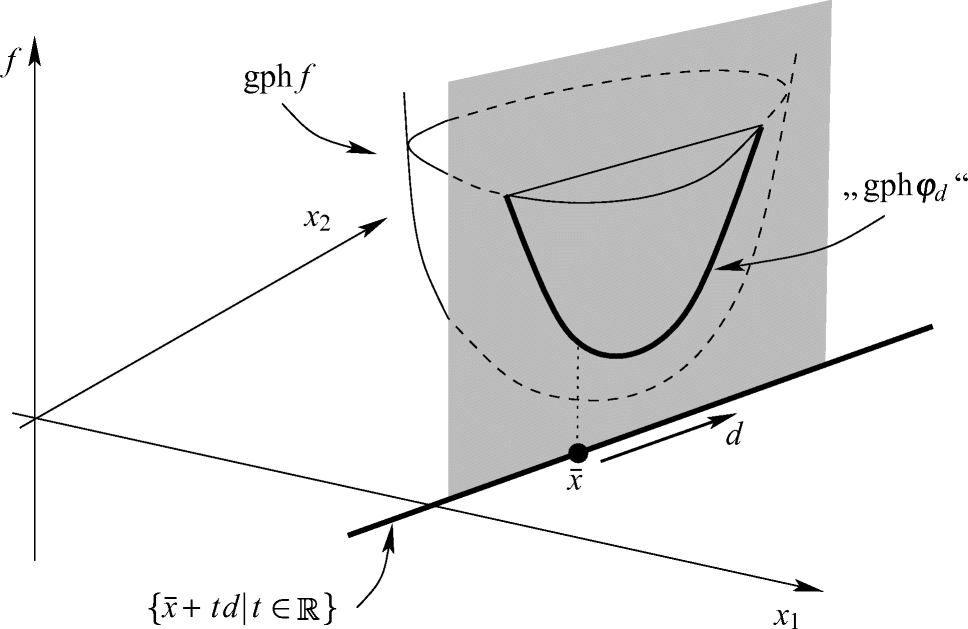

in Richtung d verlaufende Gerade. und die Richtung d definieren die Gerade

und die Richtung d definieren die Gerade  im zweidimensionalen Raum der Argumente, und φd beschreibt die Auswertung der Funktion f genau auf den Punkten dieser Geraden. Den Graphen gph φd von φd erhält man geometrisch also, indem man über der Geraden eine „senkrechte Ebene“ errichtet und diese mit dem Graphen gphf von f schneidet. Tatsächlich ist gph φd aber natürlich keine Teilmenge des

im zweidimensionalen Raum der Argumente, und φd beschreibt die Auswertung der Funktion f genau auf den Punkten dieser Geraden. Den Graphen gph φd von φd erhält man geometrisch also, indem man über der Geraden eine „senkrechte Ebene“ errichtet und diese mit dem Graphen gphf von f schneidet. Tatsächlich ist gph φd aber natürlich keine Teilmenge des  , wie es in Abb. 2.1 dargestellt ist, sondern Teilmenge des zweidimensionalen Raums, der mit der konstruierten „senkrechten Ebene“ übereinstimmt.

, wie es in Abb. 2.1 dargestellt ist, sondern Teilmenge des zweidimensionalen Raums, der mit der konstruierten „senkrechten Ebene“ übereinstimmt.

Eindimensionale Einschränkung

für jede Richtung

für jede Richtung  . Daher ist d genau dann Abstiegsrichtung für f in

. Daher ist d genau dann Abstiegsrichtung für f in  , wenn

, wenn

2.1.2 Optimalitätsbedingung erster Ordnung

Im Folgenden werden wir eine Bedingung herleiten, die an jedem lokalen Minimalpunkt von f notwendigerweise erfüllt sein muss. Da sie Informationen aus ersten Ableitungen von f benutzt, spricht man von einer notwendigen Optimalitätsbedingung erster Ordnung. Um später (in Satz 3.3.21) eine Anwendung der folgenden Grundüberlegungen auch auf gewisse nichtglatte Probleme zuzulassen, führen wir sie unter einer sehr schwachen Voraussetzung an die Funktion f ein, nämlich ihrer einseitigen Richtungsdifferenzierbarkeit.

ist. Als Verknüpfung von f mit der affin-linearen Funktion

ist. Als Verknüpfung von f mit der affin-linearen Funktion  ist dann auch die eindimensionale Einschränkung φd an

ist dann auch die eindimensionale Einschränkung φd an  differenzierbar. Ihre Ableitung

differenzierbar. Ihre Ableitung  gibt an, mit welcher Steigung die Funktionswerte von f sich ändern, wenn man

gibt an, mit welcher Steigung die Funktionswerte von f sich ändern, wenn man  in Richtung d verlässt. Diese Ableitung

in Richtung d verlässt. Diese Ableitung

in Richtung d.

in Richtung d.Es erscheint plausibel, dass im Fall  die Funktionswerte von φd bei wachsendem t zunächst fallen, dass ein solches d also eine Abstiegsrichtung ist. Da negative Werte von t für dieses Argument aber gar keine Rolle spielen, benötigt man tatsächlich nicht die Richtungsableitung von f, sondern nur das folgende Konzept.

die Funktionswerte von φd bei wachsendem t zunächst fallen, dass ein solches d also eine Abstiegsrichtung ist. Da negative Werte von t für dieses Argument aber gar keine Rolle spielen, benötigt man tatsächlich nicht die Richtungsableitung von f, sondern nur das folgende Konzept.

2.1.4 Definition (Einseitige Richtungsableitung)

heißt an

heißt an  in eine Richtung

in eine Richtung  einseitig richtungsdifferenzierbar

, wenn der Grenzwert

einseitig richtungsdifferenzierbar

, wenn der Grenzwert

heißt dann einseitige Richtungsableitung

. Die Funktion f heißt an

heißt dann einseitige Richtungsableitung

. Die Funktion f heißt an  einseitig richtungsdifferenzierbar

, wenn f an

einseitig richtungsdifferenzierbar

, wenn f an  in jede Richtung

in jede Richtung  einseitig richtungsdifferenzierbar ist, und f heißt einseitig richtungsdifferenzierbar, wenn f an jedem

einseitig richtungsdifferenzierbar ist, und f heißt einseitig richtungsdifferenzierbar, wenn f an jedem  einseitig richtungsdifferenzierbar ist.

einseitig richtungsdifferenzierbar ist. in Richtung d besagt, dass für alle Folgen

in Richtung d besagt, dass für alle Folgen  mit

mit  der Grenzwert

der Grenzwert

. Hingegen bedeutet die einseitige Richtungsdifferenzierbarkeit von f an

. Hingegen bedeutet die einseitige Richtungsdifferenzierbarkeit von f an  in Richtung d, dass nur für alle Folgen

in Richtung d, dass nur für alle Folgen  mit

mit  der Grenzwert

der Grenzwert

.

.Offensichtlich ist jede an  in Richtung d richtungsdifferenzierbare Funktion f an

in Richtung d richtungsdifferenzierbare Funktion f an  in Richtung d auch einseitig richtungsdifferenzierbar mit

in Richtung d auch einseitig richtungsdifferenzierbar mit  . Damit ist insbesondere jede an

. Damit ist insbesondere jede an  differenzierbare Funktion f dort auch einseitig richtungsdifferenzierbar. Allerdings umfasst die Klasse der einseitig richtungsdifferenzierbaren Funktionen auch sehr viele nichtdifferenzierbare Funktionen, etwa alle auf

differenzierbare Funktion f dort auch einseitig richtungsdifferenzierbar. Allerdings umfasst die Klasse der einseitig richtungsdifferenzierbaren Funktionen auch sehr viele nichtdifferenzierbare Funktionen, etwa alle auf  konvexen Funktionen (Abschn. 2.1.5 und [34]) sowie Maxima endlich vieler glatter Funktionen (Übung 2.1.12). Als einfaches Beispiel ist

konvexen Funktionen (Abschn. 2.1.5 und [34]) sowie Maxima endlich vieler glatter Funktionen (Übung 2.1.12). Als einfaches Beispiel ist  an

an  weder differenzierbar noch richtungsdifferenzierbar, aber einseitig richtungsdifferenzierbar.

weder differenzierbar noch richtungsdifferenzierbar, aber einseitig richtungsdifferenzierbar.

2.1.5 Lemma

Die Funktion { sei an

sei an  in Richtung

in Richtung  einseitig richtungsdifferenzierbar mit

einseitig richtungsdifferenzierbar mit  . Dann ist d Abstiegsrichtung für f in

. Dann ist d Abstiegsrichtung für f in  .

.

Beweis.

. Dann existiert kein

. Dann existiert kein  , so dass für alle

, so dass für alle  die Ungleichung

die Ungleichung  erfüllt ist. Insbesondere erfüllt für jedes

erfüllt ist. Insbesondere erfüllt für jedes  mindestens ein tk ∈ (0, 1/k) die Ungleichung

mindestens ein tk ∈ (0, 1/k) die Ungleichung  . Für jedes

. Für jedes  gilt dann wegen tk > 0 auch

gilt dann wegen tk > 0 auch

in Richtung d liefert

in Richtung d liefert

. Demnach ist die Annahme falsch und die Behauptung bewiesen.

. Demnach ist die Annahme falsch und die Behauptung bewiesen.Aus Übung 2.1.2 und Lemma 2.1.5 folgt sofort das nächste Resultat.

2.1.6 Lemma

Die Funktion  sei an einem lokalen Minimalpunkt

sei an einem lokalen Minimalpunkt  einseitig richtungsdifferenzierbar. Dann gilt

einseitig richtungsdifferenzierbar. Dann gilt  für jede Richtung

für jede Richtung  .

.

Lemma 2.1.5 und 2.1.6 motivieren die folgende Definitionen.

2.1.7 Definition (Abstiegsrichtung erster Ordnung)

Für eine am Punkt  in Richtung

in Richtung  einseitig richtungsdifferenzierbare Funktion

einseitig richtungsdifferenzierbare Funktion  heißt d Abstiegsrichtung erster Ordnung

, falls

heißt d Abstiegsrichtung erster Ordnung

, falls  gilt.

gilt.

2.1.8 Definition (Stationärer Punkt – unrestringierter Fall)

Die Funktion  sei an

sei an  einseitig richtungsdifferenzierbar. Dann heißt

einseitig richtungsdifferenzierbar. Dann heißt  stationärer Punkt von f, falls

stationärer Punkt von f, falls  für jede Richtung

für jede Richtung  gilt.

gilt.

In dieser Terminologie besagt Lemma 2.1.5, dass jede Abstiegsrichtung erster Ordnung tatsächlich eine Abstiegsrichtung im Sinne von Definition 2.1.1 ist. Die Definition der Stationarität eines Punkts aus Definition 2.1.8 lautet gerade, dass an ihm keine Abstiegsrichtung erster Ordnung existieren darf, und Lemma 2.1.6 sagt aus, dass jeder lokale Minimalpunkt einer dort einseitig richtungsdifferenzierbaren Funktion auch stationär ist.

und kehren daher wieder zu einer in

und kehren daher wieder zu einer in  differenzierbaren Funktion f zurück. Wir betrachten als Richtungsvektor zunächst speziell den i-ten Einheitsvektor d = ei (setzen also di = 1 und dj = 0 für alle j ≠ i). Dann ist

differenzierbaren Funktion f zurück. Wir betrachten als Richtungsvektor zunächst speziell den i-ten Einheitsvektor d = ei (setzen also di = 1 und dj = 0 für alle j ≠ i). Dann ist  die partielle Ableitung

von f bezüglich der Variable xi , die man alternativ auch mit

die partielle Ableitung

von f bezüglich der Variable xi , die man alternativ auch mit  bezeichnet. Als erste Ableitung

einer partiell differenzierbaren Funktion

bezeichnet. Als erste Ableitung

einer partiell differenzierbaren Funktion  an

an  betrachtet man den Zeilenvektor

betrachtet man den Zeilenvektor

. Der Spaltenvektor

. Der Spaltenvektor  wird als Gradient

von f an

wird als Gradient

von f an  bezeichnet. Im Hinblick auf spätere Konstruktionen halten wir fest, dass der Gradient

bezeichnet. Im Hinblick auf spätere Konstruktionen halten wir fest, dass der Gradient  zwar einerseits nur eine Liste von partiellen Ableitungsinformationen ist, andererseits aber genau wie

zwar einerseits nur eine Liste von partiellen Ableitungsinformationen ist, andererseits aber genau wie  als ein n-dimensionaler Vektor interpretiert werden darf.

als ein n-dimensionaler Vektor interpretiert werden darf. mit partiell differenzierbaren Komponenten

mit partiell differenzierbaren Komponenten  definiert man die erste Ableitung als

definiert man die erste Ableitung als

. Gelegentlich werden wir auch für vektorwertige Funktionen f die Notation

. Gelegentlich werden wir auch für vektorwertige Funktionen f die Notation  benutzen.

benutzen.Eine wichtige Rechenregel für differenzierbare Funktionen ist die Kettenregel, deren Beweis man z. B. in [18] findet.

2.1.9 Satz (Kettenregel)

differenzierbar an

differenzierbar an  und

und  differenzierbar an

differenzierbar an  . Dann ist

. Dann ist  differenzierbar an

differenzierbar an  mit

mit

Ein wesentlicher Grund dafür, die Jacobi-Matrix einer Funktion wie oben zu definieren, besteht darin, dass die Kettenregel dann völlig analog zum eindimensionalen Fall ( ) formuliert werden kann, obwohl das auftretende Produkt ein Matrixprodukt ist.

) formuliert werden kann, obwohl das auftretende Produkt ein Matrixprodukt ist.

gilt k = m = 1 und

gilt k = m = 1 und  . Als Jacobi-Matrix von g erhält man

. Als Jacobi-Matrix von g erhält man

mit dem Spaltenvektor d.

mit dem Spaltenvektor d. nennt man den so definierten Term

nennt man den so definierten Term

2.1.10 Lemma

Die Funktion  sei am Punkt

sei am Punkt  differenzierbar, und für die Richtung

differenzierbar, und für die Richtung  gelte

gelte  . Dann ist d Abstiegsrichtung für f in

. Dann ist d Abstiegsrichtung für f in  .

.

Für eine an  differenzierbare Funktion f ist d offensichtlich genau dann Abstiegsrichtung erster Ordnung im Sinne von Definition 2.1.7, wenn

differenzierbare Funktion f ist d offensichtlich genau dann Abstiegsrichtung erster Ordnung im Sinne von Definition 2.1.7, wenn  gilt.

gilt.

2.1.11 Bemerkung

geometrisch zu interpretieren ist. Für zwei Vektoren

geometrisch zu interpretieren ist. Für zwei Vektoren  besitzt das Skalarprodukt

besitzt das Skalarprodukt  neben der algebraischen Definition zu

neben der algebraischen Definition zu  nämlich auch die Darstellung

nämlich auch die Darstellung

den Winkel zwischen den beiden Vektoren a und b. Dieser lässt sich für n-dimensionale Vektoren a und b definieren, indem man ihn in der Ebene misst, die von a und b aufgespannt wird (also in der Menge

den Winkel zwischen den beiden Vektoren a und b. Dieser lässt sich für n-dimensionale Vektoren a und b definieren, indem man ihn in der Ebene misst, die von a und b aufgespannt wird (also in der Menge  ). Im Ausnahmefall, in dem die Vektoren a und b linear abhängig sind, spannen sie zwar keine Ebene auf, aber der Winkel zwischen a und b kann dann nur null (falls sie in die gleiche Richtung zeigen) oder π (falls sie in entgegengesetzte Richtungen zeigen) betragen. In diesen Fällen gilt

). Im Ausnahmefall, in dem die Vektoren a und b linear abhängig sind, spannen sie zwar keine Ebene auf, aber der Winkel zwischen a und b kann dann nur null (falls sie in die gleiche Richtung zeigen) oder π (falls sie in entgegengesetzte Richtungen zeigen) betragen. In diesen Fällen gilt  bzw.

bzw.  .

.Aus der Darstellung (2.1) erhalten wir die Bedingung  also genau dann, wenn

also genau dann, wenn  gilt, d. h. genau für

gilt, d. h. genau für  . Mit anderen Worten ist das Skalarprodukt der Vektoren a und b genau dann negativ, wenn sie einen stumpfen Winkel miteinander bilden. Analog ist das Skalarprodukt genau für einen spitzen Winkel bildende Vektoren positiv sowie genau für senkrecht zueinander stehende Vektoren null.

. Mit anderen Worten ist das Skalarprodukt der Vektoren a und b genau dann negativ, wenn sie einen stumpfen Winkel miteinander bilden. Analog ist das Skalarprodukt genau für einen spitzen Winkel bildende Vektoren positiv sowie genau für senkrecht zueinander stehende Vektoren null.

Insbesondere ist d genau dann eine Abstiegsrichtung erster Ordnung für f in  , wenn d einen stumpfen Winkel mit dem Gradienten

, wenn d einen stumpfen Winkel mit dem Gradienten  bildet. Wir werden später sehen, dass unter gewissen Zusatzvoraussetzungen auch Richtungen d Abstiegsrichtungen sein können, die senkrecht zum Vektor

bildet. Wir werden später sehen, dass unter gewissen Zusatzvoraussetzungen auch Richtungen d Abstiegsrichtungen sein können, die senkrecht zum Vektor  stehen.

stehen.

Auch für nur einseitig richtungsdifferenzierbare Funktionen lassen sich manchmal einfache Formeln für die einseitige Richtungsableitung angeben.

2.1.12 Übung

, eine endliche Indexmenge K und an

, eine endliche Indexmenge K und an  differenzierbare Funktionen

differenzierbare Funktionen  , k ∈ K. Zeigen Sie, dass dann die Funktion

, k ∈ K. Zeigen Sie, dass dann die Funktion  an

an  einseitig richtungsdifferenzierbar ist und dass mit

einseitig richtungsdifferenzierbar ist und dass mit

gilt.

gilt.Wir können nun die zentrale Optimalitätsbedingung für unrestringierte glatte Optimierungsprobleme beweisen.

2.1.13 Satz (Notwendige Optimalitätsbedingung erster Ordnung – Fermat’sche Regel)

Die Funktion  sei differenzierbar an einem lokalen Minimalpunkt

sei differenzierbar an einem lokalen Minimalpunkt  . Dann gilt

. Dann gilt  .

.

Beweis.

ein stationärer Punkt von f. Aufgrund der Darstellung der Richtungsableitung per Kettenregel gilt für jede Richtung

ein stationärer Punkt von f. Aufgrund der Darstellung der Richtungsableitung per Kettenregel gilt für jede Richtung  also

also

, also

, also

und (wegen der Definitheit der Norm)

und (wegen der Definitheit der Norm)  .

.Die Fermat’sche Regel wird als Optimalitätsbedingung erster Ordnung bezeichnet, da sie von ersten Ableitungen der Funktion f Gebrauch macht. Sie motiviert die folgende Definition.

2.1.14 Definition (Kritischer Punkt)

Die Funktion  sei an

sei an  differenzierbar. Dann heißt

differenzierbar. Dann heißt  kritischer Punkt

von f, wenn

kritischer Punkt

von f, wenn  gilt.

gilt.

In dieser Terminologie ist nach der Fermat’schen Regel jeder lokale Minimalpunkt einer differenzierbaren Funktion notwendigerweise kritischer Punkt.

2.1.15 Übung

Die Funktion  sei differenzierbar an einem Punkt

sei differenzierbar an einem Punkt  . Zeigen Sie, dass

. Zeigen Sie, dass  genau dann stationärer Punkt von f ist, wenn er kritischer Punkt von f ist.

genau dann stationärer Punkt von f ist, wenn er kritischer Punkt von f ist.

Übung 2.1.15 begründet, weshalb in der Literatur zur glatten unrestringierten Optimierung die Begriffe des stationären und des kritischen Punkts synonym gebraucht werden. Für nichtglatte oder restringierte glatte Probleme ist der Zusammenhang zwischen der durch das Fehlen einer Abstiegsrichtung erster Ordnung definierten Stationarität und einer algebraischen Optimalitätsbedingung (analog zur Kritikalität  ) allerdings weniger übersichtlich ([34] und Kap. 3). Die Begriffe der Stationarität und der Kritikalität werden in der Literatur aber nicht einheitlich gebraucht.

) allerdings weniger übersichtlich ([34] und Kap. 3). Die Begriffe der Stationarität und der Kritikalität werden in der Literatur aber nicht einheitlich gebraucht.

2.1.16 Beispiel

von

von  rechnet man sofort

rechnet man sofort  nach. Für die beiden Funktionen

nach. Für die beiden Funktionen  und

und  ist

ist  allerdings ebenfalls kritischer Punkt, obwohl

allerdings ebenfalls kritischer Punkt, obwohl  kein lokaler Minimalpunkt ist. In der Tat liefert beispielsweise die Richtung

kein lokaler Minimalpunkt ist. In der Tat liefert beispielsweise die Richtung  für die eindimensionale Einschränkung beider Funktionen

für die eindimensionale Einschränkung beider Funktionen

in diese Richtung verlassen kann, während die Funktionswerte fallen (damit ist d zwar Abstiegsrichtung, aber nicht Abstiegsrichtung erster Ordnung). Für f2 ist dies sogar in jeder beliebigen Richtung der Fall, da f2 an

in diese Richtung verlassen kann, während die Funktionswerte fallen (damit ist d zwar Abstiegsrichtung, aber nicht Abstiegsrichtung erster Ordnung). Für f2 ist dies sogar in jeder beliebigen Richtung der Fall, da f2 an  offensichtlich einen Maximalpunkt besitzt. Bei f3 wachsen hingegen in Richtung

offensichtlich einen Maximalpunkt besitzt. Bei f3 wachsen hingegen in Richtung  die Funktionswerte an. In diesem Fall spricht man von einem Sattelpunkt von f3.

die Funktionswerte an. In diesem Fall spricht man von einem Sattelpunkt von f3.2.1.17 Definition (Sattelpunkt)

Die Funktion  sei an

sei an  differenzierbar. Dann heißt

differenzierbar. Dann heißt  Sattelpunkt

von f, falls

Sattelpunkt

von f, falls  zwar kritischer Punkt von f, aber weder lokaler Minimal- noch lokaler Maximalpunkt ist.

zwar kritischer Punkt von f, aber weder lokaler Minimal- noch lokaler Maximalpunkt ist.

Beispiel 2.1.16 illustriert, dass die Fermat’sche Regel nur eine notwendige Optima- litätsbedingung ist. Sie besagt zwar, dass ein lokaler Minimalpunkt von f notwendigerweise kritischer Punkt ist, aber die Eigenschaft, ein kritischer Punkt zu sein, ist nicht hinreichend für Minimalität.

Damit ist klar, dass kritische Punkte lediglich Kandidaten für Minimalpunkte von f sind, aber auch beispielsweise Maximal- oder Sattelpunkten entsprechen können. Algorithmus 2.1 beschreibt ein auf dieser Beobachtung basierendes konzeptionelles Verfahren zur Minimierung mit Hilfe kritischer Punkte. Es nutzt die notwendige Optimalitätsbedingung, um unter allen zulässigen Punkten (also allen Punkten in  ) diejenigen „auszusieben“, die nicht als Kandidaten für Minimalpunkte infrage kommen. „Nur“ unter den restlichen Punkten muss dann noch ein Minimalpunkt gesucht werden.

) diejenigen „auszusieben“, die nicht als Kandidaten für Minimalpunkte infrage kommen. „Nur“ unter den restlichen Punkten muss dann noch ein Minimalpunkt gesucht werden.

Hier und im Folgenden nennen wir ein Optimierungsproblem P differenzierbar, wenn es durch differenzierbare Funktionen beschrieben wird. Im vorliegenden unrestringierten Fall betrifft dies natürlich nur die Differenzierbarkeit der Zielfunktion f.

Algorithmus 2.1: Konzeptioneller Algorithmus zur unrestringierten nichtlinearen Minimierung mit Informationen erster Ordnung

Input : Lösbares unrestringiertes differenzierbares Optimierungsproblem P

Output : Globaler Minimalpunkt  von f über

von f über

1 begin

2 Bestimme alle kritischen Punkte von f, d. h. die Lösungsmenge K der Gleichung  .

.

3 Bestimme einen Minimalpunkt  von f in K.

von f in K.

4 end

Algorithmus 2.1 besitzt drei Nachteile, die seine Anwendung auf praktische Probleme behindern. Zunächst muss die Lösbarkeit des Problems P a priori bekannt sein, etwa durch Anwendung der Kriterien aus Abschn. 1.2. Beispielsweise besitzt die Funktion  genau die beiden kritischen Punkte x1 = −1 und x2 = 1, wobei x2 den kleineren Funktionswert besitzt und damit den Output von Algorithmus 2.1 bildet. Allerdings ist f auf

genau die beiden kritischen Punkte x1 = −1 und x2 = 1, wobei x2 den kleineren Funktionswert besitzt und damit den Output von Algorithmus 2.1 bildet. Allerdings ist f auf  nicht nach unten beschränkt und besitzt damit keinen globalen Minimalpunkt. Diese Unlösbarkeit kann von Algorithmus 2.1 nicht identifiziert werden.

nicht nach unten beschränkt und besitzt damit keinen globalen Minimalpunkt. Diese Unlösbarkeit kann von Algorithmus 2.1 nicht identifiziert werden.

Der zweite Nachteil von Algorithmus 2.1 besteht darin, dass er alle kritischen Punkte bestimmen muss. Bei einer nichtlinearen Kritische-Punkt-Gleichung ∇f(x) = 0 ist aber selten klar, wie alle Lösungen bestimmt werden können. Falls kritische Punkte übersehen werden, besteht die Gefahr, dass der Output von Algorithmus 2.1 kein globaler Minimalpunkt ist.

Als dritter Nachteil ist anzuführen, dass bei komplizierten Funktionen f schon die Berechnung eines einzigen kritischen Punkts sehr aufwendig sein kann.

Algorithmus 2.1 lässt sich demnach immerhin auf lösbare Optimierungsprobleme anwenden, deren kritische Punkte etwa durch Fallunterscheidung komplett und außerdem explizit berechenbar sind. Dies trifft leider oft nur auf niedrigdimensionale Probleme mit „übersichtlicher“ Zielfunktion zu.

2.1.18 Übung

, 1 ≤ j ≤ m. Warum ist nicht garantiert, dass sich die Fermat’sche Regel auf jeden lokalen Minimalpunkt dieses Problems anwenden lässt?

, 1 ≤ j ≤ m. Warum ist nicht garantiert, dass sich die Fermat’sche Regel auf jeden lokalen Minimalpunkt dieses Problems anwenden lässt?

2.1.3 Geometrische Eigenschaften von Gradienten

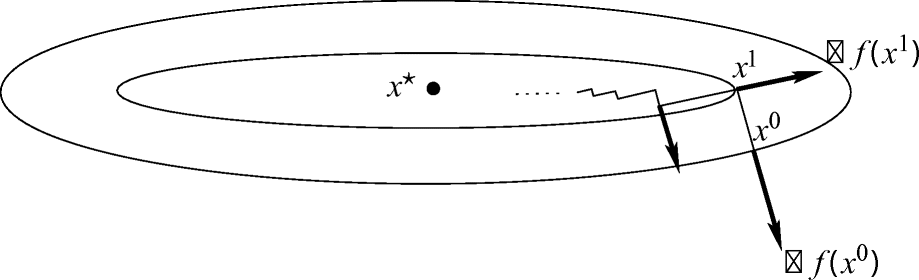

vollständig zu verstehen, bringen wir ihn mit der unteren Niveaumenge

vollständig zu verstehen, bringen wir ihn mit der unteren Niveaumenge

gilt und im Vergleich zu

gilt und im Vergleich zu  „bessere“ Punkte x gerade solche sind, die die strikte Ungleichung

„bessere“ Punkte x gerade solche sind, die die strikte Ungleichung  erfüllen. Eine Abstiegsrichtung d für f in

erfüllen. Eine Abstiegsrichtung d für f in  sollte also in das „Innere“ von

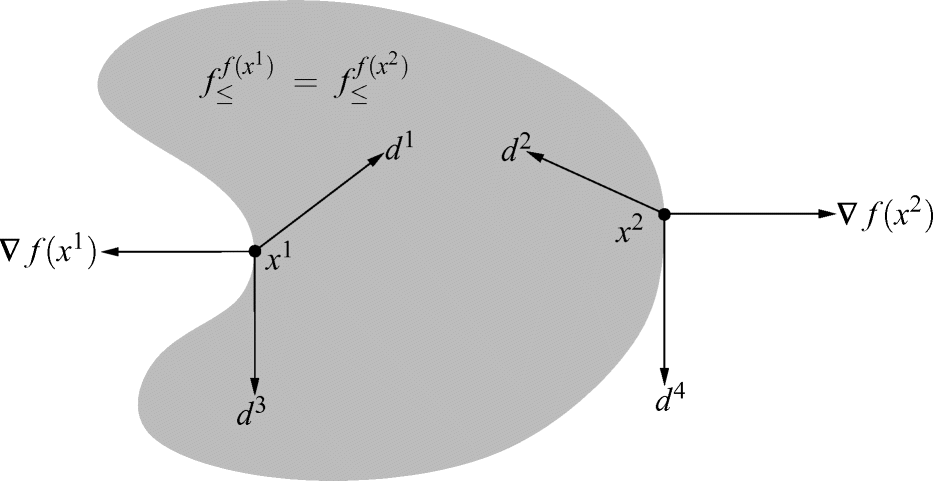

sollte also in das „Innere“ von  zeigen. Abb. 2.2 illustriert, wie eine solche Menge für eine nichtlineare Funktion f aussehen kann, wobei zwei verschiedene Punkte x1 und x2 so gewählt sind, dass

zeigen. Abb. 2.2 illustriert, wie eine solche Menge für eine nichtlineare Funktion f aussehen kann, wobei zwei verschiedene Punkte x1 und x2 so gewählt sind, dass  gilt.

gilt.

Gradienten und Abstiegsrichtungen

mit

mit  eine Anstiegsrichtung erster Ordnung

ist. Da für einen nichtkritischen Punkt

eine Anstiegsrichtung erster Ordnung

ist. Da für einen nichtkritischen Punkt  die Gradientenrichtung

die Gradientenrichtung  die strikte Ungleichung

die strikte Ungleichung

also eine Anstiegsrichtung erster Ordnung für f in

also eine Anstiegsrichtung erster Ordnung für f in  und zeigt damit sicherlich aus

und zeigt damit sicherlich aus  heraus.

heraus.In der Tat lässt sich sogar zeigen, dass  senkrecht auf dem Rand von

senkrecht auf dem Rand von  steht. Um dies korrekt zu begründen, muss man einen Tangentialkegel an die Menge

steht. Um dies korrekt zu begründen, muss man einen Tangentialkegel an die Menge  im Punkt

im Punkt  definieren, was wir auf Abschn. 3.1.2 verschieben, in dem Tangentialkegel an allgemeine Mengen eingeführt werden (Übung 3.2.9).

definieren, was wir auf Abschn. 3.1.2 verschieben, in dem Tangentialkegel an allgemeine Mengen eingeführt werden (Übung 3.2.9).

linearisierte Menge

linearisierte Menge  , etwas mit der Linearisierung der Ungleichung zu tun hat, durch die die Menge definiert ist. In der Tat liegt für t > 0 und eine Richtung

, etwas mit der Linearisierung der Ungleichung zu tun hat, durch die die Menge definiert ist. In der Tat liegt für t > 0 und eine Richtung  der Punkt

der Punkt  in

in  , falls

, falls  gilt. Mit der eindimensionalen Einschränkung lässt sich dies auch als

gilt. Mit der eindimensionalen Einschränkung lässt sich dies auch als  schreiben. Eine Linearisierung dieser Ungleichung um

schreiben. Eine Linearisierung dieser Ungleichung um  , also die Taylor-Entwicklung erster Ordnung (s. auch Satz 2.1.19a) mit unterschlagenem Restglied, führt auf

, also die Taylor-Entwicklung erster Ordnung (s. auch Satz 2.1.19a) mit unterschlagenem Restglied, führt auf

folgt. Mit den Ergebnissen aus Abschn. 3.2.2 werden wir in Übung 3.2.9 tatsächlich zeigen können, dass an einem nichtkritischen Punkt

folgt. Mit den Ergebnissen aus Abschn. 3.2.2 werden wir in Übung 3.2.9 tatsächlich zeigen können, dass an einem nichtkritischen Punkt  der Tangentialkegel an die Menge

der Tangentialkegel an die Menge  im Punkt

im Punkt  durch

durch

, steht also senkrecht auf dem Gradienten

, steht also senkrecht auf dem Gradienten  . Folglich zeigt

. Folglich zeigt  nicht nur aus

nicht nur aus  heraus, sondern steht auch senkrecht zum Rand dieser Menge (bzw. ihres Tangentialkegels).

heraus, sondern steht auch senkrecht zum Rand dieser Menge (bzw. ihres Tangentialkegels).Abb. 2.2 illustriert dies für die Punkte x1 und x2. Da d1 und d2 stumpfe Winkel mit ∇f(x1) bzw. ∇f(x2) bilden, sind sie Abstiegsrichtungen erster Ordnung für f in x1 bzw. x2. Offensichtlich gerät man entlang dieser Richtungen auch (zunächst) ins Innere der Menge  . Der Vektor d3 steht senkrecht auf ∇f(x1), ist also keine Abstiegsrichtung erster Ordnung. Dass er dennoch als Abstiegsrichtung fungiert, ist der „nichtkonvexen Krümmung“ des Rands dieser Menge um x1 zu verdanken. Andererseits steht der Vektor d4 zwar ebenfalls senkrecht auf ∇f(x2), kommt als Abstiegsrichtung aber offensichtlich nicht infrage. Mit diesen beiden Effekten werden wir uns in Abschn. 2.1.4 genauer befassen.

. Der Vektor d3 steht senkrecht auf ∇f(x1), ist also keine Abstiegsrichtung erster Ordnung. Dass er dennoch als Abstiegsrichtung fungiert, ist der „nichtkonvexen Krümmung“ des Rands dieser Menge um x1 zu verdanken. Andererseits steht der Vektor d4 zwar ebenfalls senkrecht auf ∇f(x2), kommt als Abstiegsrichtung aber offensichtlich nicht infrage. Mit diesen beiden Effekten werden wir uns in Abschn. 2.1.4 genauer befassen.

Während wir bislang nur das Vorzeichen der Richtungsableitung  betrachtet haben, untersuchen wir abschließend noch, wie man den tatsächlichen An- oder Abstieg der Funktionswerte von

betrachtet haben, untersuchen wir abschließend noch, wie man den tatsächlichen An- oder Abstieg der Funktionswerte von  aus in Richtung d quantifizieren kann. Das Problem hierbei ist, dass zu jedem Vektor d ≠ 0 auch etwa der Vektor 2d in dieselbe Richtung zeigt, sich beim Austausch von d gegen 2d aber der Wert der Richtungsableitung verdoppelt. Um einen eindeutigen Wert der Richtungsableitung zu erhalten, liegt es nahe, nur solche Richtungen d zu betrachten, die die Länge eins besitzen, also

aus in Richtung d quantifizieren kann. Das Problem hierbei ist, dass zu jedem Vektor d ≠ 0 auch etwa der Vektor 2d in dieselbe Richtung zeigt, sich beim Austausch von d gegen 2d aber der Wert der Richtungsableitung verdoppelt. Um einen eindeutigen Wert der Richtungsableitung zu erhalten, liegt es nahe, nur solche Richtungen d zu betrachten, die die Länge eins besitzen, also  erfüllen. Dies entspricht der natürlichen Forderung, dass ein Schritt der Länge t von

erfüllen. Dies entspricht der natürlichen Forderung, dass ein Schritt der Länge t von  in Richtung d zu einem Punkt

in Richtung d zu einem Punkt  führt, der tatsächlich den Abstand t von

führt, der tatsächlich den Abstand t von  besitzt (denn mit

besitzt (denn mit  gilt

gilt  ).

).

angenommen. Wegen

angenommen. Wegen  wird die kleinstmögliche Steigung

wird die kleinstmögliche Steigung  daher mit

daher mit

mit

mit

des Gradienten genau dem größtmöglichen Anstieg der Funktion f von

des Gradienten genau dem größtmöglichen Anstieg der Funktion f von  aus, und die Richtung des Gradienten zeigt in die zugehörige Richtung des steilsten Anstiegs.

aus, und die Richtung des Gradienten zeigt in die zugehörige Richtung des steilsten Anstiegs.Analog zeigt  in die Richtung des steilsten Abstiegs von f in

in die Richtung des steilsten Abstiegs von f in  . Dies wird in Abschn. 2.2 auf ein grundlegendes numerisches Verfahren führen. In der Tat arbeitet man numerisch allerdings nicht mit normierten Richtungsvektoren, da beispielsweise die Länge

. Dies wird in Abschn. 2.2 auf ein grundlegendes numerisches Verfahren führen. In der Tat arbeitet man numerisch allerdings nicht mit normierten Richtungsvektoren, da beispielsweise die Länge  der negativen Gradientenrichtung gerade in der Nähe der gesuchten kritischen Punkte nahe bei null liegt, und die Division

der negativen Gradientenrichtung gerade in der Nähe der gesuchten kritischen Punkte nahe bei null liegt, und die Division  dann numerisch instabil wäre.

dann numerisch instabil wäre.

2.1.4 Optimalitätsbedingungen zweiter Ordnung

Zur Herleitung der Fermat’schen Regel haben wir in Abschn. 2.1.2 ausgenutzt, dass an lokalen Minimalpunkten keine Abstiegsrichtungen erster Ordnung existieren können. Übung 2.1.2 schließt in lokalen Minimalpunkten allerdings jegliche Abstiegsrichtungen aus, und in Beispiel 2.1.16 sowie mit der Richtung d3 in Abb. 2.2 haben wir gesehen, dass es noch andere als Abstiegsrichtungen erster Ordnung gibt. Die im aktuellen Abschnitt hergeleiteten Optimalitätsbedingungen zweiter Ordnung basieren auf dem Konzept der Abstiegsrichtungen zweiter Ordnung.

Um es einzuführen, setzen wir f im Folgenden als mindestens zweimal differenzierbar am betrachteten Punkt  voraus. Dann ist auch die eindimensionale Einschränkung φd an

voraus. Dann ist auch die eindimensionale Einschränkung φd an  zweimal differenzierbar. Ihre zweite Ableitung

zweimal differenzierbar. Ihre zweite Ableitung  ist ein Maß für die Krümmung von φd in

ist ein Maß für die Krümmung von φd in  . Aus Abschn. 2.1.2 ist bekannt, dass φd im Fall

. Aus Abschn. 2.1.2 ist bekannt, dass φd im Fall  von

von  aus für wachsende Werte von t zunächst fällt und analog dass φd im Fall

aus für wachsende Werte von t zunächst fällt und analog dass φd im Fall  von

von  aus für wachsende Werte von t zunächst steigt. Im Grenzfall

aus für wachsende Werte von t zunächst steigt. Im Grenzfall  erscheint es plausibel, dass für

erscheint es plausibel, dass für  die Funktionswerte von φd bei wachsendem t zunächst fallen, dass ein solches d also eine Abstiegsrichtung ist. Um auch dies tatsächlich nachzuweisen, benötigen wir den aus der Analysis bekannten und beispielsweise in [16, 17, 28] bewiesenen Satz von Taylor in folgender Form, wobei der Begriff univariat

sich darauf bezieht, dass die betrachtete Funktion von einer nur eindimensionalen Variable abhängt.

die Funktionswerte von φd bei wachsendem t zunächst fallen, dass ein solches d also eine Abstiegsrichtung ist. Um auch dies tatsächlich nachzuweisen, benötigen wir den aus der Analysis bekannten und beispielsweise in [16, 17, 28] bewiesenen Satz von Taylor in folgender Form, wobei der Begriff univariat

sich darauf bezieht, dass die betrachtete Funktion von einer nur eindimensionalen Variable abhängt.

2.1.19 Satz (Entwicklungen erster und zweiter Ordnung per univariatem Satz von Taylor)

- a)Es sei

differenzierbar an

differenzierbar an  . Dann gilt für alle

. Dann gilt für alle  wobei

wobei

einen Ausdruck der Form

einen Ausdruck der Form  mit

mit  bezeichnet.

bezeichnet. - b)Es sei

zweimal differenzierbar an

zweimal differenzierbar an  . Dann gilt für alle

. Dann gilt für alle  wobei

wobei

einen Ausdruck der Form

einen Ausdruck der Form  mit

mit  bezeichnet.

bezeichnet.

2.1.20 Lemma

Für  , einen Punkt

, einen Punkt  und eine Richtung

und eine Richtung  seien

seien  und

und  . Dann ist d Abstiegsrichtung für f in

. Dann ist d Abstiegsrichtung für f in  .

.

Beweis.

wieder ein tk ∈ (0, 1/k) mit

wieder ein tk ∈ (0, 1/k) mit

liefert außerdem für jedes

liefert außerdem für jedes

und tk ≠ 0 erhalten wir insgesamt für jedes

und tk ≠ 0 erhalten wir insgesamt für jedes

. Im Grenzübergang gilt also

. Im Grenzübergang gilt also

steht. Demnach ist d Abstiegsrichtung.

steht. Demnach ist d Abstiegsrichtung.2.1.21 Lemma

Für  sei

sei  ein lokaler Minimalpunkt. Dann gilt

ein lokaler Minimalpunkt. Dann gilt  , und jede Richtung

, und jede Richtung  erfüllt

erfüllt  .

.

Beweis.

Zunächst liefert Satz 2.1.13, dass  gilt und damit insbesondere auch

gilt und damit insbesondere auch  . Aus Übung 2.1.2 und Lemma 2.1.20 folgt daher die Behauptung.

. Aus Übung 2.1.2 und Lemma 2.1.20 folgt daher die Behauptung.

, also für die Ableitung der bereits per Kettenregel berechneten ersten Ableitung

, also für die Ableitung der bereits per Kettenregel berechneten ersten Ableitung

. Aus nochmaliger Anwendung der Kettenregel folgt

. Aus nochmaliger Anwendung der Kettenregel folgt

treten jedenfalls partielle zweite Ableitungen von f auf. Um eine übersichtlichere Formel für

treten jedenfalls partielle zweite Ableitungen von f auf. Um eine übersichtlichere Formel für  zu finden, führen wir eine „n-dimensionale zweite Ableitung“

von f ein. Eine naheliegende Möglichkeit dafür ist es, die erste Ableitung der ersten Ableitung zu bilden, also die Jacobi-Matrix des Gradienten von f: Die (n, n)-Matrix

zu finden, führen wir eine „n-dimensionale zweite Ableitung“

von f ein. Eine naheliegende Möglichkeit dafür ist es, die erste Ableitung der ersten Ableitung zu bilden, also die Jacobi-Matrix des Gradienten von f: Die (n, n)-Matrix

. Als zweite Ableitung sind in ihr Krümmungsinformationen von f an

. Als zweite Ableitung sind in ihr Krümmungsinformationen von f an  codiert.

codiert. gerade

gerade

vorliegt. Damit können wir Lemma 2.1.20 umformulieren.

vorliegt. Damit können wir Lemma 2.1.20 umformulieren.2.1.22 Lemma

Für  , einen Punkt

, einen Punkt  und eine Richtung

und eine Richtung  seien

seien  und

und  . Dann ist d Abstiegsrichtung für f in

. Dann ist d Abstiegsrichtung für f in  .

.

Dies motiviert die folgende Definition.

2.1.23 Definition (Abstiegsrichtung zweiter Ordnung)

Zu  und

und  heißt jeder Richtungsvektor

heißt jeder Richtungsvektor  mit

mit  und

und  Abstiegsrichtung zweiter Ordnung

für f in

Abstiegsrichtung zweiter Ordnung

für f in  .

.

2.1.24 Beispiel

,

,  und

und  aus Beispiel 2.1.16 besitzen an

aus Beispiel 2.1.16 besitzen an  den Gradienten

den Gradienten  und die Hesse-Matrizen

und die Hesse-Matrizen

folgt

folgt

ist.

ist.2.1.25 Beispiel

In Beispiel 2.1.24 ist die Bedingung  aus Definition 2.1.23 erfüllt, weil schon

aus Definition 2.1.23 erfüllt, weil schon  gilt. Es gibt aber auch Abstiegsrichtungen zweiter Ordnung im Fall

gilt. Es gibt aber auch Abstiegsrichtungen zweiter Ordnung im Fall  , nämlich solche, die orthogonal zu

, nämlich solche, die orthogonal zu  stehen. Dies veranschaulicht etwa die Richtung d3 in Abb. 2.2. Die dortige Richtung d4 verdeutlicht andererseits, dass die bloße Orthogonalität natürlich nicht ausreicht. Die „nichtkonvexe Krümmung“ des Rands der Menge

stehen. Dies veranschaulicht etwa die Richtung d3 in Abb. 2.2. Die dortige Richtung d4 verdeutlicht andererseits, dass die bloße Orthogonalität natürlich nicht ausreicht. Die „nichtkonvexe Krümmung“ des Rands der Menge  an x1 entspricht gerade der Bedingung

an x1 entspricht gerade der Bedingung  , die d3 laut Definition 2.1.23 zu einer Abstiegsrichtung zweiter Ordnung macht. Dieser Zusammenhang wird noch klarer werden, wenn wir diese Bedingungen mit den Eigenwerten der Matrix

, die d3 laut Definition 2.1.23 zu einer Abstiegsrichtung zweiter Ordnung macht. Dieser Zusammenhang wird noch klarer werden, wenn wir diese Bedingungen mit den Eigenwerten der Matrix  in Verbindung gebracht haben.

in Verbindung gebracht haben.

Das folgende Beispiel belegt, dass nicht jede Abstiegsrichtung entweder von erster oder von zweiter Ordnung ist.

2.1.26 Beispiel

Für jede Abstiegsrichtung zweiter Ordnung d ist offenbar auch ihre „Gegenrichtung“ −d eine Abstiegsrichtung zweiter Ordnung. Daher ist beispielsweise d = −1 für die Funktion f(x) = x3 an  zwar eine Abstiegsrichtung, aber weder von erster noch von zweiter Ordnung.

zwar eine Abstiegsrichtung, aber weder von erster noch von zweiter Ordnung.

Die per Formel für  explizitere Formulierung von Lemma 2.1.21 besagt, dass an einem lokalen Minimalpunkt

explizitere Formulierung von Lemma 2.1.21 besagt, dass an einem lokalen Minimalpunkt  von f notwendigerweise

von f notwendigerweise  und

und  für alle

für alle  gilt. In der linearen Algebra wird letztere Bedingung an die Matrix

gilt. In der linearen Algebra wird letztere Bedingung an die Matrix  positive Semidefinitheit

genannt und kurz mit

positive Semidefinitheit

genannt und kurz mit  bezeichnet. Damit erhalten wir aus Lemma 2.1.21 folgendes Resultat.

bezeichnet. Damit erhalten wir aus Lemma 2.1.21 folgendes Resultat.

2.1.27 Satz (Notwendige Optimalitätsbedingung zweiter Ordnung)

Die Funktion  sei zweimal differenzierbar an einem lokalen Minimalpunkt

sei zweimal differenzierbar an einem lokalen Minimalpunkt  . Dann gilt

. Dann gilt  und

und  .

.

Um Satz 2.1.27 praktisch anwenden zu können, muss die Bedingung  überprüfbar sein. Nach Definition der positiven Semidefinitheit wären dazu aber unendlich viele Ungleichungen zu garantieren. Glücklicherweise stellt die lineare Algebra eine Charakterisierung von positiver Semidefinitheit zur Verfügung, sofern die Matrix

überprüfbar sein. Nach Definition der positiven Semidefinitheit wären dazu aber unendlich viele Ungleichungen zu garantieren. Glücklicherweise stellt die lineare Algebra eine Charakterisierung von positiver Semidefinitheit zur Verfügung, sofern die Matrix  symmetrisch ist (d. h., es gilt

symmetrisch ist (d. h., es gilt  ). Nach dem aus der Analysis bekannten Satz von Schwarz (z. B. [18]) ist Letzteres der Fall, wenn f nicht nur zweimal differenzierbar, sondern sogar zweimal stetig differenzierbar ist (kurz:

). Nach dem aus der Analysis bekannten Satz von Schwarz (z. B. [18]) ist Letzteres der Fall, wenn f nicht nur zweimal differenzierbar, sondern sogar zweimal stetig differenzierbar ist (kurz:  ).

).

Es sei daran erinnert, dass λ ein Eigenwert

zum Eigenvektor

v ≠ 0 von  ist, wenn

ist, wenn  gilt (eine Motivation dafür wird z. B. im Anhang von [24] gegeben). Obwohl Eigenwerte im Allgemeinen komplexe Zahlen sein können, wird in der linearen Algebra gezeigt (z. B. [8, 20]), dass Eigenwerte symmetrischer Matrizen stets reell sind. Insbesondere kann man dann ihre Vorzeichen betrachten. Eine symmetrische Matrix ist in der Tat genau dann positiv semidefinit, wenn ihre sämtlichen Eigenwerte nichtnegativ sind (z. B. [8, 20]). Demnach dürfen wir für jede C2-Funktion f die Bedingung

gilt (eine Motivation dafür wird z. B. im Anhang von [24] gegeben). Obwohl Eigenwerte im Allgemeinen komplexe Zahlen sein können, wird in der linearen Algebra gezeigt (z. B. [8, 20]), dass Eigenwerte symmetrischer Matrizen stets reell sind. Insbesondere kann man dann ihre Vorzeichen betrachten. Eine symmetrische Matrix ist in der Tat genau dann positiv semidefinit, wenn ihre sämtlichen Eigenwerte nichtnegativ sind (z. B. [8, 20]). Demnach dürfen wir für jede C2-Funktion f die Bedingung  verifizieren, indem wir die n Eigenwerte der Matrix

verifizieren, indem wir die n Eigenwerte der Matrix  berechnen und auf Nichtnegativität überprüfen.

berechnen und auf Nichtnegativität überprüfen.

2.1.28 Beispiel

Alle drei Funktionen f1, f2 und f3 aus Beispiel 2.1.24 sind zweimal stetig differenzierbar an  , so dass die positive Semidefinitheit ihrer Hesse-Matrizen mit Hilfe der Eigenwerte geprüft werden kann. Von den drei Hesse-Matrizen ist nur

, so dass die positive Semidefinitheit ihrer Hesse-Matrizen mit Hilfe der Eigenwerte geprüft werden kann. Von den drei Hesse-Matrizen ist nur  positiv semidefinit. Daher kann man mit Satz 2.1.27 ausschließen, dass f2 und f3 an

positiv semidefinit. Daher kann man mit Satz 2.1.27 ausschließen, dass f2 und f3 an  lokale Minimalpunkte besitzen.

lokale Minimalpunkte besitzen.

Beispiel 2.1.28 zeigt, dass Satz 2.1.27 die Kandidatenmenge für lokale Minimalpunkte gegenüber der Fermat’schen Regel stark reduzieren kann. Darauf basiert der konzeptionelle Algorithmus 2.2, der im Vergleich zu Algorithmus 2.1 das entsprechend „feinere Sieb“ zum Einsatz bringt. Die drei Hauptnachteile von Algorithmus 2.1, nämlich die fehlende Identifizierung der Unlösbarkeit des Optimierungsproblems, die Notwendigkeit, die Kandidatenmenge K komplett zu berechnen, sowie die Schwierigkeit, überhaupt kritische Punkte zu bestimmen, werden auch durch Algorithmus 2.2 nicht ausgeräumt. Sein Vorteil gegenüber Algorithmus 2.1 ist die üblicherweise erheblich kleinere Menge K.

Algorithmus 2.2: Konzeptioneller Algorithmus zur unrestringierten nichtlinearen Minimierung mit Informationen zweiter Ordnung

Input : Lösbares unrestringiertes zweimal stetig differenzierbares Optimierungsproblem P

Output : Globaler Minimalpunkt  von f über

von f über

1 begin

2 Bestimme alle kritischen Punkte mit positiv semidefiniter Hesse-Matrix von f, d. h. die Lösungsmenge K der beiden Bedingungen  und

und  .

.

3 Bestimme einen Minimalpunkt  von f in K.

von f in K.

4 end

gilt ∇f4(0) = 0, und die Hesse-Matrix

gilt ∇f4(0) = 0, und die Hesse-Matrix

ist trotzdem kein lokaler Minimalpunkt von f. Dies führt auf die Frage nach einer hinreichenden Bedingung für lokale Minimalität.

ist trotzdem kein lokaler Minimalpunkt von f. Dies führt auf die Frage nach einer hinreichenden Bedingung für lokale Minimalität.Analog zu unseren bisherigen Betrachtungen ließe sich vermuten, dass f sicherlich dann einen lokalen Minimalpunkt an  besitzt, wenn für alle

besitzt, wenn für alle  die eindimensionale Einschränkung φd an

die eindimensionale Einschränkung φd an  einen lokalen Minimalpunkt besitzt. Die folgende Übung zeigt allerdings, dass diese Vermutung falsch ist.

einen lokalen Minimalpunkt besitzt. Die folgende Übung zeigt allerdings, dass diese Vermutung falsch ist.

2.1.29 Übung (Beispiel von Peano)

Zeigen Sie, dass die Funktion  zwar keinen lokalen Minimalpunkt bei

zwar keinen lokalen Minimalpunkt bei  besitzt, dass aber für jede Richtung

besitzt, dass aber für jede Richtung  die eindimensionale Einschränkung φd an

die eindimensionale Einschränkung φd an  einen lokalen Minimalpunkt aufweist.

einen lokalen Minimalpunkt aufweist.

Übung 2.1.29 illustriert einen Effekt, der für

univariate

Funktionen (also für n = 1) nicht auftreten kann: Der Funktionswert an  wird durch Funktionswerte an Punkten unterschritten, die nicht entlang einer Geraden durch

wird durch Funktionswerte an Punkten unterschritten, die nicht entlang einer Geraden durch  liegen, sondern entlang einer Parabel durch

liegen, sondern entlang einer Parabel durch  . In der Tat gilt in Übung 2.1.29 für die Richtung d, die an

. In der Tat gilt in Übung 2.1.29 für die Richtung d, die an  tangential zu dieser Parabel liegt,

tangential zu dieser Parabel liegt,  , während alle anderen Richtungen

, während alle anderen Richtungen  erfüllen.

erfüllen.

durch Informationen zweiter Ordnung zu garantieren, sollte man also ausschließen, dass für eine Richtung d nur

durch Informationen zweiter Ordnung zu garantieren, sollte man also ausschließen, dass für eine Richtung d nur  gilt. Dies ist (neben der notwendigerweise aufzustellenden Bedingung

gilt. Dies ist (neben der notwendigerweise aufzustellenden Bedingung  ) gleichbedeutend mit der Forderung, jede Richtung d sei Anstiegsrichtung zweiter Ordnung, also

) gleichbedeutend mit der Forderung, jede Richtung d sei Anstiegsrichtung zweiter Ordnung, also

bezeichnet wird, kurz

bezeichnet wird, kurz  . Falls die Hesse-Matrix wegen zweimaliger stetiger Differenzierbarkeit von f an

. Falls die Hesse-Matrix wegen zweimaliger stetiger Differenzierbarkeit von f an  symmetrisch ist, wird positive Definitheit dadurch charakterisiert, dass alle Eigenwerte von

symmetrisch ist, wird positive Definitheit dadurch charakterisiert, dass alle Eigenwerte von  strikt positiv sind (z. B. [8, 20]).

strikt positiv sind (z. B. [8, 20]).Der Beweis der resultierenden hinreichenden Optimalitätsbedingung zweiter Ordnung benutzt wieder den Satz von Taylor. Aus Übung 2.1.29 erschließt sich allerdings, dass univariate Versionen dieses Satzes, also Entwicklungen entlang von Geraden, nicht hilfreich sein werden.

Zum Glück lässt der Satz von Taylor sich auch im multivariaten Fall formulieren (ein Beweis wird z. B. in [16, 18] gegeben).

2.1.30 Satz (Entwicklungen erster und zweiter Ordnung per multivariatem Satz von Taylor)

- a)Es sei

differenzierbar in

differenzierbar in  . Dann gilt für alle

. Dann gilt für alle  wobei

wobei

einen Ausdruck der Form

einen Ausdruck der Form  mit

mit  bezeichnet.

bezeichnet. - b)Es sei

zweimal differenzierbar in

zweimal differenzierbar in  . Dann gilt für alle

. Dann gilt für alle  wobei

wobei

einen Ausdruck der Form

einen Ausdruck der Form  mit

mit  bezeichnet.

bezeichnet.

bezeichnen und mit

bezeichnen und mit

(wobei die Wahl der Norm

(wobei die Wahl der Norm  keine Rolle spielt).

keine Rolle spielt).2.1.31 Satz (Hinreichende Optimalitätsbedingung zweiter Ordnung)

Die Funktion  sei an

sei an  zweimal differenzierbar, und es gelte

zweimal differenzierbar, und es gelte  und

und  . Dann ist

. Dann ist  ein strikter lokaler Minimalpunkt von f.

ein strikter lokaler Minimalpunkt von f.

Beweis.

Der Beweis wird per Widerspruch geführt. Angenommen,  sei kein strikter lokaler Minimalpunkt von f. Falls

sei kein strikter lokaler Minimalpunkt von f. Falls  kein kritischer Punkt von f ist, liegt bereits ein Widerspruch vor, so dass wir im Folgenden

kein kritischer Punkt von f ist, liegt bereits ein Widerspruch vor, so dass wir im Folgenden  voraussetzen dürfen. Da

voraussetzen dürfen. Da  kein strikter lokaler Minimalpunkt ist, existiert per Definition 1.1.2 zu jeder Umgebung U von

kein strikter lokaler Minimalpunkt ist, existiert per Definition 1.1.2 zu jeder Umgebung U von  ein

ein  mit

mit  . Insbesondere existiert zu jeder Umgebung

. Insbesondere existiert zu jeder Umgebung  mit

mit  ein Punkt

ein Punkt  mit

mit  . Aus der speziellen Wahl der Umgebungen folgt außerdem

. Aus der speziellen Wahl der Umgebungen folgt außerdem  .

.

eine Nullfolge positiver Zahlen, die Richtungen

eine Nullfolge positiver Zahlen, die Richtungen

für alle

für alle  . Dass alle Richtungen dk normiert sind, bedeutet gerade, dass die Folge (dk) in der Einheitssphäre B = (0, 1) liegt. Da diese eine kompakte Menge ist, besitzt die Folge (dk) mindestens einen Häufungspunkt d ∈ B = (0, 1) (nach dem Satz von Bolzano-Weierstraß;

z. B. [18]). Nach Übergang zu einer entsprechenden Teilfolge erhalten wir die Existenz von Folgen (tk) und (dk) mit

. Dass alle Richtungen dk normiert sind, bedeutet gerade, dass die Folge (dk) in der Einheitssphäre B = (0, 1) liegt. Da diese eine kompakte Menge ist, besitzt die Folge (dk) mindestens einen Häufungspunkt d ∈ B = (0, 1) (nach dem Satz von Bolzano-Weierstraß;

z. B. [18]). Nach Übergang zu einer entsprechenden Teilfolge erhalten wir die Existenz von Folgen (tk) und (dk) mit  ,

,  ,

,  und

und

. Satz 2.1.30b liefert nun für alle

. Satz 2.1.30b liefert nun für alle

folgt im Grenzübergang also

folgt im Grenzübergang also

widerspricht dies aber der Voraussetzung

widerspricht dies aber der Voraussetzung  .

.2.1.32 Bemerkung

Die notwendigen Optimalitätsbedingungen erster und zweiter Ordnung lassen sich samt ihrer Beweise problemlos auf Funktionale auf Banach-Räumen  übertragen, also auf eine große Klasse unendlichdimensionaler Optimierungsprobleme. Die Verallgemeinerung hinreichender Bedingungen ist hingegen nur mit zusätzlichem Aufwand möglich. Hauptgrund hierfür ist, dass die Einheitssphäre in einem Banach-Raum nur in Spezialfällen kompakt ist (für Details s. z. B. [4, 19]).

übertragen, also auf eine große Klasse unendlichdimensionaler Optimierungsprobleme. Die Verallgemeinerung hinreichender Bedingungen ist hingegen nur mit zusätzlichem Aufwand möglich. Hauptgrund hierfür ist, dass die Einheitssphäre in einem Banach-Raum nur in Spezialfällen kompakt ist (für Details s. z. B. [4, 19]).

2.1.33 Übung

2.1.34 Bemerkung

Man kann sich fragen, warum es bei den Optimalitätsbedingungen zweiter Ordnung zwar eine notwendige und eine hinreichende Version gibt, bei den Bedingungen erster Ordnung aber nur die Fermat’sche Regel als notwendige Bedingung. Dazu sei daran erinnert, dass der Beweis der Fermat’schen Regel auf Lemma 2.1.6 für einseitig richtungsdifferenzierbare Funktionen basiert, also auf der Notwendigkeit von Stationarität für jeden lokalen Minimalpunkt. Im glatten Fall besagt dies, dass an einem lokalen Minimalpunkt  von f notwendigerweise die Ungleichungen

von f notwendigerweise die Ungleichungen  für alle

für alle  gelten.

gelten.

Würde man hier zur Konstruktion einer womöglich hinreichenden Optimalitätsbedingung erster Ordnung analog zu den Bedingungen zweiter Ordnung die nichtstrikte durch eine strikte Ungleichung ersetzen, erhielte man  für alle

für alle  . Diese Bedingung ist aber für keinen Vektor

. Diese Bedingung ist aber für keinen Vektor  erfüllbar und daher nutzlos.

erfüllbar und daher nutzlos.

Das Problem liegt dabei in der Glattheitsvoraussetzung an die Funktion f. Für lediglich einseitig richtungsdifferenzierbare Funktionen lässt sich sehr wohl zeigen, dass aus  für alle

für alle  die (strikte) lokale Minimalität von

die (strikte) lokale Minimalität von  für f folgt und dass diese Bedingung auch erfüllbar ist (z. B. für

für f folgt und dass diese Bedingung auch erfüllbar ist (z. B. für  und

und  ).

).

Für restringierte glatte Probleme werden wir in Korollar 3.2.68 wiederum eine hinreichende Optimalitätsbedingung erster Ordnung angeben können, weil (etwas lax formuliert) die dafür benötigte Nichtglattheit durch den Rand der zulässigen Menge bereitgestellt wird.

Da die hinreichende Bedingung aus Satz 2.1.31 etwas mehr liefert als gewünscht, nämlich sogar strikte lokale Minimalpunkte, kann man von ihr keine Charakterisierung lokaler Minimalität erwarten. Andererseits liefert diese hinreichende Bedingung auch keine Charakterisierung für strikte Minimalität, denn sie kann an strikten lokalen Minimalpunkten verletzt sein (z. B. für f(x) = x4 und  ).

).

Zwischen notwendigen und hinreichenden Optimalitätsbedingungen zweiter Ordnung klafft in diesem Sinne also eine Lücke. Die folgenden Ergebnisse zeigen allerdings, dass diese Lücke für „sehr viele“ Optimierungsprobleme keine Rolle spielt. Als Konsequenz daraus befassen wir uns weder mit Optimalitätsbedingungen noch mit Abstiegsrichtungen dritter und höherer Ordnung, obwohl sich diese mit Hilfe der entsprechenden Taylor-Entwicklungen durchaus angeben ließen. Für die folgende Definition sei daran erinnert, dass eine quadratische Matrix nichtsingulär heißt, wenn keiner ihrer Eigenwerte null ist.

2.1.35 Definition (Nichtdegenerierte kritische und Minimalpunkte)

Die Funktion  sei an

sei an  zweimal differenzierbar mit

zweimal differenzierbar mit  . Dann heißt

. Dann heißt

- a)

nichtdegenerierter kritischer Punkt , falls

nichtsingulär ist,

nichtsingulär ist, - b)

nichtdegenerierter lokaler Minimalpunkt , falls

lokaler Minimalpunkt und nichtdegenerierter kritischer Punkt ist.

lokaler Minimalpunkt und nichtdegenerierter kritischer Punkt ist.

Beispielsweise ist der Sattelpunkt  von

von  ein nichtdegenerierter kritischer Punkt, während der Sattelpunkt

ein nichtdegenerierter kritischer Punkt, während der Sattelpunkt  ein degenerierter kritischer Punkt von

ein degenerierter kritischer Punkt von  ist.

ist.

Nichtdegenerierte lokale Minimalpunkte lassen sich durch Eigenschaften von Gradient und Hesse-Matrix charakterisieren.

2.1.36 Lemma

Der Punkt  ist genau dann nichtdegenerierter lokaler Minimalpunkt von f, wenn

ist genau dann nichtdegenerierter lokaler Minimalpunkt von f, wenn  und

und  gilt.

gilt.

Beweis.

Für einen lokalen Minimalpunkt  gilt nach Satz 2.1.27

gilt nach Satz 2.1.27  und

und  . Wenn

. Wenn  außerdem nichtdegenerierter kritischer Punkt ist, dann besitzt

außerdem nichtdegenerierter kritischer Punkt ist, dann besitzt  keinen verschwindenden Eigenwert, ist also positiv definit.

keinen verschwindenden Eigenwert, ist also positiv definit.

Es seien andererseits  und

und  . Dann ist

. Dann ist  nach Satz 2.1.31 ein lokaler Minimalpunkt. Da eine positiv definite Matrix nichtsingulär ist, ist dieser lokale Minimalpunkt auch nichtdegeneriert.

nach Satz 2.1.31 ein lokaler Minimalpunkt. Da eine positiv definite Matrix nichtsingulär ist, ist dieser lokale Minimalpunkt auch nichtdegeneriert.

in einer passend gewählten Topologie auf dem Funktionenraum

in einer passend gewählten Topologie auf dem Funktionenraum  (die für die Definition einer Umgebung einer Funktion auch ihre ersten und zweiten Ableitungen berücksichtigt) eine offene Menge sein wird. Benutzt man dafür die starke Whitney-Topologie

(

(die für die Definition einer Umgebung einer Funktion auch ihre ersten und zweiten Ableitungen berücksichtigt) eine offene Menge sein wird. Benutzt man dafür die starke Whitney-Topologie

( -Topologie), dann gilt sogar das folgende Ergebnis, für dessen tiefliegenden Beweis wir auf [22] verweisen.

-Topologie), dann gilt sogar das folgende Ergebnis, für dessen tiefliegenden Beweis wir auf [22] verweisen.2.1.37 Satz

ist

ist  -offen und -dicht in

-offen und -dicht in  .

.

Im Sinne von Satz 2.1.37 ist es also eine schwache Voraussetzung, die Nichtdegeneriertheit eines kritischen Punkts und insbesondere die Nichtdegeneriertheit eines lokalen Minimalpunkts zu fordern.

auch nicht nur die Vorzeichen von Eigenwerten von

auch nicht nur die Vorzeichen von Eigenwerten von  wichtige Informationen enthalten, sondern auch deren tatsächlichen Werte. Dazu sei λ ein Eigenwert von

wichtige Informationen enthalten, sondern auch deren tatsächlichen Werte. Dazu sei λ ein Eigenwert von  , und d mit

, und d mit  sei ein zugehöriger Eigenvektor. Dann gilt

sei ein zugehöriger Eigenvektor. Dann gilt

interpretieren kann.

interpretieren kann.Zudem ist für symmetrische (n, n)-Matrizen aus der linearen Algebra bekannt, dass die n Eigenvektoren der n Eigenwerte paarweise orthogonal zueinander gewählt werden können (z. B. [8, 20]). Dadurch lässt sich die lokale Struktur von f um einen nichtdegenerierten kritischen Punkt sehr genau beschreiben.

von f mit

von f mit  gegeben, d. h.,

gegeben, d. h.,  besitzt (mindestens) einen negativen Eigenwert λ. Jeder zugehörige Eigenvektor d ist dann Abstiegsrichtung zweiter Ordnung, denn er erfüllt

besitzt (mindestens) einen negativen Eigenwert λ. Jeder zugehörige Eigenvektor d ist dann Abstiegsrichtung zweiter Ordnung, denn er erfüllt  und

und

2.1.38 Übung

Zeigen Sie, dass an einem nichtdegenerierten Sattelpunkt sowohl eine Abals auch eine Anstiegsrichtung zweiter Ordnung existieren.

2.1.5 Konvexe Optimierungsprobleme

Abschn. 2.1 hat mit Hilfe von ersten und zweiten Ableitungen einer Funktion Optimalitätsbedingungen für ihre lokalen Minimalpunkte angegeben. Da Ableitungen nur lokale Information über eine Funktion enthalten, kann man auch nicht mehr erwarten, sofern man nicht eine zusätzliche globale Eigenschaft der Funktion fordert. Eine solche ist die Konvexität. Da konvexe Optimierungsprobleme ausführlich in [33] behandelt werden, stellen wir im Folgenden nur einige wesentliche Resultate zusammen und verweisen für Beweise und weitergehende Überlegungen auf [33].

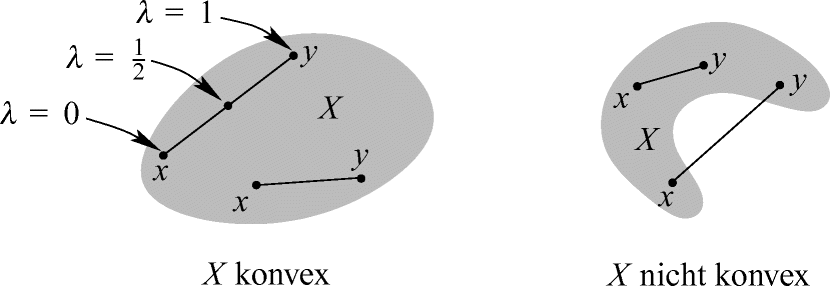

2.1.39 Definition (Konvexe Mengen und Funktionen)

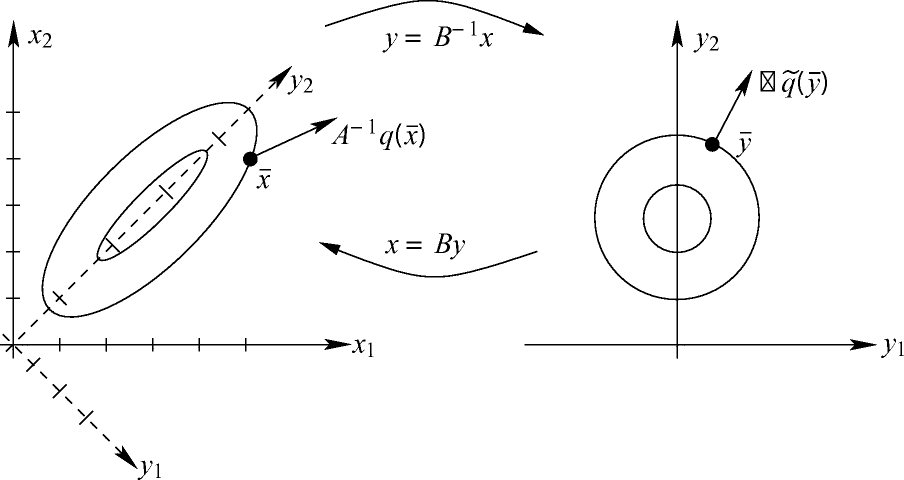

Konvexität von Mengen in

Konvexität von Funktionen auf

die Darstellung

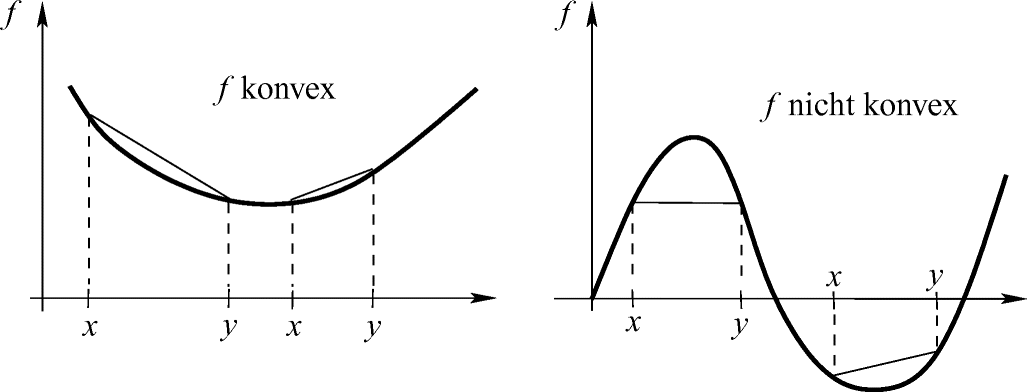

die Darstellung

und erhalten die (in y lineare) Funktion

und erhalten die (in y lineare) Funktion  als Approximation von f im Punkt x. Die angekündigte Charakterisierung von Konvexität stetig differenzierbarer Funktionen (kurz: f ∈ C1) lautet damit wie folgt.

als Approximation von f im Punkt x. Die angekündigte Charakterisierung von Konvexität stetig differenzierbarer Funktionen (kurz: f ∈ C1) lautet damit wie folgt.2.1.40 Satz ( -Charakterisierung von Konvexität)

-Charakterisierung von Konvexität)

ist eine Funktion

ist eine Funktion  genau dann konvex, wenn

genau dann konvex, wenn

Der zentrale Satz für stetig differenzierbare konvexe unrestringierte Optimierungsprobleme ist die folgende weitreichende Verschärfung der Fermat’schen Regel.

2.1.41 Korollar

Die Funktion  sei konvex. Dann sind die kritischen Punkte von f genau die globalen Minimalpunkte von f.

sei konvex. Dann sind die kritischen Punkte von f genau die globalen Minimalpunkte von f.

Beweis.

Das Problem der globalen Minimierung stetig differenzierbarer konvexer Funktionen ist also äquivalent zu einem Nullstellenproblem, nämlich zur Lösung der Gleichung ∇f(x) = 0.

Obwohl notwendige oder hinreichende Optimalitätsbedingungen zweiter Ordnung im konvexen Fall offenbar überflüssig sind, spielen Hesse-Matrizen dennoch eine wichtige Rolle, nämlich um ein einfaches Kriterium zum Nachweis der Konvexität zweimal stetig differenzierbarer Funktionen anzugeben.

2.1.42 Satz ( -Charakterisierung von Konvexität)

-Charakterisierung von Konvexität)

ist genau dann konvex, wenn

ist genau dann konvex, wenn

Zum Abschluss dieses Abschnitts betrachten wir für  einen nichtdegenerierten lokalen Minimalpunkt

einen nichtdegenerierten lokalen Minimalpunkt  von f, d. h., an ihm gelte

von f, d. h., an ihm gelte  . Wegen der Stetigkeit von D2f und der stetigen Abhängigkeit der Eigenwerte symmetrischer Matrizen von den Matrixeinträgen [36] gilt auch D2f(x) ≻ 0 für die x aus einer ganzen Umgebung von

. Wegen der Stetigkeit von D2f und der stetigen Abhängigkeit der Eigenwerte symmetrischer Matrizen von den Matrixeinträgen [36] gilt auch D2f(x) ≻ 0 für die x aus einer ganzen Umgebung von  . Nach Satz 2.1.42 ist f also lokal um den nichtdegenerierten lokalen Minimalpunkt

. Nach Satz 2.1.42 ist f also lokal um den nichtdegenerierten lokalen Minimalpunkt  konvex.

konvex.

2.1.43 Übung

mit

mit  und

und  . Zeigen Sie, dass q eine auf

. Zeigen Sie, dass q eine auf  konvexe Funktion ist und dass ihr eindeutiger Minimalpunkt

konvexe Funktion ist und dass ihr eindeutiger Minimalpunkt

Angemerkt sei, dass die Funktion q aus Übung 2.1.43 nach [33] sogar gleichmäßig konvex ist.

2.1.44 Übung

2.2 Numerische Verfahren

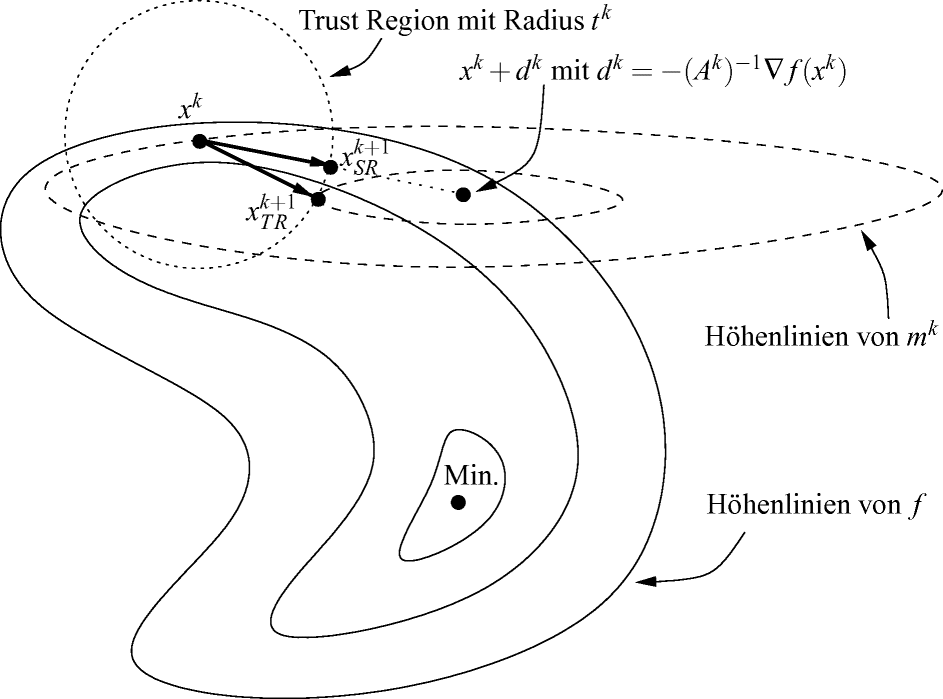

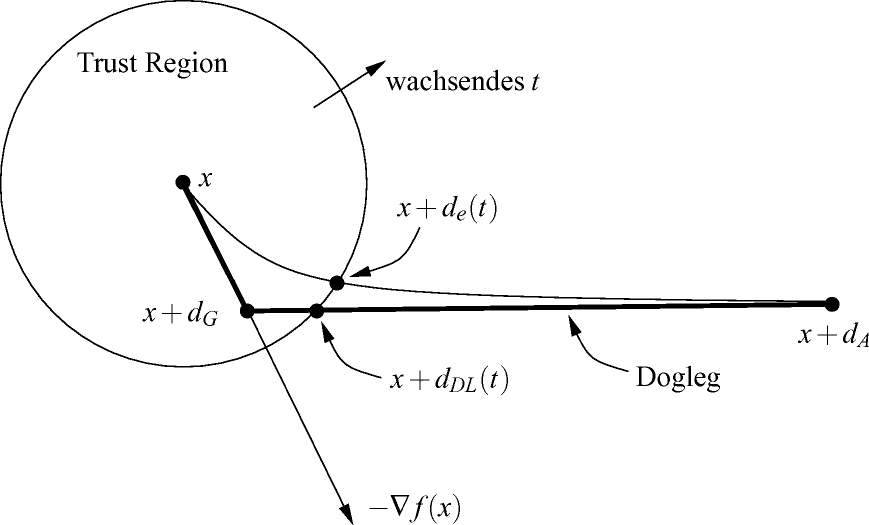

In diesem Abschnitt entwickeln wir numerische Verfahren zur Minimierung einer glatten Funktion  , wobei der vage Begriff „glatt“ bedeuten wird, dass die jeweils benötigten Stetigkeits- und Differenzierbarkeitsvoraussetzungen stets erfüllt sind. Alle vorgestellten Verfahren gehen von einem vom Benutzer bereitgestellten Startpunkt x0 aus und erzeugen daraus iterativ eine Folge (xk), deren Häufungspunkte zumindest kritische Punkte von f sind, also Nullstellen des Gradienten ∇f. Wir werden sehen, dass diese Folge unter gewissen Voraussetzungen sogar konvergiert, und dass ihr Grenzpunkt üblicherweise ein lokaler Minimalpunkt von f sein wird. Nicht erwarten kann man, so numerisch einen globalen Minimalpunkt von f zu finden, sofern nicht zusätzliche globale Informationen über f vorliegen. Für Verfahren der globalen Optimierung verweisen wir stattdessen auf [33].

, wobei der vage Begriff „glatt“ bedeuten wird, dass die jeweils benötigten Stetigkeits- und Differenzierbarkeitsvoraussetzungen stets erfüllt sind. Alle vorgestellten Verfahren gehen von einem vom Benutzer bereitgestellten Startpunkt x0 aus und erzeugen daraus iterativ eine Folge (xk), deren Häufungspunkte zumindest kritische Punkte von f sind, also Nullstellen des Gradienten ∇f. Wir werden sehen, dass diese Folge unter gewissen Voraussetzungen sogar konvergiert, und dass ihr Grenzpunkt üblicherweise ein lokaler Minimalpunkt von f sein wird. Nicht erwarten kann man, so numerisch einen globalen Minimalpunkt von f zu finden, sofern nicht zusätzliche globale Informationen über f vorliegen. Für Verfahren der globalen Optimierung verweisen wir stattdessen auf [33].

Abschn. 2.2.1 wird zunächst als sehr allgemeinen Rahmen ein sogenanntes Abstiegsverfahren einführen, ohne es bereits explizit auszugestalten. Trotzdem wird es möglich sein, hinreichende Bedingungen für das Terminieren dieses Verfahrens zu formulieren, die wir später für die explizit angegebenen Verfahren überprüfen können. Die neuen Iterierten werden dabei durch eine Kombination von Suchrichtungsvektoren und Schrittweiten entlang dieser Suchrichtungen generiert, und die genannten hinreichenden Bedingungen sind die sogenannte Gradientenbezogenheit der Suchrichtungsfolge sowie die Effizienz der Schrittweitenfolge. Abschn. 2.2.2 stellt drei Möglichkeiten zur Bestimmung effizienter Schrittweitenfolgen vor, die danach in den konkreten Abstiegsverfahren zum Einsatz kommen können.

In Abschn. 2.2.3 untersuchen wir die naheliegendste Wahl zur Konstruktion gradientenbezogener Suchrichtungsfolgen, was auf das Gradientenverfahren führt. Es erweist sich in der Praxis allerdings als sehr langsam, was wir zunächst durch die Einführung verschiedener Konvergenzgeschwindigkeiten quantifizieren. Mit der geometrischen Einsicht, dass der Hauptgrund für die Langsamkeit des Gradientenverfahrens in der mangelnden Verwertung von Krümmungsinformation der Zielfunktion liegt, modifizieren wir es in Abschn. 2.2.4 zur Klasse der Variable-Metrik-Verfahren.

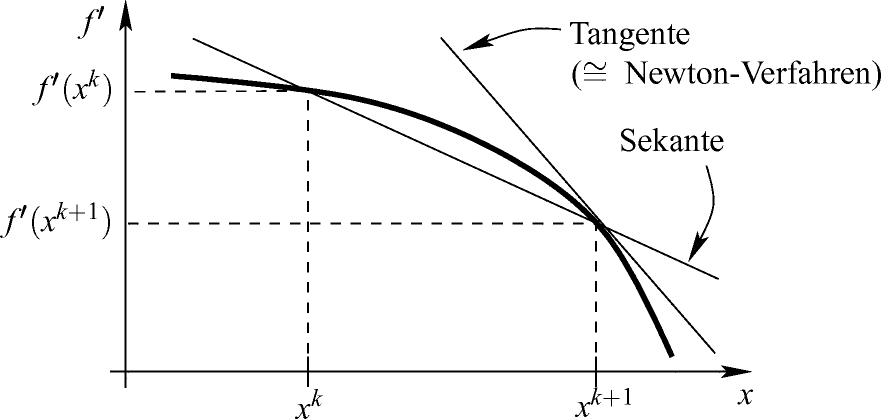

Ein wichtiger Vertreter dieser Verfahrensklasse ist das in Abschn. 2.2.5 besprochene Newton-Verfahren. Obwohl seine quadratische Konvergenzgeschwindigkeit sehr hoch ist, besitzt es den entscheidenden Nachteil, unter oft nur sehr unrealistischen Voraussetzungen ein Abstiegsverfahren zu sein. Wir modifizieren unseren Ansatz daher weiter und geben in Abschn. 2.2.6 zunächst sehr allgemeine Voraussetzungen an, unter denen Variable-Metrik-Verfahren wenigstens superlinear konvergieren, bevor Abschn. 2.2.7 darauf basierend die Quasi-Newton-Verfahren einführt.

Dass die Quasi-Newton-Verfahren auf Krümmungsinformation aus Approximationen der Hesse-Matrix der Zielfunktion angewiesen sind, kann bei hochdimensionalen Optimierungsproblemen zu Speicherplatzproblemen führen. Daher versuchen wir, das Gradientenverfahren auch durch matrixfreie Verfahren zu verbessern. Überraschenderweise lässt sich durch eine geschickte Kombination von Gradienteninformationen so viel Krümmungsinformation gewinnen, dass tatsächlich solche Verfahren existieren. Dies sind die auf dem in Abschn. 2.2.8 erklärten Konzept der konjugierten Richtungen basierenden und in Abschn. 2.2.9 eingeführten Konjugierte-Gradienten-Verfahren.

Abschn. 2.2.10 widmet sich abschließend den Trust-Region-Verfahren, die im Gegensatz zu den anderen besprochenen Abstiegsverfahren nicht zuerst eine Suchrichtung und dann eine Schrittweite, sondern erst einen Suchradius und dann die Richtung zur neuen Iterierten bestimmen.

2.2.1 Abstiegsverfahren

Neben der Stetigkeit der Zielfunktion f werden wir im gesamten Abschn. 2.2 fordern, dass die untere Niveaumenge  zum Startpunkt

zum Startpunkt  beschränkt ist. Falls diese Voraussetzung verletzt sein sollte, sind die vorgestellten Konvergenzbeweise nicht durchführbar, und die betrachteten Verfahren können dann nur als Heuristiken angesehen werden. Nach Lemma 1.2.26 ist die Voraussetzung aber zum Beispiel für jeden beliebigen Startpunkt x0 erfüllt, wenn f auf

beschränkt ist. Falls diese Voraussetzung verletzt sein sollte, sind die vorgestellten Konvergenzbeweise nicht durchführbar, und die betrachteten Verfahren können dann nur als Heuristiken angesehen werden. Nach Lemma 1.2.26 ist die Voraussetzung aber zum Beispiel für jeden beliebigen Startpunkt x0 erfüllt, wenn f auf  koerziv ist.

koerziv ist.

Als ersten Grund für die Einführung dieser Voraussetzung stellen wir fest, dass für beschränktes  eine stetige Funktion f nach Korollar 1.2.17 einen globalen Minimalpunkt besitzt und dass dann insbesondere die Gleichung ∇f(x) = 0 überhaupt lösbar ist.

eine stetige Funktion f nach Korollar 1.2.17 einen globalen Minimalpunkt besitzt und dass dann insbesondere die Gleichung ∇f(x) = 0 überhaupt lösbar ist.

2.2.1 Bemerkung

Für beschränktes  ist die Funktion f also nach unten beschränkt. In der Literatur wird für Konvergenzbeweise manchmal auch nur diese schwächere Voraussetzung benutzt. Allerdings wird die dadurch später getroffene Voraussetzung der Lipschitz-Stetigkeit des Gradienten ∇f auf

ist die Funktion f also nach unten beschränkt. In der Literatur wird für Konvergenzbeweise manchmal auch nur diese schwächere Voraussetzung benutzt. Allerdings wird die dadurch später getroffene Voraussetzung der Lipschitz-Stetigkeit des Gradienten ∇f auf  in vielen Anwendungen zu einer starken oder sogar unerfüllbaren Voraussetzung (s. dazu Bemerkung 2.2.11).

in vielen Anwendungen zu einer starken oder sogar unerfüllbaren Voraussetzung (s. dazu Bemerkung 2.2.11).

nicht notwendig invertierbar sein muss (und eventuell schwer auszuwerten) und dass das Newton-Verfahren auch gegen lokale Maximalpunkte und Sattelpunkte konvergieren kann.

nicht notwendig invertierbar sein muss (und eventuell schwer auszuwerten) und dass das Newton-Verfahren auch gegen lokale Maximalpunkte und Sattelpunkte konvergieren kann.

Ein allgemeines Abstiegsverfahren ist in Algorithmus 2.3 formuliert. In seinem Input sowie nachfolgend sprechen wir etwas lax von einem „C1-Optimierungsproblem P“, wenn die definierenden Funktionen von P stetig differenzierbar sind.

Aus theoretischer Sicht würde häufig sogar nur die Differenzierbarkeit genügen. In Anwendungen sind differenzierbare Funktionen aber typischerweise auch stetig differenzierbar, so dass diese Voraussetzung üblich ist und keine entscheidende Einschränkung darstellt.

Algorithmus 2.3: Allgemeines Abstiegsverfahren

Input : C1-Optimierungsproblem P

Output : Approximation  eines kritischen Punkts von f (falls das Verfahren terminiert; Korollar 2.2.10)

eines kritischen Punkts von f (falls das Verfahren terminiert; Korollar 2.2.10)

1 begin

2 Wähle einen Startpunkt x0, eine Toleranz  und setze

und setze  .

.

3 While  do

do

4 Wähle  mit

mit  .

.

5 Ersetze k durch  .

.

6 end

7 Setze  .

.

8 end

Verschiedene Abstiegsverfahren unterscheiden sich durch die Wahl von xk + 1 in Zeile 4 von Algorithmus 2.3. Im Folgenden werden wir zunächst unabhängig von der speziellen Ausgestaltung der Zeile 4 schwache Bedingungen an die Wahl von xk + 1 herleiten, die garantieren, dass Algorithmus 2.3 tatsächlich nach endlich vielen Schritten terminiert.

Für den Fall, in dem diese schwachen Bedingungen verletzt sind, versieht man Algorithmus 2.3 häufig noch mit einer „Notbremse“, nämlich mit dem zusätzlichen Abbruchkriterium  mit einer hohen Iterationszahl

mit einer hohen Iterationszahl  (wie etwa

(wie etwa  ). Vom Output

). Vom Output  kann man dann natürlich nicht erwarten, einen kritischen Punkt von f zu approximieren, aber immerhin erfüllt er die Ungleichung

kann man dann natürlich nicht erwarten, einen kritischen Punkt von f zu approximieren, aber immerhin erfüllt er die Ungleichung  . Zur Übersichtlichkeit werden wir im Folgenden auf die explizite Betrachtung der „Notbremse“ verzichten.

. Zur Übersichtlichkeit werden wir im Folgenden auf die explizite Betrachtung der „Notbremse“ verzichten.

2.2.2 Bemerkung

In der Praxis ist man manchmal schon damit zufrieden, irgendeinen Punkt  mit besserem Zielfunktionswert als x0 zu finden, also mit

mit besserem Zielfunktionswert als x0 zu finden, also mit  . Dafür genügen offenbar endlich viele Schritte jedes Abstiegsverfahrens (wie auch bei Verbesserungsheuristiken [24]), ohne dass das Abbruchkriterium in Zeile 3 erfüllt zu sein braucht. Die Implementierung der oben beschriebenen „Notbremse“ liefert bei jedem Abstiegsverfahren garantiert einen solchen Output

. Dafür genügen offenbar endlich viele Schritte jedes Abstiegsverfahrens (wie auch bei Verbesserungsheuristiken [24]), ohne dass das Abbruchkriterium in Zeile 3 erfüllt zu sein braucht. Die Implementierung der oben beschriebenen „Notbremse“ liefert bei jedem Abstiegsverfahren garantiert einen solchen Output  .

.

In Zeile 3 des allgemeinen Abstiegsverfahrens 2.3 testet man als Abbruchkriterium  mit einer Toleranz ɛ > 0, da man nicht erwarten kann, numerisch einen kritischen Punkt exakt zu bestimmen (eine While-Schleife zur Bedingung

mit einer Toleranz ɛ > 0, da man nicht erwarten kann, numerisch einen kritischen Punkt exakt zu bestimmen (eine While-Schleife zur Bedingung  würde in den meisten Fällen also nie abbrechen). Der generierte Output

würde in den meisten Fällen also nie abbrechen). Der generierte Output  mit

mit  ist dann natürlich nur die Approximation eines kritischen Punkts.

ist dann natürlich nur die Approximation eines kritischen Punkts.

Um zu garantieren, dass Algorithmus 2.3 nach endlich vielen Iterationen terminiert, muss man nachweisen können, dass unabhängig von der Wahl von ɛ ein  mit

mit  existiert. Dies ist sicher dann gewährleistet, wenn die Folge (∇f(xk)) gegen den Nullvektor konvergiert. Es genügt aber beispielsweise auch, dass diese Folge den Nullvektor lediglich als Häufungspunkt besitzt. Da andererseits für vorgegebenes ɛ > 0 im Fall der Terminierung von Algorithmus 2.3 gar keine unendliche Folge erzeugt werden würde, werden wir für die folgenden Konvergenzuntersuchungen künstlich ɛ = 0 setzen und von den erhaltenen Resultaten auf die endliche Terminierung im Fall ɛ > 0 schließen.

existiert. Dies ist sicher dann gewährleistet, wenn die Folge (∇f(xk)) gegen den Nullvektor konvergiert. Es genügt aber beispielsweise auch, dass diese Folge den Nullvektor lediglich als Häufungspunkt besitzt. Da andererseits für vorgegebenes ɛ > 0 im Fall der Terminierung von Algorithmus 2.3 gar keine unendliche Folge erzeugt werden würde, werden wir für die folgenden Konvergenzuntersuchungen künstlich ɛ = 0 setzen und von den erhaltenen Resultaten auf die endliche Terminierung im Fall ɛ > 0 schließen.

Zunächst untersuchen wir, ob die Iterierten xk selbst sowie ihre Funktionswerte konvergieren.

2.2.3 Lemma

Für beschränktes  bricht die von Algorithmus 2.3 mit ɛ = 0 erzeugte Folge (xk) entweder nach endlich vielen Schritten mit einem kritischen Punkt ab, oder sie besitzt mindestens einen Häufungspunkt in