6

Concurrence libre et très faussée

Si l’on admet le constat que la qualité des articles scientifiques se dégrade, constat fondé sur la multiplication des découvertes de fraudes massives dans toutes les disciplines (voir chapitre 1), l’explosion du nombre de rétractations d’articles en biologie (chapitre 2), les preuves statistiques que les résultats sont de plus en plus embellis en psychologie expérimentale (chapitre 4), ou encore l’inquiétante impossibilité de reproduire la grande majorité des expériences publiées en biomédecine (chapitre 5), reste à en chercher les causes. Que se passe-t-il donc ? Que s’est-il donc passé ? Qu’y a-t-il, pour paraphraser Shakespeare, de pourri dans le royaume de la science ?

Une hypothèse optimiste

Le sociologue des sciences Daniele Fanelli, dont nous avons déjà souvent cité les travaux, est un des chercheurs qui ont le plus contribué ces dernières années à mettre au jour, par de patientes analyses bibliométriques, la multiplication des fraudes, des embellissements de données et autres inavouables arrangements avec la rigueur scientifique. Mais si le nombre de rétractations explose, a-t-il dernièrement soutenu43, c’est que la communauté scientifique serait de plus en plus vigilante à l’égard des manquements à l’intégrité scientifique. S’il y a plus de malades, c’est que l’on serait de plus en plus exigeant quant à la santé, plaide-t-il en substance.

Avec cette thèse, fort populaire dans la communauté scientifique qui y voit un bon moyen de se dédouaner de toute responsabilité, nous sommes en profond désaccord. Rien n’incite à penser que les relecteurs des revues soient devenus de plus en plus critiques. Sinon, comment expliquer que les revues qui ont les taux de rejet des manuscrits soumis les plus élevés, ce qui laisse à penser qu’elles sont les plus exigeantes, soient aussi celles qui ont les taux de rétractation d’articles pour fraude les plus élevés ? Les arguments de Fanelli sont aussi indirects que spécieux.

Premièrement, il montre que la proportion d’articles scientifiques ayant fait l’objet d’un erratum (une procédure qui permet de corriger un point de l’article tout en maintenant ses conclusions d’ensemble) est stable depuis 1980 alors que la proportion d’articles rétractés augmente de 20 % par an. Si la rigueur scientifique se dégrade vraiment, raisonne Fanelli, on devrait s’attendre que la fréquence des errata progresse aussi vite que celle des rétractations. Pourquoi pas ? Mais on peut tout aussi bien soutenir que l’embellissement des données est devenu tellement massif qu’il rend impossible, lorsqu’il est découvert, de rectifier un article avec un simple erratum.

Deuxièmement, Fanelli relève que la proportion de revues publiant chaque année des rétractations augmente, mais que le nombre de rétractations par revue ne progresse que très lentement. C’est donc, à l’en croire, signe que les éditeurs de revues sont de plus en plus fréquemment disposés à reconnaître qu’ils ont admis des articles faux ou frauduleux, mais que ces derniers ne sont pas plus nombreux. Mais à examiner attentivement les courbes qu’il présente, on constate que le nombre moyen de rétractations par revue s’est tout de même accru de 40 % entre 1992 et 2012.

Troisièmement, il relève que le nombre d’enquêtes menées par l’Office for Research Integrity (ORI) américain, un organisme chargé de la lutte contre la fraude au sein des NIH sur lequel nous reviendrons longuement au chapitre 13, concluant à un manquement grave à la rigueur scientifique, est stable depuis sa création en 1992. Mais tous les criminologues savent bien que les statistiques policières, qui ne mesurent fondamentalement que l’activité de la police, sont un bien mauvais moyen d’appréhender l’évolution de la délinquance. Comme l’écrit un expert en la matière, le sociologue Laurent Mucchielli, « une fois pour toutes, il faut abandonner l’idée que, en matière de délinquance, la lumière nous viendra des statistiques de l’administration. C’est non seulement une paresse intellectuelle, mais de surcroît une cause de grave fourvoiement dans la compréhension des phénomènes44 ». Si l’ORI démontre moins de fraude, c’est peut-être que les fraudeurs sont devenus plus astucieux, qu’ils sont moins dénoncés, ou que l’ORI manque de moyens pour les confondre. Du reste, les responsables de cette institution reconnaissent volontiers que leur activité ne porte que sur une fraction infime des fabrications, falsifications et plagiats de données, comme on le verra au chapitre 13.

Multicentrisme

La véritable cause de l’explosion des malversations scientifiques nous semble plutôt à rechercher du côté de l’accroissement de la compétition internationale, dans un contexte de généralisation, de par le monde, de l’évaluation des chercheurs selon le seul critère du prestige de leurs publications. Daniele Fanelli, du reste, ne nie pas l’importance de cette explication, mais la cantonne aux embellissements de données. Il écrit dans son article que l’on vient de commenter :

Comme les athlètes professionnels qui s’efforcent de tirer le maximum de tout ce qui peut améliorer leurs performances, mais en restant dans les limites fixées par les règles antidopage, les scientifiques pourraient bien avoir progressé dans l’art de « pousser » leurs résultats dans la direction voulue en s’arrêtant juste en dessous du seuil définissant la fraude. Ou dans celui d’éviter d’être pris s’ils le franchissent.

La recherche scientifique a de tout temps été une activité très compétitive. Le renom, les récompenses, la postérité vont au premier à décrire un phénomène, à formuler une théorie. L’usage est assurément regrettable. Il est tout aussi important pour la solidité de l’édifice du savoir de reproduire une expérience, de confirmer une théorie, que d’être le premier à la faire, à la formuler. La confirmation par une autre équipe montre en effet la solidité de la thèse. L’usage du winner takes all (« le vainqueur prend tout »), comme le disent les scientifiques américains, est cependant ancien. Souvenons-nous de la rivalité entre Isaac Newton et Gottfried Wilhelm von Leibniz à propos du calcul infinitésimal au début du XVIIIe siècle, entre Louis Pasteur et Robert Koch dans la naissance de la microbiologie au XIXe siècle, ou entre les équipes de Frédéric Joliot et Otto Hahn en 1939 pour établir la possibilité théorique d’une réaction en chaîne par fission d’un atome lourd. Si ancien qu’il semble utopique d’envisager d’y mettre fin. L’enjeu de cette concurrence n’est rien moins que la postérité de son nom, qui restera pendant des siècles indissociable dans le langage commun de l’objet de sa découverte. Un phénomène (mouvement brownien, évolution darwinienne, maladie d’Alzheimer…), un objet céleste (comète de Halley) ou naturel (bacille de Koch), une sous-discipline (algèbre booléenne), une valeur (constante de Planck), une unité de mesure (Watt, Joule, Volt, etc.) porteront pendant des siècles votre nom, et l’on pourrait poursuivre longuement la liste des exemples. Cette excitation à être le premier, et donc à le rester pour toujours, est inhérente à la libido scientifique, même si très peu nombreux sont évidemment les chercheurs qui parviennent à attacher leur nom à une théorie ou une découverte.

L’intensité de cette concurrence inhérente à l’activité scientifique varie cependant selon les époques. Une chose est d’avoir un concurrent attitré, une sorte d’ennemi préféré, une autre est d’en avoir des dizaines. Or, les pays émergents ne cessent, depuis le début des années 1990, de monter en puissance dans le monde scientifique. Les chercheurs américains avaient pris l’habitude d’avoir une poignée de concurrents en Europe et réciproquement, avec ici ou là quelques sérieux outsiders japonais. Voici qu’ils s’en découvrent de nouveaux au Brésil, en Afrique du Sud, en Inde, tous pays dont la place sur la scène scientifique mondiale ne cesse de s’accroître. Et surtout en Chine. Et par dizaines.

Quelques chiffres illustrent le bouleversement du paysage scientifique mondial par l’irruption des chercheurs chinois. En 1991, la Chine était la cinquième puissance scientifique mondiale en termes de nombre d’articles publiés dans des revues anglophones. Elle est aujourd’hui la deuxième, derrière les États-Unis. Dans les revues indexées par le Web of Science, qui regroupe, toutes disciplines confondues, les publications les plus influentes, les articles d’auteurs chinois étaient au nombre de 41 417 en 2002 et de 193 733 en 2013. Une progression stupéfiante, mais qui n’est qu’un pâle reflet de la rapidité de l’expansion chinoise. Sur la même période, le PIB de l’empire du Milieu a été multiplié par 6,5 alors que le nombre d’articles d’auteurs chinois dans les revues anglophones ne l’a été que par 4,6. Si l’on extrapole les courbes, la Chine deviendra en 2022 la première puissance scientifique mondiale. Certes, la croissance est plus quantitative que qualitative. Deuxième en nombre d’articles publiés, la Chine n’était en 2013 que quatorzième quant au nombre de citations des articles de ses chercheurs. Mais, sur ce plan aussi, des progrès spectaculaires sont faits : les articles signés ou cosignés de scientifiques travaillant en Chine dans les prestigieuses publications du groupe Nature étaient au nombre de 89 en 2008 et de 303 – quasiment un par semaine – quatre ans plus tard. Encore faut-il noter que ces quelques chiffres ne tiennent compte que des articles publiés en anglais. Dans le domaine biomédical, il existe ainsi trois bases de données bibliographiques en langue chinoise, plus grosses que Medline, la base de données de référence en anglais. Elles forment une sorte de terra incognita du savoir en la matière pour le reste de la communauté scientifique internationale.

Publier plus pour gagner plus

La République populaire de Chine se dit toujours officiellement communiste. L’organisation de la recherche y est pourtant, constat qui vaut dans bien d’autres domaines, des moins communistes. La carrière des chercheurs est en effet directement indexée sur leur liste de publications. Dans la plupart des cas, seul importe le nombre d’articles. Mais dans certaines institutions de recherche, les plus prestigieuses, le facteur d’impact (défini, rappelons-le, par la moyenne sur les deux dernières années du nombre de citations des articles parus) des revues dans lesquelles ils publient est aussi pris en compte tant pour la promotion que pour la rémunération. Publier dans Nature, Science ou Proceedings of the National Academy of Sciences USA, aux facteurs d’impact supérieurs à 30, vaut au chercheur une prime immédiate se chiffrant en dizaines de milliers d’euros. L’URSS de la guerre froide, grande puissance scientifique elle aussi, accordait les meilleures conditions de vie à ses scientifiques. Mais elle n’était jamais allée jusqu’à évaluer l’activité de ses chercheurs sur la base de l’impact de leurs publications dans l’autre monde capitaliste. Cette rémunération des chercheurs en fonction du prestige de leurs publications mesuré à l’aune du Thomson Reuters Science Citation Index (SCI), qui calcule chaque année les facteurs d’impact, nous semble un puissant facteur fraudogène.

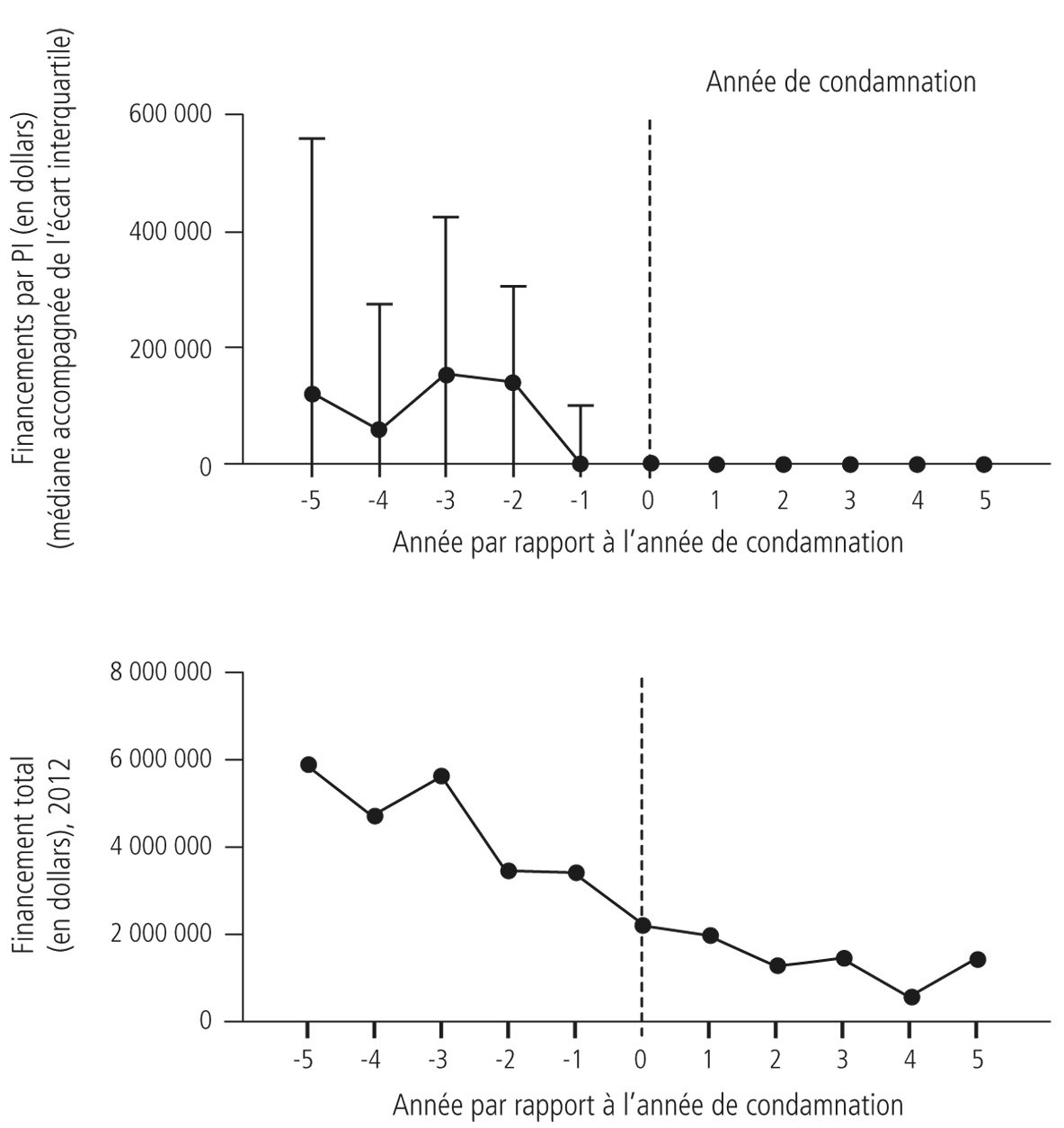

Les chercheurs reconnus coupables de fraude par l’Office of Research Integrity (ORI) américain connaissaient de sérieuses difficultés de financement plusieurs années avant leur condamnation. Ces soucis les auraient-ils conduits à prendre des libertés avec l’intégrité pour redorer leur blason scientifique ? Source : D’après Steen et al., 2013.

Force est de reconnaître que la Chine ne fait, en la matière, qu’assumer franchement ce que l’Europe et les États-Unis pratiquent implicitement. Certes, la rémunération n’y est pas directement indexée sur l’impact des publications, mais le recrutement, les promotions de carrière, les financements dépendent nettement, depuis les années 1990, de la liste de publications des chercheurs. L’angoisse de ne plus avoir de financement pour son laboratoire est certainement un puissant facteur poussant les chercheurs à la faute. L’étude du budget de l’équipe de 79 chercheurs des NIH sanctionnés pour fraude montre qu’ils connaissaient déjà de sérieuses difficultés financières dans les cinq années précédant leur sanction45.

Cette volonté de publier à tout prix, fût-il celui de la fraude, peut se comprendre. Le fonctionnement du monde scientifique obéit à ce que le sociologue des sciences Robert Merton, sur lequel nous reviendrons au chapitre 15, appelait plaisamment « l’effet Matthieu ». Une des paraboles rapportées par l’évangéliste est en effet que l’on « donnera à celui qui a, et il sera dans l’abondance, mais à celui qui n’a pas, on ôtera même ce qu’il a ». Soit une très exacte description du système d’allocation des financements dans la recherche : ceux qui publient beaucoup et dans des revues prestigieuses sont les premiers servis en termes de financement et de récompenses, les miettes allant à leurs collègues – la majorité – qui mènent des recherches moins visibles, mais certainement pas moins utiles. Il en va de même pour les rémunérations symboliques que sont les citations : on cite toujours bien plus volontiers un prix Nobel qu’un chercheur inconnu, même si leurs contributions sont d’égales importances.

Les États-Unis ont presque toujours connu ce système de financement ultracompétitif, qui récompense en priorité les plus dotés. Si l’expression publish or perish a un sens, c’est bien outre- Atlantique : un chercheur qui n’obtient pas de financement sera en effet souvent dans l’incapacité non seulement de mener des recherches, mais aussi de se payer, ce qui le conduira vite à changer de carrière. L’intensité de cette compétition ne cesse de se renforcer dans le domaine biomédical. Le taux de réponses positives aux demandes de financement déposées aux NIH décline ainsi avec constance. De 33 % en 1976, il est passé à 16 % en 2013, taux historiquement le plus faible de l’histoire de l’institution, avant de regagner deux points l’année suivante. La National Science Foundation, autre grande agence de financement de la recherche aux États-Unis mais couvrant l’ensemble de l’activité scientifique, n’a pas connu cette évolution, avec un taux constant d’environ un quart de réponses positives depuis dix ans. Si le secteur biomédical est le plus touché par la fraude, c’est sans doute aussi du fait que l’accès au financement des recherches y devient de plus en plus difficile.

Ce financement de la recherche par projets a longtemps été une spécificité des États-Unis. Depuis les années 1990, il s’est répandu dans le monde, et notamment en Chine. La France ne fait pas exception. Jusqu’aux années 1990, chaque laboratoire recevait l’essentiel de son financement de l’organisme de recherche (CNRS, Inserm, CEA, Inra, etc.) auquel il était rattaché. Ces financements, aujourd’hui nostalgiquement qualifiés de « récurrents » ont fondu comme neige au soleil. Pour lancer une expérience, tester une hypothèse, voire, de plus en plus souvent, recruter le personnel nécessaire, un chercheur français doit aujourd’hui passer sous les fourches caudines de l’Agence nationale de la recherche (ANR), qui lui accordera, ou non, un financement. Avec un taux de succès, là encore, qui ne cesse de décroître : 26 % à la création de l’ANR en 2005, 9 % en 2014.

Un chercheur doit donc, pour exercer son métier, démontrer en permanence sa compétence. C’est-à-dire publier. De plus en plus.

Comme le souligne Martine Bungener, économiste de la santé qui a dirigé pendant dix ans la Délégation à l’intégrité scientifique de l’Inserm, première institution française chargée de traiter des questions de fraude et autres manquement à l’intégrité scientifique (voir chapitre 14) :

Les chercheurs publient très vite, trop vite. La course à la publication oblige à créer des stratégies pour publier dans les meilleures revues, que tout le monde est obligé de mettre en œuvre. D’où une grande difficulté : où placer le curseur de l’intégrité scientifique dans un système qui pousse en permanence à l’enfreindre ? On apprend aujourd’hui davantage aux jeunes chercheurs à publier qu’à être rigoureux. On leur apprend l’art de répondre par avance aux objections des referees.

Hyperproductivité

On a vu au chapitre 4 que les chercheurs semblaient être devenus, en une trentaine d’années, de plus en plus sagaces et perspicaces, ne formulant que des hypothèses que la confrontation à l’expérience confirmait presque à coup sûr. Mais les chercheurs semblent de surcroît avoir de plus en plus de ces idées martingales. La productivité scientifique est en progression rapide. Le nombre de publications annuelles par chercheur s’est accru de manière frappante depuis vingt ans.

On le constate dans des études consacrées à un champ disciplinaire, par exemple la physique appliquée46, mais tout autant si l’on se focalise sur un pays. Les chercheurs des quatre universités que compte la Norvège publiaient ainsi 30 % de plus d’articles par an en 2002 qu’en 198247. Dans au moins un cas, celui de l’Australie, cet accroissement de la productivité a pu être relié à une réforme visant à développer le financement par projets, une longue liste de publications augmentant les chances d’être financé. Dans ce pays, suite à l’adoption de cette réforme, les chercheurs ont publié davantage, mais dans des revues de moindre facteur d’impact. Confrontés à l’absurde injonction de publier plus, les chercheurs australiens ont choisi d’y répondre en publiant moins bien, en faisant deux petits articles vite oubliés là où ils auraient pu en faire un gros longtemps cité48. Ironiser sur la PPQP (Plus Petite Quantité Publiable) était il y a quelques décennies un classique de la vie des laboratoires. La plaisanterie ne fait plus rire aujourd’hui, tant la course à la PPQP s’est installée dans le quotidien de la recherche.

La propension à l’hyperpublication ne frappe qu’une minorité du monde scientifique. Pour ne prendre qu’un exemple, 99 % des quelque 163 993 chercheurs de par le monde travaillant sur l’épilepsie, la polyarthrite rhumatoïde et les transplantations rénales et hépatiques publient moins de 20 articles par an. Mais pour chacun de ces domaines, on trouve quelques dizaines de chercheurs publiant plus de 50 articles par an, avec des pointes à 140, soit un article tous les trois jours49. À notre connaissance, le record mondial de la productivité scientifique est détenu par le chimiste Alan R. Katritzky, récemment décédé. Entre 1953 et 2010, il a cosigné 2 215 publications, soit une tous les dix jours de sa longue carrière qui l’a conduit de son Royaume-Uni natal à l’université de Floride. Mais feu Alan Katritzky pourrait perdre bientôt son titre, tant de nombreux chercheurs en biomédecine semblent décidés à le détrôner. Entre 1996 et 2011, dix auteurs travaillant dans ce domaine ont publié plus de 1 000 articles, soit 6 par mois en moyenne50. Un chiffre à peine croyable. La France compte même le vice- recordman mondial de ce sport, le microbiologiste Didier Raoult de l’université d’Aix-Marseille, avec 1 252 articles sur la période considérée, auxquels sont venus d’ajouter depuis quelque 800 autres. S’étonnera-t-on d’apprendre que la réputation de notre champion national est pour le moins controversée ? Que beaucoup pensent que ses innombrables travaux sont publiés trop vite, sans prendre le temps de toutes les vérifications nécessaires ? L’American Society for Microbiology l’a, par exemple, interdit de publication pendant un an dans les nombreuses revues éditées par la société savante, après la découverte dans un manuscrit soumis par l’équipe de Raoult de figures identiques supposées décrire des expériences différentes51.

Comment croire qu’un scientifique puisse participer réellement à des recherches débouchant sur quasiment une publication par semaine ? De deux choses l’une. Soit, mandarinat aidant, il ajoute son nom à tout travail issu du laboratoire qu’il dirige, une pratique hélas banale. Soit ses articles peuvent être légitimement suspectés d’être bâclés. L’un n’exclut du reste pas l’autre. Dans les deux cas, on ne peut que s’inquiéter de cette inflation du nombre de publications par chercheur, dont le cas de Didier Raoult, qui reconnaît du reste ne pas relire les manuscrits comportant sa signature avant soumission52, n’est que l’exemple le plus énorme.